王小川大模型首亮相!70亿参数霸榜,清北抢先用

source link: https://tech.sina.com.cn/csj/2023-06-15/doc-imyxkakr3371446.shtml

Go to the source link to view the article. You can view the picture content, updated content and better typesetting reading experience. If the link is broken, please click the button below to view the snapshot at that time.

王小川大模型首亮相!70亿参数霸榜,清北抢先用

2023-06-15 13:37:21 创事记 微博 作者: 新智元 我有话说(0人参与)

新智元报道

编辑:好困 桃子

【新智元导读】今天,百川智能正式发布70亿参数开源中英文大模型——baichuan-7B,一举拿下多个评测榜单最佳成绩。

时隔两个月,王小川组建的‘百川智能’在6月15日正式推出首个70亿参数中英文预训练大模型——baichuan-7B。

baichuan-7B不仅在C-Eval、AGIEval和Gaokao中文权威评测榜单上,以显著优势全面超过了ChatGLM-6B等其他大模型,并且在MMLU英文权威评测榜单上,大幅领先LLaMA-7B。

目前baichuan-7B大模型已在Hugging Face、Github以及Model Scope平台发布。

Hugging Face:https://huggingface.co/baichuan-inc/baichuan-7B

Github:https://github.com/baichuan-inc/baichuan-7B

Model Scope:https://modelscope.cn/models/baichuan-inc/baichuan-7B/summary

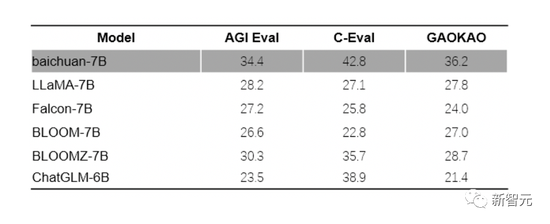

多个中文评估基准拿下7B最佳

为了验证模型的各项能力,baichuan-7B在C-Eval、AGIEval和Gaokao三个最具影响力的中文评估基准进行了综合评估,并且均获得了优异成绩,它已经成为同等参数规模下中文表现最优秀的原生预训练模型。

在AGIEval的评测里,baichuan-7B综合评分达到34.4分,远超LLaMA-7B、Falcon-7B、Bloom-7B以及ChatGLM-6B等其他开源模型。

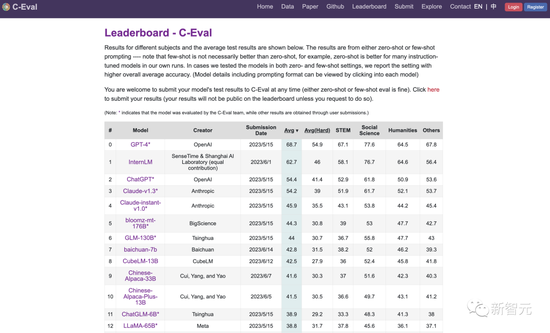

在中文C-EVAL的评测中,baichuan-7B的综合评分达到了42.8分,超过了ChatGLM-6B的38.9分,甚至比某些参数规模更大的模型还要出色。

在Gaokao评测中,baichuan-7B的综合评分达到了36.2分,显著领先于同参数规模的各种其他预训练模型。

https://cevalbenchmark.com/static/leaderboard_zh.html(2023-06-15)

AGIEval评测基准由微软研究院发起,旨在全面评估基础模型在人类认知和问题解决相关任务上的能力,包含了中国的高考、司法考试,以及美国的SAT、LSAT、GRE和GMAT等20个公开且严谨的官方入学和职业资格考试。

C-Eval评测基准由上海交通大学、清华大学以及爱丁堡大学联合创建,是面向中文语言模型的综合考试评测集,覆盖了52个来自不同行业领域的学科。

Gaokao评测基准是复旦大学研究团队创建的评测框架,以中国高考题目作为数据集,用于测试大模型在中文语言理解和逻辑推理能力方面的表现。

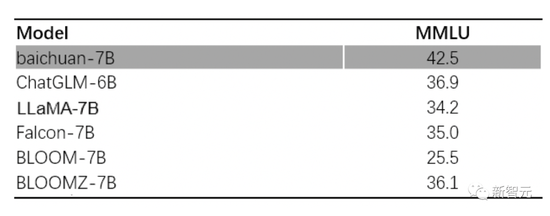

MMLU基准大幅领先LLaMA-7B

baichuan-7B不仅在中文方面表现优异,在英文上表现同样亮眼。

在MMLU的评测中baichuan-7B综合评分高达42.5分,大幅领先英文开源预训练模型LLaMA-7B的34.2分以及中文开源模型ChatGLM-6B的36.9分。

MMLU由加州大学伯克利分校等知名高校共同打造,集合了科学、工程、数学、人文、社会科学等领域的57个科目,主要目标是对模型的英文跨学科专业能力进行深入测试。其内容广泛,从初级水平一直涵盖到高级专业水平。

万亿数据、4K上下文、高效稳定训练

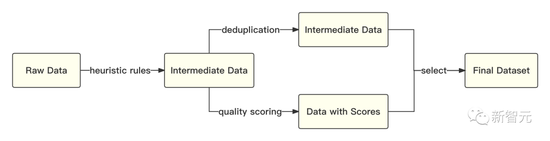

训练语料对大模型的训练结果至关重要。在构建预训练语料库方面,百川智能以高质量中文语料为基础,同时融合了优质的英文数据。

具体来说,原始数据包括自行抓取的海量中英文互联网数据和部分开源的中英文数据,以及大量高质量知识性数据。

在数据质量方面,通过质量模型对数据进行打分,对原始数据集进行篇章级和句子级的精确筛选。

在内容多样性方面,利用自研超大规模局部敏感哈希聚类系统和语义聚类系统,对数据进行了多层次多粒度的聚类,最终构建了包含1.2万亿token的兼顾质量和多样性的预训练数据。

相较于其他同参数规模的开源中文预训练模型,数据量提高了超过50%。

在万亿优质中英文数据的基础上,为了更好地提升训练效率,baichuan-7B深度整合了模型算子来加快计算流程,并针对任务负载和集群配置,自适应优化了模型并行策略以及重计算策略。

通过高效的训练过程调度通信,baichuan-7B成功地实现了计算与通信的高效重叠,进而达到了超线性的训练加速,在千卡集群上训练吞吐达到180+Tflops的业界领先水平。

同时,已有的开源模型窗口长度在2K以内,对于一些长文本建模任务,如需要引入外部知识做搜索增强的场景,更长的处理长度有助于模型在训练与推理阶段捕获越多的上下文信息,2K的处理长度存在比较大的制约。

经过优化的分词算法

baichuan-7B基于高效的attention算子优化实现了万级别超长动态窗口的扩张能力,本次开源的预训练模型开放了4K上下文窗口,使模型应用场景更加广泛。

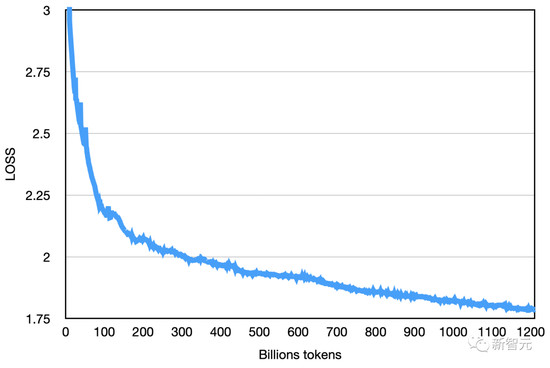

此外,baichuan-7B还对模型训练流程进行了深度优化,采用了更科学且稳定的训练流程和超参数选择,使得 baichuan-7B模型的收敛速度大大提升。

与同等参数规模的模型相比,baichuan-7B在困惑度(PPL)和训练损失(training loss)等关键性能指标上表现更加优秀。

开源免费可商用,清北已抢先体验

秉持开源精神,baichuan-7B代码采用Apache-2.0协议,模型权重采用了免费商用协议,只需进行简单登记即可免费商用。

baichuan-7B此次开源的内容十分丰富,包含了推理代码、INT4量化实现、微调代码,以及预训练模型的权重。

其中,微调代码方便用户对模型进行调整和优化;推理代码与INT4量化实现则有助于开发者低成本地进行模型的部署和应用;预训练模型权重开源后,用户则可以直接使用预训练模型进行各种实验研究。

据了解,北京大学和清华大学两所顶尖大学已率先使用baichuan-7B模型推进相关研究工作,并计划在未来与百川智能深入合作,共同推动baichuan-7B模型的应用和发展。

清华大学互联网司法研究院院长、计算机系教授刘奕群认为, baichuan-7B模型在中文上的效果表现十分出色,它免费商用的开源方式展现出开放的态度,不仅贡献社区,也推动技术发展。团队计划基于baichuan-7B模型开展司法人工智能领域的相关研究。

北京大学人工智能研究院助理教授杨耀东认为,baichuan-7B模型的开源将对于中文基础语言模型的生态建设及学术研究产生重要推动作用,同时他也表示将持续关注相关领域探索,并且在中文大语言模型的安全和对齐上进行进一步深入研究。

百川智能CEO王小川表示:‘本次开源模型的发布是百川智能成立2个月后的第一个里程碑,对百川智能而言是一个良好的开局。baichuan-7B模型,不仅能为中国的AGI事业添砖加瓦,也为世界大模型开源社区贡献了新的力量。’

技术团队专访

Q:baichuan-7B如何处理幻觉问题,未来该如何提高结果正确性?

A:大模型在可见的未来还不能彻底解决幻觉问题,一方面通过强化学习来让模型知道自己不知道,有效缓解幻觉,更重要的是需要靠‘搜索增强’引入外部知识来逐步解决幻觉问题。

Q:baichuan-7B能带来哪些商用价值?

A:baichuan-7B作为在多个榜单评测效果成绩最佳的7B开源可商用大模型,填补了市场上缺乏优质的针对中文优化的7B大模型的空白,是开发者理想的7B大模型底座。同时在商用价值方面,能够在例如文本生成,自动化写作,数据分析,知识问答,中英翻译,个性化交互和专业领域个人小助手,比如医疗领域,给用户带来巨大的价值。

Q:baichuan-7B在评测榜的成绩达到最初的训练模型预期了吗?

A:打榜并不是我们的目的,我们相信好的数据和算法能力,评测自然会有好的结果,这次baichuan-7B在多个最具影响力的评测中的优异表现也验证了百川的这个理念。

(声明:本文仅代表作者观点,不代表新浪网立场。)

Recommend

About Joyk

Aggregate valuable and interesting links.

Joyk means Joy of geeK