2017 年最推荐的五篇深度学习论文

source link: https://zhuanlan.zhihu.com/p/32450149?

Go to the source link to view the article. You can view the picture content, updated content and better typesetting reading experience. If the link is broken, please click the button below to view the snapshot at that time.

2017 年最推荐的五篇深度学习论文

简评:2017 年度最值得深入阅读的五篇深度学习相关论文,如果没读过的可以行动了。

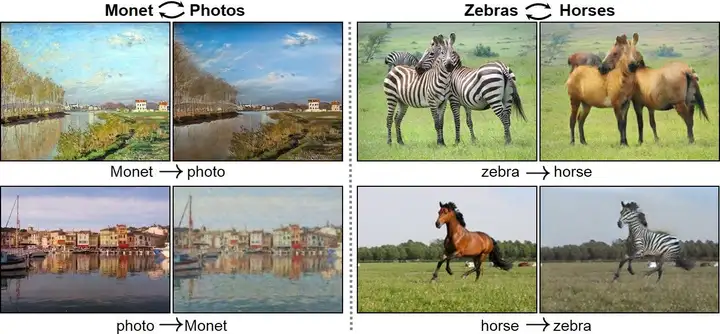

1. 最酷视觉效果:使用 CycleGAN 在不成对图像集之间转换

目标:学会在不成对的图像集之间进行转换

作者开始有两套不同领域的图像,如马和斑马,并学习两种转换网:一种将马转换为斑马,另一种则相反。每一种转换都进行一种样式转换,但不是针对单个图像的风格,而是在网络中发现的一组图像的聚合风格。

转换网被训练成一对生成对抗网络(Generative Adversarial Network,简称 GAN,是非监督式学习的一种方法,通过让两个神经网络相互博弈的方式进行学习),每个网络都试图欺骗鉴别者,使其相信「转换后」的图像是真实的。引入了额外的「循环一致性损失」鼓励图像在经过两个转换网络(即向前和向后)之后保持不变。

论文的视觉效果是惊人的,强烈建议去 GitHub 看看一些其他的例子。我特别感兴趣这篇是因为,与许多以前的方法不同的是,它学会在不成对图像集之间进行转换,打开可能不存在匹配图像对的应用程序的大门。此外,代码非常易于使用和实验,证明了方法的稳健性和实现的质量。

2. 最优雅:WASSERSTEIN DISTANCE,更好的神经网络训练

目标:使用更好的目标函数来更稳定地训练 GAN

这篇论文提出了使用稍微不同的目标函数训练生成抗性网络,新提出的目标函数比标准 GAN训练要稳定得多,因为它避免了在训练过程中消失梯度:

使用次修改的目的,作者还避免了一个称为模式崩溃的问题,其中标准 GAN 仅从可能输出的一个子集中产生样本。例如,如果一个 GAN 正在训练产生手写的数字4和6,则 GAN 可能只生产4,并不能在训练中规避这个局部最小值。而通过消除在训练目标梯度,即所谓的 Wasserstein GAN 来避免此问题。

这篇论文非常独立:作者

(1)激发一个简单的想法

(2)在数学上显示为什么应该改进当前的技术水平

(3)有一个令人印象深刻的结果展示其有效性。

此外,作者提出的修改在几乎所有流行的深度学习框架中都很容易实现,使得采用所提出的改变是切实可行的。

3.最有用:使用 GANS 进行无监督的模拟训练细化数据

目标:使用真实世界的图像,使模拟训练数据现实应用中更有用

采集真实世界的数据是比较困难和耗时的。因此,许多研究人员经常使用仿真工具,它们能够产生标记的训练数据的几乎无限量的。然而,大多数模拟数据对于训练在真实数据上操作的深度学习系统是不够逼真的。

为了克服这种局限性,论文使用生成对抗网络(GAN)来使用未标记的真实世界图像来改进标记的模拟图像。 他们训练一个「细化网络」来欺骗辨别分类器,该分类器被训练成可以区分精致的模拟图像和真实图像。 由于细化网络和分类器是一体化训练的,精致的模拟图像开始显得非常逼真:

当这篇论文发布出来时,我立即产生了兴趣,因为它提出了第一个实用的方法来弥合模拟数据与真实数据之间的差距。这里关键的是该算法是无监督的,这意味着用户不需要手写工标注真实数据。对于深度学习应用来说,数据为王,然而像我这样的大多数学术实验室都没有资源来生成快速处理新的研究领域所需的大量数据:如果公共数据集不存在你们试图解决的这个问题的数据,那么你就停滞在收集和标注相关数据上了。本文的外延信息是,只要你有一个你正在试图解决的问题的模拟器,你就应该能够生成你所需要的训练数据。

4.最令人印象深刻:从零开始的谷歌的围棋 AI

目标:在没有任何人类参与的情况下学习围棋

2017 年的最佳名单将是不完整的,如果没有谷歌的 DeepMind 在过去这些年的另人印象深刻的成就,特别是他的 AlphaGo。

最近的 AlphaGo Zero 论文避免了集成人类的知识或游戏玩法:它只通过「自我玩耍」进行训练,这是通过改进的强化学习训练程序来实现的,其中的策略会随着游戏的前向模拟而更新,用于指导搜索的神经网络在游戏过程中得到改善,使训练速度更快。仅仅在大约 40 个小时的游戏时间之后 AlphaGo Zero 甚至超过了 AlphaGo Lee ( 2016 年击败了李世乭)的表现。

尽管我对这篇论文的兴趣主要集中在工程学层面,但 AlphaGo 采用的混合经典和深度学习方法也让我倍受鼓舞,在这种方法中,蒙特卡洛树搜索的增加使得系统性能优于单片神经网络。 作为研究机器人的人,我被这种组合方法所鼓舞:使用经典算法作为决策的主干,并使用机器学习来提高性能或克服计算限制。这篇论文和 2016 AlphaGo 论文也都很棒, 都写得很好,充满了有趣的技术细节和见解。 如果没有其他原因,这些文件值得详细阅读。

5.最发人深省:深度图像

目标:了解之前我们的神经网络模型赋予我们的实验。

本文的作者不是用一大堆数据训练一个深度神经网络,而是如今相当标准的,本文的作者想探讨如何使用神经网络本身帮助我们解决一些流行的图像处理任务。他们从一个未经训练的神经网络开始,用作者的话来说「不是在图像空间中搜索答案,而是在神经网络的参数空间中搜索」,并且避免将大型数据集中的神经网络。

我立刻被这个结果迷住了:我们的神经网络的结构对我们的数据有什么意义?我们怎样才能更好地理解这一点?我们如何利用这种方法来建立更好的网络模型? 当然,作为一个团体,我们隐含地理解了我们的网络结构对我们的数据所施加的一些限制:如果「斑马」图像全部颠倒,CycleGAN 方法不太可能有效地工作。 然而,它提出了一些关于我们的神经网络模型的深刻的问题,并为来年提供了一些有趣的方向。

原文:My Favorite Deep Learning Papers of 2017

扩展阅读:

极光日报,极光开发者旗下媒体。

每天导读三篇英文技术文章。

Recommend

About Joyk

Aggregate valuable and interesting links.

Joyk means Joy of geeK