开发者圆桌论坛:Vision Pro全沉浸模式对移动设限在开发层面的影响

source link: https://www.vrtuoluo.cn/539579.html

Go to the source link to view the article. You can view the picture content, updated content and better typesetting reading experience. If the link is broken, please click the button below to view the snapshot at that time.

开发者圆桌论坛:Vision Pro全沉浸模式对移动设限在开发层面的影响_VR陀螺

文/VR陀螺

由VR陀螺主办的“Vision Pro系列开发者活动 城市系列闭门交流会”已于3月13日在上海顺利举办。

本系列活动以各大开发者集中的城市为中心,旨在联合全国优秀开发者共同探索Vision Pro的内容生态发展,探讨新平台的发展趋势和潜在机遇。现场提供Vision Pro实机的试玩体验,闭门沙龙的形式让整个活动氛围轻松自然,促进到场的开发者之间展开深度交流。

活动不仅面向XR内容团队,也面向移动端、PC和游戏主机等传统平台的内容开发者,以便从不同角度来审视和讨论这台“空间计算”设备。现场演讲有资深开发者分享visionOS的开发经验,还有嘉宾带来关于App Store平台发展、Vision Pro原生内容生态方面的深度分析。

上海站的圆桌论坛请到西顾科技CEO Nikk Mitchell、境腾科技国际战略和运营总监 陈深皆(Jazzon Chen)、《DapTap》游戏制作人 Tomas,围绕“在交互变化的过程中遇到了哪些开发问题”“直接和间接手势交互的局限性与拓展性”“全沉浸模式对移动范围设限在开发层面造成的影响”“Vision Pro多种视频形式未来的发展”等问题展开了深度探讨。

以下为圆桌论坛实录:

案山子:首先有请各位嘉宾自我介绍一下。

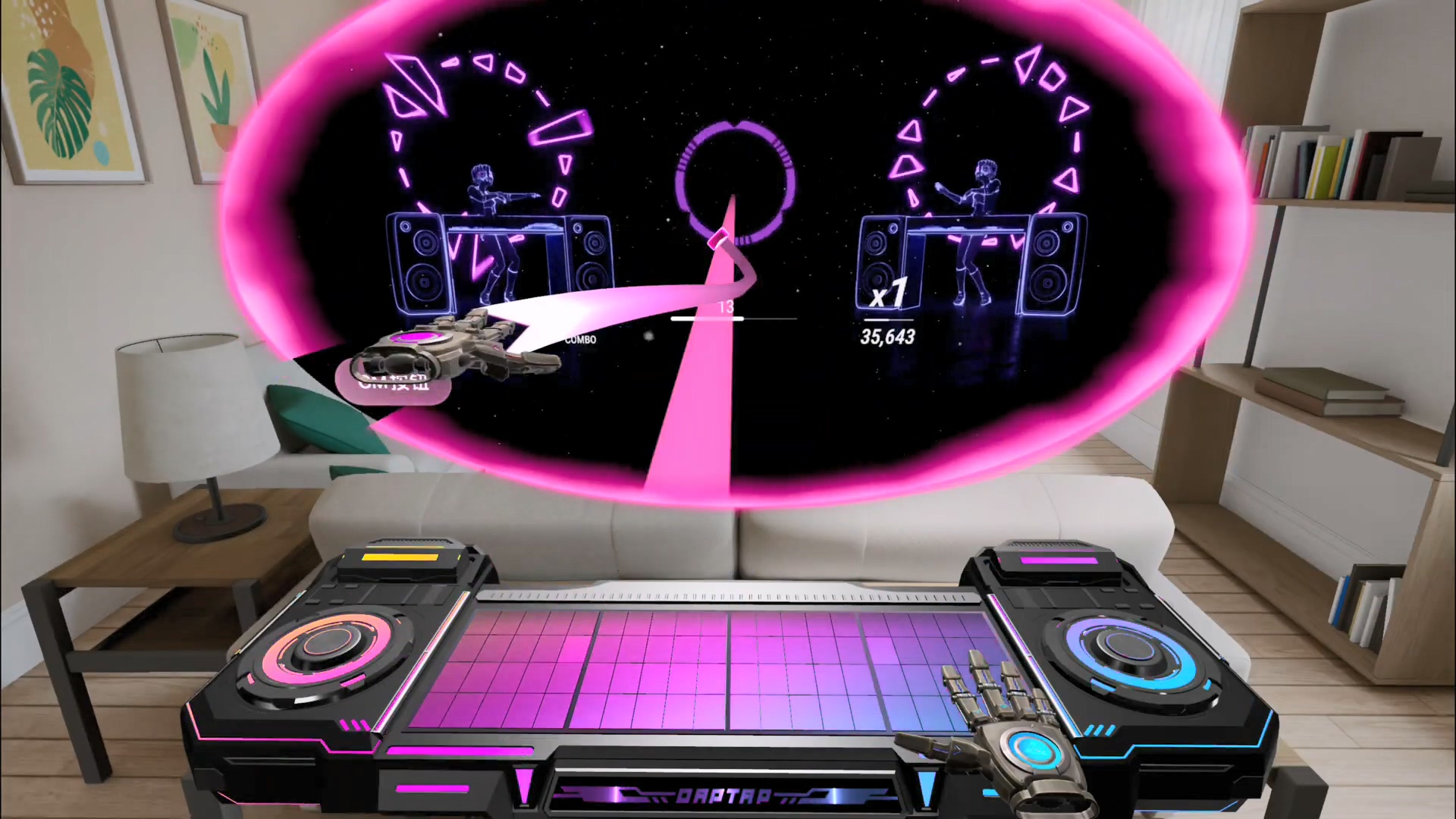

Tomas:大家好,我们是上海的开发团队,之前在PICO上做过内容,现在在Apple Vision Pro上做了一款游戏叫《Daptap》。大家如果有兴趣的话可以搜一下。

(编注:《Daptap》是一款基于手势追踪游玩的音乐类游戏,在Vision Pro上拿到了苹果的推荐位。)

Nikk Mitchell:我是Nikk,在VR视频领域已经做了十多年。西顾科技主要是做VR影视方面,也做VR摄像机。

Jazzen:我是来自境腾科技的陈深皆,我们是一家专门向企业输出混合现实、虚拟现实等应用的和方案的公司。

案山子:三位都来自不同领域,分别是游戏、影视以及行业的B端领域。Vision Pro的手眼协同是这个平台相较之前的HoloLens和Meta Quest等设备最大的一个差异点,想请问各位在为Vision Pro平台开发内容时,在交互变化的过程中遇到了哪些问题,您认为是手眼协同不太适合的?或者基于手眼协同,您觉得还有哪些拓展点是可以延伸的?

Tomas:因为我们之前是在PICO上做游戏,Vision Pro抛弃了控制器以后,我觉得作为一个资深的游戏制作团队肯定会非常不适应。但是回想从PC互联网到移动互联网,一直到现在的空间计算,我们清醒地意识到可能未来大部分的主流游戏就是裸手,所以我们也毅然决然地拥抱了裸手这种交互形态。AVP的裸手和Quest的裸手其实有很大的差异,即便Quest的裸手现在也还不是一个很好的状态。所以大家如果真正在为AVP做内容的时候,对于裸手可能要想出跟控制器有明显不同的游戏形态,才能比较有效地匹配这个设备的特性。

案山子:之前我在玩Vision Pro的《Synth Riders》,会发现当手移动得太快的时候,游戏里的虚拟球是跟不上手的。您在开发音乐游戏时有碰到类似的问题吗?

Tomas:有的,我展开讲一下。Quest 3上的手追摄像头的捕获效率大概是30毫秒,就是说每30毫秒能抓一次,然后会有一个算法去进行跟踪,总的来说Quest 3的手部延迟可能在30 - 50毫秒。如果在Apple Vision Pro上,首先这个捕获效率也是30毫秒,但是它对于手推测大概在100 - 150毫秒,也就是说在AVP上捕获手势的整个延迟可能在150毫秒左右。所以这会对我们做内容造成一个非常大的问题,如果游戏玩法是快速QTE,要求用户有足够高的精确度去操作的话,那会非常有难度。

(编注:QTE是游戏术语,全称Quick Time Event,即快速反应事件。)

大家去看现有的三款内容——《Super Fruit Ninja》《Synth Riders》,还有我们的《DapTap》,其实都存在类似的问题。AVP上有一款2D的游戏叫《Void-X》,他们的做法还挺有意思的。这是用手操作一架二维飞机的游戏,但特效是三维的。这个内容的评论量涨得还挺快的,他们没有获得任何的推荐。我还有很多朋友用手柄玩一些2D平板类的游戏玩得也很嗨,所以说在游戏类型选择上,还有在一些交互的方向上,大家都要更加谨慎地去看待。

案山子:音乐游戏品类在Meta Quest平台是出过爆款的,也是目前最爆的一个VR产品《Beat Saber》。到Vision Pro平台,大的游戏玩法逻辑还是差不多的,只是交互的体验会有很大的差异。我们在玩音乐游戏的时候,实际上手柄还有给一些振动反馈,让人觉得节奏很带感。现在AVP变成裸手交互之后,您觉得从体验端来看,音乐游戏在这个新平台上还有没有可能延续这种爆款的情况?

Tomas:大家可以想象一下,鼠标键盘没有给我们任何的手部反馈,也就手柄和控制器能提供一些振动反馈,对吧?我不认为这是很大的问题。因为一个通用计算设备,它是要铲除掉一些其他设备的,所以到时候真正跟你作品竞争的,并不是有振动手柄的产品,而是在同样没有手部反馈的平台上,你做的内容是不是比别人的更好?平台会把那些非裸手的平台竞争下去。

我觉得这也可以回到一个本质性的问题,就是一个人接收到的感觉有哪些?有视觉、触觉、听觉、嗅觉、味觉。我们做《DapTap》的时候就在思考这个问题,如果系统没有提供触觉的反馈的话,那你可以怎么样做这个反馈?

我觉得有些思路,比如说用现实世界当中用户可以最快速找到的、可以触摸的东西。比如人的左手和右手,右手操控的同时可以把左手当做一个控制器,用这样的方式来代替控制器的摇杆——这叫做“自反馈”。像我们的《DapTap》是找一张平面的桌子,通过拍桌子模拟一种打鼓的感觉,拍出《We Will Rock You》的感觉,《DapTap》就是以这样的理念去实现的。还有比如手机,这些平常能找到的东西都可以用来做交互、做触觉的反馈,我觉得都是可以的。

听觉和视觉其实是必然的。因为一个游戏体验除了内在的Game Play外,听觉和视觉也要做到一个高度才行。我觉得AVP可以在视觉上做到很高的高度,这是它非常好的地方。

案山子:感谢Tomas的分享。接下来有请Jazzen也聊一聊交互这方面。

Jazzen:因为我们的客户往往不只有一种设备,尤其是一些在科技创新领域走得比较前面的企业,但凡有新的设备他们都会去采购,拿回来之后又不希望这些设备吃灰,每个都要用起来。所以同一个应用,他们可能希望每种设备上面都有。

底层就是跨平台,我们可以通过Unity这样的开发工具去做,但不同平台上的交互不一样是一个非常令人头痛的问题。我们每次在移植到一个新平台的时候,有两件事情做得最多。第一个是移植交互,要考虑到手势、手柄、手眼的不同交互,我们会在这上面花非常多的精力去做移植。还有一个就是Shader,这个就暂且先不说了。

所以我觉得一个值得思考的问题是,将来这么多不同平台,它们的交互是不是有可能会去进行统一?其实VR手柄的形态已经变得越来越像了,都是背后两个扳机,两边各有一个摇杆和两个按钮。但是早些时候,还能在VR手柄上看到一些触摸板。可见手柄的形态到后面是有可能会变得越来越统一的,而且现在Meta也说未来会把眼动追踪加进去,那是不是将来大家都会有这种眼睛加手势的操作。我觉得长期来说,交互统一对开发者而言可能是一个更好的事情。

案山子:对,交互统一我是非常同意的。因为苹果定义了这种交互之后,我觉得很多设备厂商都会朝这个交互方向去迭代。HoloLens上可以自定义很多手势,当然苹果Vision Pro也可以定义手势。那您之前做过的那些手势,是否可以完全按照先前的设计逻辑和思维移植过来?

Jazzen:这就要给Unity打个Call。Unity还是挺给力的,他们底层的框架在移植手势的时候非常方便。基本上从绑骨骼到定义手势,我们没有花很多的功夫。其实HoloLens上可自定义的手势都可以全部搬过来了。当中还有一个MRTK,会做很多这种手势的工作,能够帮我们去填空。

案山子:您觉得在B端的应用里,是手势操作好,还是手柄更好?还是说要分领域?

Jazzen:对,这个要分场景、分领域来看。比如当领导参观的时候,我们会定义一个流程,通过其他的设备比如平板或手机,去帮他完成交互。

对于培训实操类,他们的交互就是非常重要的。现在很多VR里还是用手柄在做交互,但是我们能看到一些内容正在逐渐被更加有真实感的东西替代。我们希望学员通过很多遍的重复操作去养成一个肌肉记忆,就是要用正确的手法、正确的手势去操作,最终才能形成肌肉记忆。我觉得大的趋势就是这样。

案山子:Vision Pro提供了两种交互——直接手势和间接手势。我发现大部分第一次体验这台设备的人会非常习惯地用直接手势,就是一定要去戳、去抓,这其实是人的本能反应。但是苹果给了一种间接手势,让用户去适应、去习惯。这两种交互在内容设计的时候各自的局限性和拓展性,各位是怎么考量的?

Tomas:这是个很好的问题。我先说一下直接手势,因为从理论上来讲,用户的一个行动越原始、就越容易被使用和接受。所以我相信可能在很多年后,直接手势可能会比现在用得要更多。

而间接手势是一种方法过度,比如键盘、鼠标和Pad是对某个东西的映射,它能有非常好的学习效率。另外,我觉得当人进入虚拟空间或者进入空间计算的时候,如果扮演上帝这样的角色,那就不可能接触到所有的东西,所以这种“隔空取物”的操作,也应该有它的用武之地。

Nikk Mitchell:我觉得要看内容的目标。培训类需要肌肉记忆就肯定要用手,就像人在学习调用一个设备,戴着Vision Pro或AR眼镜也还是会用手去操作。如果在学习中是间接手势,眼睛只是看着,那真正动手的这个记忆就没有了。如果是一款游戏,目标是好玩,就可以多用间接交互来玩。我觉得在操作UI等方面,肯定还是眼睛识别得更快、效果更好,就像是人拥有了一种超能力。

Jazzen:间接手势是提升效率的一种做法。我是个比较重度的VR头显使用者,之前有段时间每天都会戴Quest 3将近3 - 4个小时。我会碰到一种情况,比如手还在键盘和鼠标上,但我并不希望使用直接手势去触碰某个东西,而是希望手不要动,只需眼睛看着某处、再一点。苹果从这个角度上很大程度帮我们提升了效率。

直接手势首先是能够获得准确的交互,第二是能够通过视觉或者触觉得到一个反馈。像我们在做培训场景的时候,经常会做一些虚实叠加,比如告诉学员下一步要把这扇门打开,我们会在真实设备的门上面去叠加一个虚拟的门,他手伸过去是要抓住这种门的,这时候必须得用直接手势,因为他既可以直接抓住真实的物体,又能抓住虚拟的东西。这样学员才能够知道培训的目标就是为了让他去养成这种触觉和感受。脱离直接手势就很难达到我们真正实训的目标。

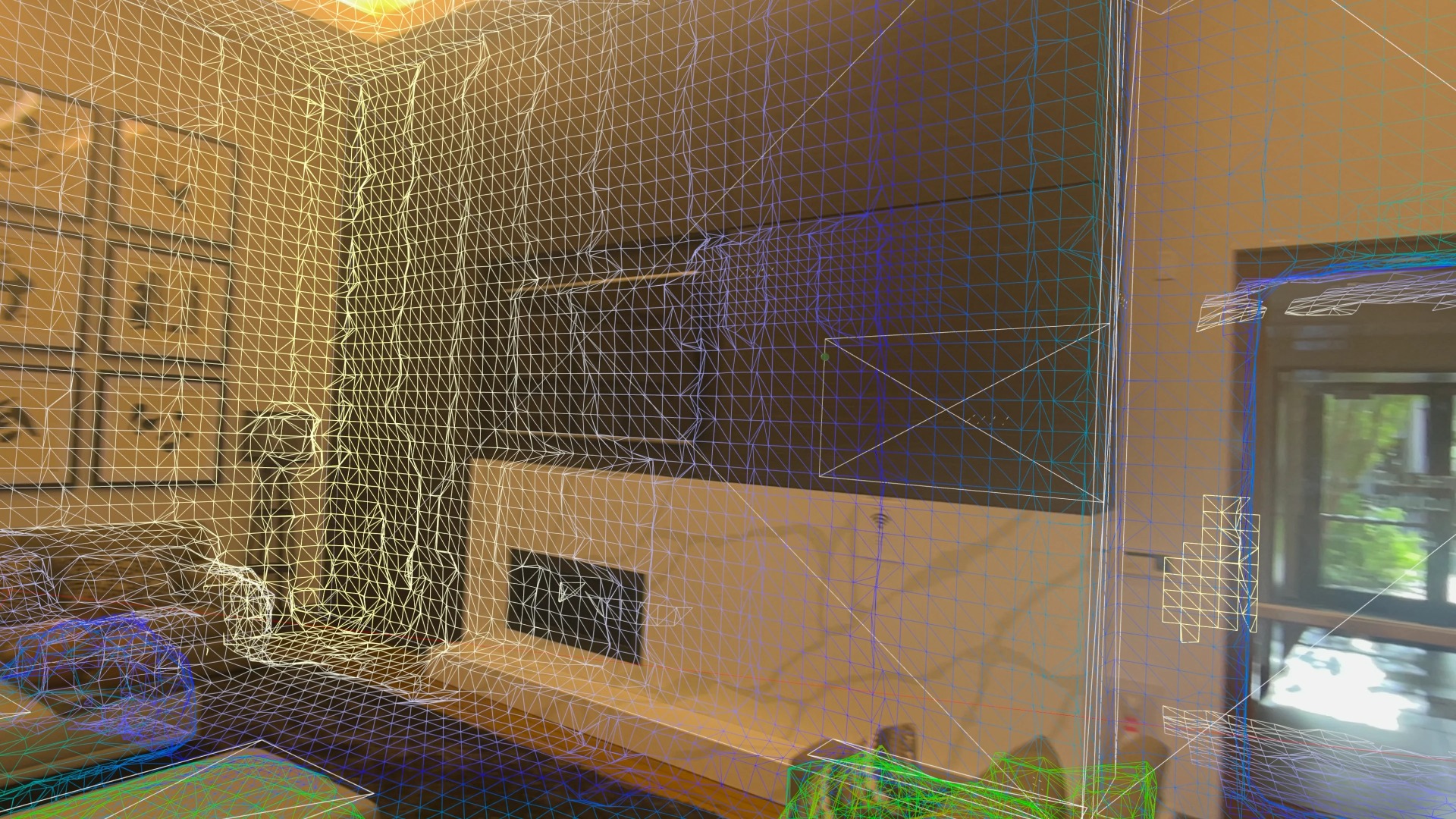

案山子:如果之前做过VR内容的话,大家都会觉得在VR空间里面行走是一件顺理成章的事情。但是在苹果Vision Pro的全沉浸状态下,会发现如果走出去一米就变成透视状态了。这种设计对于各位开发内容会不会有一些影响?

Tomas:这个主要限制了Vision Pro的全沉浸模式。苹果有一个很重要的观点是它不希望人与现实断开连接。我觉得Vision Pro在MR上的这些空间限制,还是因为用户能足够清晰地看到现实环境,所以从安全感上来说我觉得没有问题。

至于1.5米的移动限制,我觉得也是因为全沉浸的VR应用一直以来都有这个问题。因为用户看不到现实世界,所以Quest 3上大部分全沉浸应用,移动其实还是依赖控制器的。苹果没有控制器,因此这在制作游戏时也是一个难点。我觉得倒没有什么问题,只是大家要适应,未来这可能会是一种常态。

Nikk Mitchell:从开发角度来说有这个限制肯定很烦,但我觉得1.5米的范围可能还是有道理的,苹果应该是考虑了什么类型的内容更适合从没体验过VR的用户,只是移动范围不该限制得那么死板。在这种限制下,开发者就要思考如何设计一个小范围的体验。不过像Jazzen开发的很多应用都是需要大空间的,在Vision Pro上就会受到很大的影响。

Jazzen:确实,因为我们真的很依赖在真实的环境当中去摆各种虚拟的东西,尤其是进入到全沉浸模式下。比如在特定环境下进行培训的场景,需要模拟周围的天气,要把学员放置到某些场景里面去,他才能知道遇到这种情况应该怎么操作。他在实际作业时不可能是禁止移动的,所以用Vision Pro确实会有问题。

我觉得能从两方面去解决。第一个是在开发应用的时候,是不是能够主动把这个场景给剥离出来?就专门设计某些可以坐着不动、去全沉浸进行学习的场景。同时在进行实操的时候,还是把用户从全沉浸场景下给脱离出来,让他能够感知到周围的环境。另外一个就是看将来厂商是不是有可能做到更多。比如说像苹果,它现在可以用产品重建的方式提供环境的Mesh,我其实是可以把这个Mesh在全沉浸的场景中渲染出来。当然现在可能还做不到,但是将来有可能苹果把它开放出来之后,我在全沉浸下面放Mesh,这样的效果可能会更好。

案山子:最后一轮问题是关于场景的,首先聊游戏场景。您觉得哪些游戏类型会更加适合Vision Pro的这种手眼交互?游戏的路径会是怎样的?

Tomas:我觉得这个问题从Quest 1开始就延续下来了,一款游戏最终带给用户的核心体验还是视听和Game Play。如果是同类型的游戏,比如把MOBA类移植到Quest 3上,假设能顺利地操作,但是达不到一个好的分辨率,从视觉上就不行。如果是这种情况,用户在选择的时候,就还是会选择在手机平台去玩。但是Vision Pro我觉得在视觉上是可以跨过这道坎的。

接下来是从游戏本身。我们假设这款游戏没有操作的限制,就是用手柄、键盘或是裸手都可以玩。游戏内在的娱乐性足够强的话,那么拼的就是制作的精良程度和成本。像《星穹铁道》和《恋与深空》现在都可以在Vision Pro里玩了,并不需要一个360度的环境或是很大的视角,就能体验到非常棒的内容。如果是创业公司去做这件事,就要思考什么在这个平台上是不可替代的?一旦抛弃这个平台,它作为好的游戏或内容还是否成立?

我们去看Quest 3上的《Beat Saber》《Gorilla Tag》,还有一些VR射击游戏。它们都是利用了这款设备的交互特性来增强游戏本身内在的娱乐性,从而达到了这种效果和成绩。所以在Vision Pro平台上,如果把直接交互拉到一个高度,那么作品的竞争对手就不是那些传统的主机游戏,就能获得一定的红利。如果要硬着头皮去做2D横版游戏的话,可能就要与《死亡细胞》这种制作精良的内容竞争,那就会遇到很多问题。

案山子:所以还是要跳出传统思维去做一些东西。

Tomas:我觉得给Vision Pro做游戏跟之前做VR游戏的区别并不大。有人可能会问MR游戏能发挥到哪里?这个问题我还没有得出结论,但有一个命题大家可以思考一下——如果这个内容抛开了MR、抛开了现实环境,它还是不是一个好的内容?如果依然是一个好的内容,说明MR对它来说不是充分必要的条件,那么作品拼的就还是游戏质量。比如《宝可梦GO》即便抛弃了AR,IP还是在那,所以它依托的并不是AR。这个问题我至今还没有找到一个确定性的答案。

案山子:Vision Pro的空间锚定功能很强,能不能把这个功能利用起来?比如把整个世界变成一个游乐场,然后可以在里面基于GPS和现实环境做一些融合,这会不会是一个方向?

Tomas:从手游的现状可以发现,游戏对用户的刺激频度要足够高。当我们把空间尺度拉大,它的频度可能就会降低。还有一个问题是场地的随机性。当我们玩一些主流游戏,比如MOBA和吃鸡,有竞技性和合作。当竞技性由于现实环境产生一些随机性,导致随机性过大到不能公平竞技的时候,也会造成问题。所以我觉得这是个很多人都会想、甚至有人已经去做了、结果没做起来的方向,但我相信未来还是会有人继续尝试的。

案山子:Vision Pro里有不同的影视形态,除了纯大屏的2D观影、3D观影,影院模式下的3D观影,全沉浸模式的180度观影,再加上空间视频,一共是五种。您觉得这些视频的形式都会一直持续存在、保持并存的状态?还是说现在以2D视频为主,然后慢慢地会过渡到以3D或空间视频为主,或者是以180度的全景视频为主?

Nikk Mitchell:我觉得每种视频形态都会有相应的应用,以我自己评估,各种视频内容会特别丰富,并且会融合在一起。就像之前PICO出过很多案例,早期PICO上的VR直播是找MCN公司,现在已经有一些个人的带货型直播,包括在4S店和农场,能看到很多新的东西。未来在Vision Pro上,当用户真的开始去创作,就会有完全新的内容呈现出来。

就像从图片过度到视频,但现在人们依然在拍照、在用图片,基于应用的场景会适合不同的视频形式。各种视频形式具体的比例是多少很难说,但一定会共存。

案山子:全景视频已经发展了很多年,在VR的终端上也有很多年了。我们能看到拍摄分辨率在不断地提升,从4K,到8K,甚至后面可以看到一些16K的视频。您觉得苹果Vision Pro提倡的全景视频是180度,而不是360度,出发点是什么?

Nikk Mitchell:我认为180度全景视频是一个非常好的选择。用户坐在一个固定的位置体验内容,其实很少会关注背后;从制作的角度来说,做360度全景视频的难度比180度高出N多倍,要考虑灯光、拍摄团队的位置,拍摄会涉及到非常多的调整。所以在制作上,以180度全景视频进入VR影视是也是一个特别好的开始。

案山子:关于分辨率,现在苹果Vision Pro是用3.4K的屏幕,我们可以看到180度的8K全景视频。您觉得如果视频分辨率再往上翻一倍,以目前产品的性能可否很好地胜任?

Nikk Mitchell:现在苹果Vision Pro的解码如果再往8K以上有时候就会卡,我团队里有些人说这是它硬件的限制,就是最高能播到8K。但是通过软件,比如一些播放工具,肯定还是能超过8K。至于屏幕的清晰度,我评估要到12K,就能接近它性能的极限。

案山子:B端有非常多的场景,像教育、工业、医疗、培训……能畅想的也非常多。对于Vision Pro,有哪些B端场景您觉得市场空间大,相对比较好进入?以及场景的通用性或者标准性会相对比较高?

Jazzen:我觉得短期来看,现在最容易出结果的应该是协助品牌方一起去做宣传类的东西,像是市场活动,或者去大型展会,带几套Vision Pro效果应该会非常好。长期来看的话,还是要有一定的市场接受度,用户还需要培养。现在我们在上海,但是比如中国西部的一些省份,他们对于高科技的设备还没有那么敏感。所以当那些地方的人也开始对Vision Pro感兴趣的时候,就意味着设备的普及率到一定程度了,那时候的场景和我们现在的场景会完全不一样。

我们在跟企业客户聊的时候,他们还是有蛮多天马行空的创意的,只不过现在的硬件和软件还有办法去支持他们的想法。但是当硬件普及率到了之后,包括分辨率、交互的方式、交互的精度,能够达到客户需求的点,我觉得可能整个行业都会变得不一样,尤其是一些效率型的工作。

比如我们现在做一些三维的建模,把模型放到Vision Pro里还不是一个很流畅的效果。我觉得Vision Pro在渲染一些非常高精度的模型时也需要优化。整个工作流至少到今天我认为还没有完全打通,将来这个场景打通之后,我们就可以把类似的场景完全做出来。

案山子:您有没有去测试渲染上限?我们之前了解到Quest大概是400万面,在Vision Pro上有没有去挑战一下它的极限?

Jazzen:我们之前尝试过600 - 1000万面,Vision Pro还是可以运行的,但是已经能明显感觉到快要接近极限了。我估计1000万面左右应该是能够支撑的。不过因为现在Reality Kit给到我们去Shader上面做一些优化的能力还不是特别开放,所以我觉得将来等苹果开放的成本越来越多之后,也许会有更加好的渲染效果。

案山子:好的,今天非常感谢各位来参加我们的沙龙活动,也聊了很多的干货。希望大家能够在这个新平台上找到自己的机会,开发出一些好的作品。非常感谢各位的分享。

版权申明:本文为VR陀螺原创,任何第三方未经授权不得转载。如需转载请联系微信:vrtuoluo233 申请授权,并在转载时保留转载来源、作者以及原文链接信息,不得擅自更改内容,违规转载法律必究。文中有图片、视频素材来自互联网或无法核实出处,如涉及版权问题,请联系本网站协商处理。

元宇宙数字产业服务平台

下载「陀螺科技」APP,获取前沿深度元宇宙讯息

Recommend

About Joyk

Aggregate valuable and interesting links.

Joyk means Joy of geeK