何恺明刘壮新作:消除数据集偏差的十年之战

source link: https://www.qbitai.com/2024/03/128087.html

Go to the source link to view the article. You can view the picture content, updated content and better typesetting reading experience. If the link is broken, please click the button below to view the snapshot at that time.

何恺明刘壮新作:消除数据集偏差的十年之战

神经网络越来越强大,利用数据集偏差的能力也越来越厉害了

编辑部 发自 凹非寺

量子位 | 公众号 QbitAI

MIT新晋副教授何恺明,新作新鲜出炉:

瞄准一个横亘在AI发展之路上十年之久的问题:数据集偏差。

该研究为何恺明在Meta期间与刘壮合作完成,他们在论文中指出:

尽管过去十多年里业界为构建更大、更多样化、更全面、偏差更小的数据集做了很多努力,但现代神经网络似乎越来越善于”识破”并利用这些数据集中潜藏的偏差。

这不禁让人怀疑:我们在消除数据集偏差的战斗中,真的取得了胜利吗?

数据集偏差之战,在2011年由知名学者Antonio Torralba和Alyosha Efros提出——

Alyosha Efros正是Sora两位一作博士小哥(Tim Brooks和William Peebles)的博士导师,而Antonio Torralba也在本科期间指导过Peebles。

当时他们发现,机器学习模型很容易“过拟合”到特定的数据集上,导致在其他数据集上表现不佳。

十多年过去了,尽管我们有了更大、更多样化的数据集,如ImageNet、YFCC100M、CC12M等,但这个问题似乎并没有得到根本解决。

反而,随着神经网络变得越来越强大,它们“挖掘”和利用数据集偏差的能力也越来越强了!

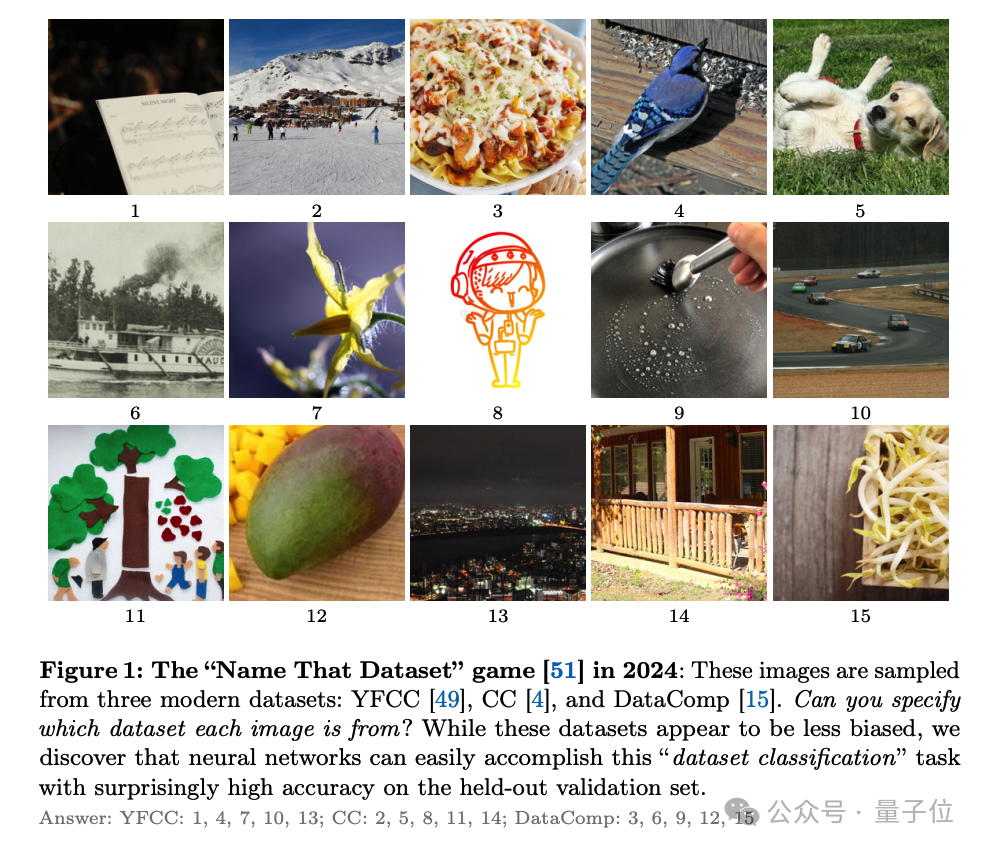

为了分析这个问题,何恺明团队设计了一个虚构的”数据集分类”任务。

听名字你可能就猜到了:给定一张图像,模型需要判断它来自哪个数据集。通过看模型在这个任务上的表现,就可以了解它们捕捉数据集偏差的能力。

现代AI轻松识破不同数据集

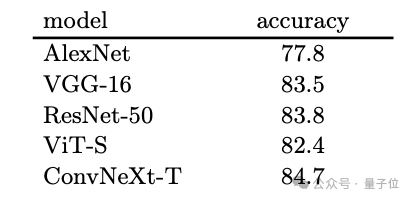

在实验中团队发现,各种现代神经网络架构,如AlexNet、VGG、ResNet、ViT等,在数据集分类任务上表现出惊人的一致性:它们几乎都能以超过80%的准确率区分不同数据集的图像!

更令人吃惊的是,这个发现在各种不同的条件下都非常稳健:

不管是不同的数据集组合、不同的模型架构、不同的模型尺寸、不同的训练数据量,还是不同的数据增强方法,神经网络始终能轻松”一眼识破”图像的数据集来源。

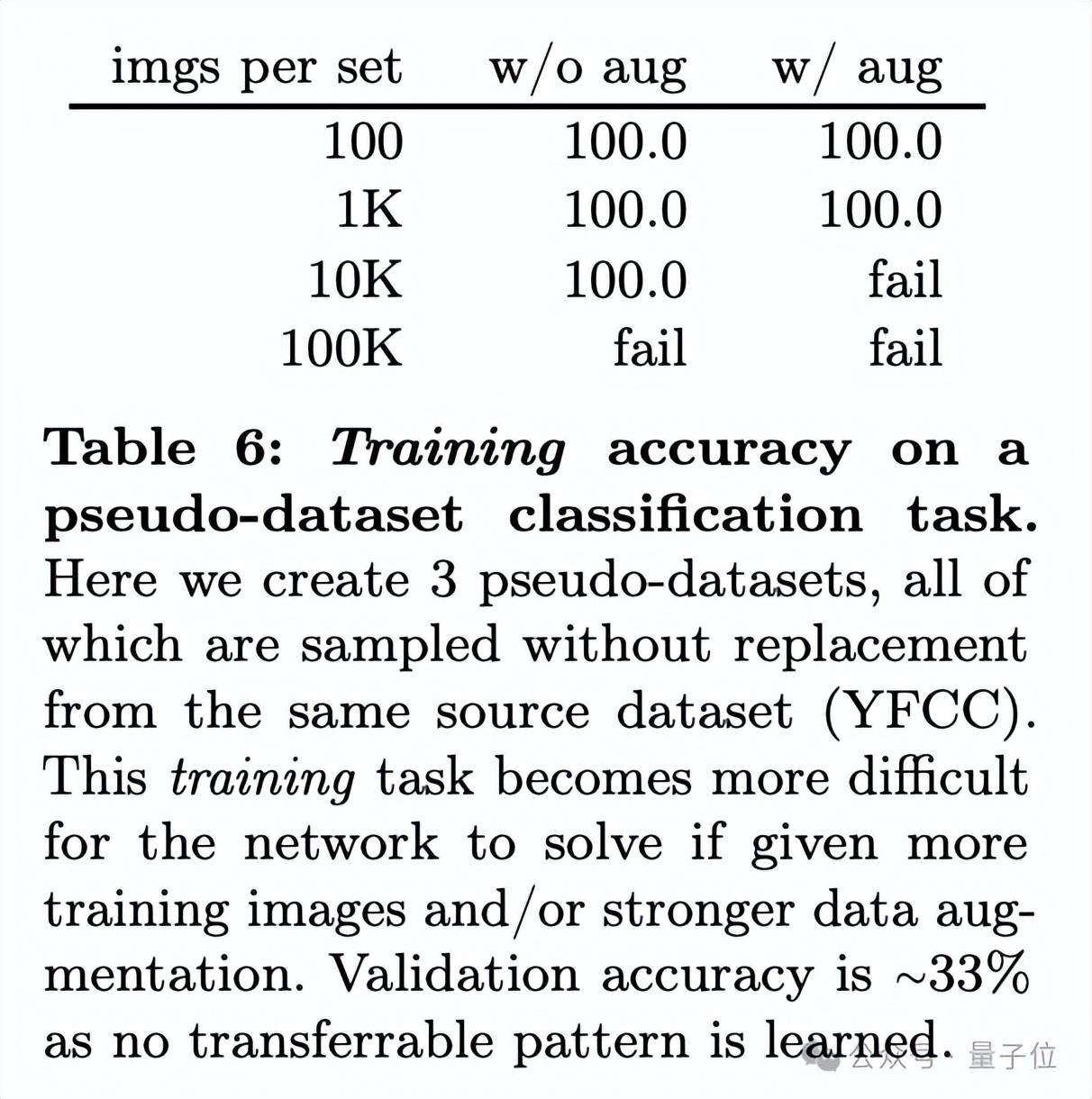

那么,神经网络是如何做到这一点的呢?是靠单纯的记忆,还是学到了一些更普适的规律?

为了揭开谜底,团队做了一系列对比实验。他们发现,如果把不同的数据集随机混在一起,神经网络就很难再区分它们了(准确率下降到了33%)。这说明,神经网络并不是在单纯地记忆每一张图像,而是真的学到了一些数据集特有的模式。

更有趣的是,即使在自监督学习的设置下,神经网络也展现出了惊人的”数据集辨识力”。在这种设置下,模型在训练时并没有用到任何数据集的标签信息,但当在这些自监督学习到的特征上训练一个简单的线性分类器时,它依然能以超过70%的准确率区分不同的数据集!

通过这一系列的实验,何恺明、刘壮等人的研究给我们敲响了警钟:尽管这十年我们一直在努力构建更大、更多样化的数据集,但数据集偏差这个问题似乎并没有得到根本解决。相反,现代神经网络越来越善于利用这些偏差来获得高准确率,但这可能并不代表它们真正学到了鲁棒、普适的视觉概念。

论文的最后,作者呼吁整个AI社区重新审视数据集偏差这个问题,并重新思考如何在算法和数据两个层面上来应对这一挑战。

CVPR最佳论文作者的通力合作

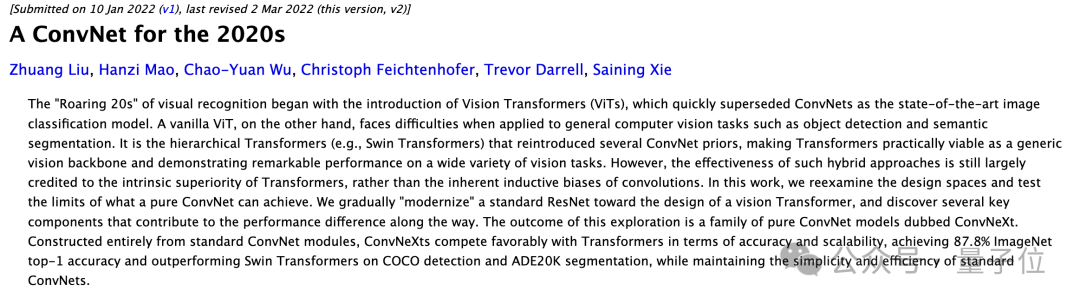

本文是何恺明在Meta期间,与Meta研究科学家刘壮合作完成。

现在,何恺明已经正式在MIT上岗,担任电气工程与计算机科学系的助理教授。他的“开学第一课”开课即火爆,在youtube上已经有2.9万的播放量。

和何恺明一样,刘壮本科毕业自清华,并且也是CVPR最佳论文奖得主——他是CVPR2017最佳论文DenseNet的第一作者。

2017年,刘壮从清华姚班毕业,进入加州大学伯克利分校攻读博士学位,师从Trevor Darrell,是贾扬清的同门师弟。

博士毕业后,刘壮进入Meta AI Research工作。在此之前,他已经在Meta实习了一年多时间,期间和谢赛宁合作,发表了ConvNeXt。

论文地址:

https://arxiv.org/abs/2403.08632

参考链接:

https://twitter.com/liuzhuang1234/status/1768096508082008289

Recommend

About Joyk

Aggregate valuable and interesting links.

Joyk means Joy of geeK