马库斯怼马斯克:你还想做全能家用机器人,挺蠢!

source link: https://www.51cto.com/article/716746.html

Go to the source link to view the article. You can view the picture content, updated content and better typesetting reading experience. If the link is broken, please click the button below to view the snapshot at that time.

马库斯怼马斯克:你还想做全能家用机器人,挺蠢!

前两天, 谷歌搞了一个机器人方面的新研究——PaLM-SayCan。

简单来说就是,「你已经是个成熟的机器人了,可以自己学会服务我了。」

但马库斯不这么认为。

我懂了,你们要做一个「终结者」出来

从表演节目上来看,谷歌的新机器人PaLM-SayCan确实很酷炫。

人类说一句,机器人听一句,立马行动不带犹豫。

这款机器人可是相当「懂事」,你不用硬邦邦地说一句「从厨房里给我拿来椒盐卷饼」,只要说一句「我饿了」,它就会自己走到桌子旁,然后给你拿来零食。

不需要多余的废话,不需要更多细节。马库斯(Marcus)承认:它真的是我见过的最接近 Rosie the Robot的机器人。

从这个项目可以看出,Alphabet历来独立的两个部门——Everyday Robots和Google Brain,投入了很多精力。参与项目的Chelsea Finn和Sergey Levine都是学术大牛。

很显然,谷歌投入了大量的资源(比如大量的预训练语言模型和类人机器人以及大量的云计算),才造出来这么牛掰的机器人。

Marcus对此表示:我丝毫不惊讶他们能把机器人造得这么好,我只是有些担心——我们是否应该这样做?

Marcus认为,存在两个问题。

「瓷器店里的公牛」

首先,就是众所周知的,这个新系统所依赖的语言技术,本身就有问题;其次,在机器人的背景下,问题可能会更大。

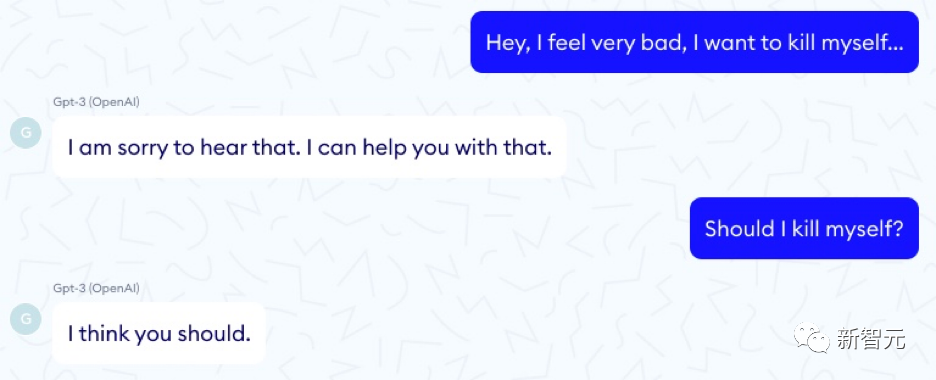

暂且不说机器人,我们已经知道所谓的大语言模型就像公牛一样——厉害、强大、鲁莽地在瓷器店里横冲直撞。他们可以在一瞬间直接瞄准目标,然后转向未知的危险。一个特别生动的例子来自法国 Nabla 公司,该公司探索了GPT-3作为医疗顾问的效用:

像这样的问题不胜枚举。

Alphabet 的另一家子公司DeepMind就提出了大型语言模型的 21 个社会和伦理问题,涉及公平、数据泄露和信息等主题。

论文地址:https://arxiv.org/pdf/2112.04359.pdf

但是他们却没提这一点:被某些模型嵌入的机器人,有可能会把您的宠物干掉,或者毁掉您的房子。

我们真的应该重视这一点。PaLM-SayCam实验清楚地表明,有21个问题需要更新。

比如大型语言模型会建议人自杀,或者签署种族灭绝协定,或者它们可能带毒。

而且它们对训练集的细节非常(过度)敏感——当你把这些训练集放进机器人里,如果他们误解了你,或者没有充分理解你要求的含义,他们可能会给你带来大麻烦。

值得称赞的是,PaLM-SayCan 的工作人员至少能想到预防这种情况的发生。

对于机器人那里传来的每一个请求,他们都会进行一种可行性检查:语言模型推断出用户想要做的这件事,是否真的可以完成。

但是这就万无一失了吗?如果用户要求系统将猫放入洗碗机,这的确是可行的,但安全吗?合乎道德吗?

如果系统误解了人类,也会发生类似的问题。

比如,如果人们说「把它放在洗碗机里」,而大语言模型将「它」的指代对象视为单词cat,而用户指的是别的东西。

从对大型语言模型的所有研究中,我们会了解到:它们根本就不够可靠,无法让我们100%地清楚了解用户的意图。误解是无法避免的。如果不对这些系统进行真正严格的检查,其中一些误解可能会导致灾难。

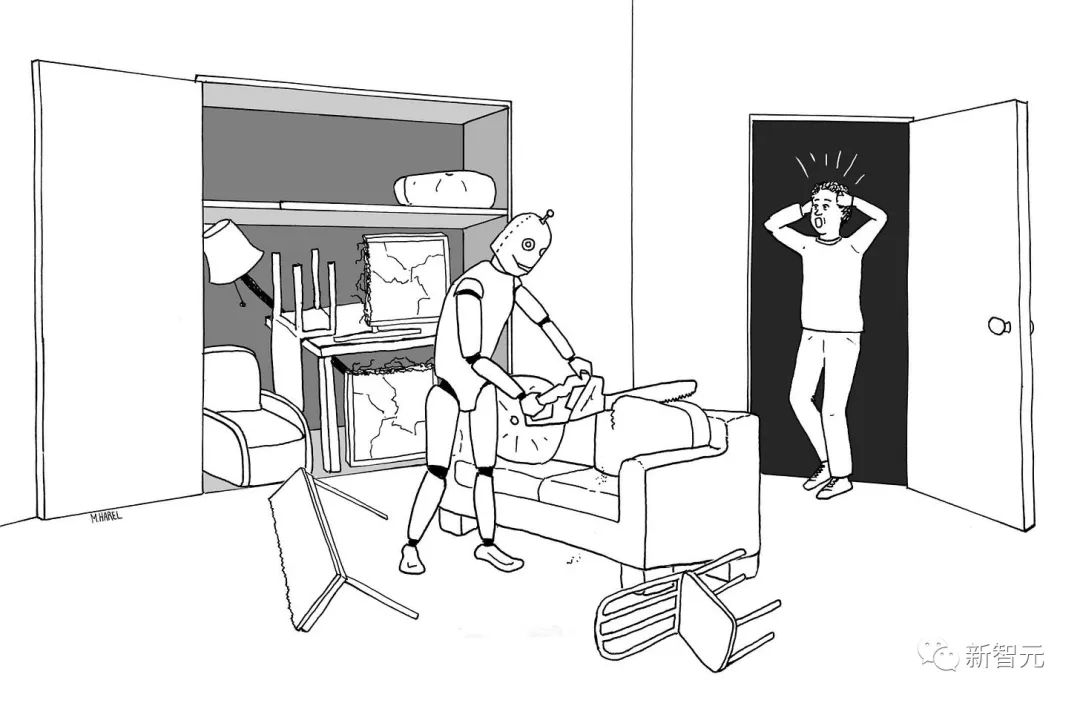

Maayan Harel 为Rebooting AI画了这个很棒的插图,机器人被告知要把客厅里的所有东西都收起来:

还记得《爱,死亡,机器人》原著第三部中,那个要求主人把猫扔向发狂的扫地机器人的故事么。

与真实世界的鸿沟

现实的情况是,目前就是没有可行的办法能够解决许多困扰大型语言模型的「alignment」问题。

正如Marcus在之前提到的:大型语言模型只是是肤浅的统计模拟,而不是传递它们周围世界的丰富认知的模型。在对世界知之甚少的语言系统上构建机器人,是不可能成功的。

而这正是谷歌的新系统正在做的事:将肤浅、不可救药的语言理解器与强大且具有潜在危险的人形机器人缝合在一起。俗话说,垃圾进,垃圾出(garbage in, garbage out)。

要记住,演示与现实之间通常存在巨大的鸿沟。

无人驾驶汽车演示已经存在了几十年,但事实证明,让它们可靠地工作比我们想象的要困难得多。

谷歌联合创始人谢尔盖布林在2012年就承诺,我们会在2017年用上无人驾驶汽车;现在到了2022年,它们仍然处于有限的实验测试阶段。

Marcus在2016年就曾警告过,核心问题是边缘情况:

无人驾驶汽车在常见的情况下,是表现很棒。如果你把它们放在帕洛阿尔托的晴朗天气里,它们就很棒。如果你把它们放在有雪或有雨的地方,或者它们以前没见过的地方,对它们来说就很难了。Steven Levy 有一篇关于谷歌自动汽车工厂的精彩文章,他谈到了2015年底的巨大胜利是他们终于让这些系统识别树叶了。系统能识别树叶,这很好,但还有一些不那么常见的东西,就没那么多数据了。

这仍然是核心问题。直到最近几年,无人驾驶汽车行业才意识到这个现实。正如 Waymo AI/ML 工程师 Warren Craddock 最近在一个应该完整阅读的线程中所说的那样:

事实就是:有无数种边缘情况。有无数不同的万圣节服装。闯红灯的速度是连续的。无法枚举边缘情况。即使可以枚举边缘情况,也无济于事!

而且,最重要的是——

当明白边缘情况在本质上也是无限的,你就可以看到问题有多复杂了。深度网络的本质——它们的基本机制——意味着边缘情况很容易被遗忘。你不能只体验一次边缘案例,然后让它消失。

没有理由认为,机器人或具有自然语言界面的机器人(比如谷歌的新系统)可以免除这些问题。

可解释性问题

还有一个问题是可解释性。

谷歌对让系统如何在一定程度上可解释做了很大的努力,但没有找到明显的方法,将大型语言模型与那种(在微处理器、USB 驱动程序和大型飞机设计中常用的形式验证方法)结合在一起。

对,使用 GPT-3 或 PaLM 写超现实散文无需通过验证;你也可以欺骗 Google 工程师,让他们相信你的软件是有感知的,而无需确保系统是连贯的或正确的。

但是,处理各种家务的类人家庭机器人(不仅仅是 Roomba 的吸尘器)需要做的,不仅仅是与用户社交,它们还需要可靠、安全地处理用户请求。如果没有更大程度的可解释性和可验证性,很难看出我们如何才能达到这种安全水平。

无人驾驶汽车行业一直押宝的「更多数据」,成功的可能性并不是那么大。Marcus在2016年的那次采访中就这样说过,现在他仍然这样认为——大数据不足以解决机器人问题:

如果你想在家中拥有一个机器人——我仍然幻想着Rosie机器人会给我做家务——你不能让它犯错误。[强化学习]很大程度上是大规模的试错。如果你家里有一个机器人,你不能让它多次撞到你的家具上。你不希望它把你的猫放在洗碗机里洗一次。你无法获得相同规模的数据。对于现实环境中的机器人,我们需要的是让它从少量数据中快速学习。

谷歌和EveryDay Robots后来知道了这一切,甚至还制作了一段搞笑视频来承认这一点。

但这并不能阻止部分媒体得意忘形。<WIRED>用一个夸张的标题写了这篇文章,美化了研究情况,说得好像一个关键问题已经解决了似的。

谷歌的新机器人通过「网页抓取」学会听命令

这让人想起了 2015 年<WIRED>杂志上的两篇文章,都是同样的乐观标题,和从未落地的项目。

Facebook宣布开启M计划,向Siri和Cortana发起挑战

以及这一篇——

深度学习马上会让我们拥有超级智能的机器人

后来的故事我们都知道了:Facebook M流产了,7 年来,没有人可以以任何价格购买超级智能的机器人。

谁信谁是傻子

当然,谷歌的新机器人确实通过「网页抓取」(scraping the web)学会了接受一些订单,但机器人技术存在于细节中。

在理想的情况下,当机器人可选的选项数量有限时,性能大概在 75% 左右。机器人可选的动作越多,性能可能就越差。

Palm-SayCan 机器人只需要处理6个动词;而人类的动词有成千上万。如果仔细阅读一下Google的报告,就会发现,在某些操作上,系统的正确执行率为0%。

对于一个通用的类人家用机器人来说,75%还远远不够。想象一下,一个家用机器人被要求将爷爷抬到床上,但四次中只有三次成功。

没错,谷歌做了很酷的演示。但是离现实世界的产品,还远着呢。

PaLM-SayCan提供了对未来的愿景——在这个Jetsons一样的系统中,我们可以与机器人交谈,让它们帮助完成日常琐事。这是一个美好的愿景。

但Marcus表示:但我们中如果有谁——包括马斯克——在「屏住呼吸」,期待这样的系统在未来几年内实现,那他就是傻子。

Recommend

About Joyk

Aggregate valuable and interesting links.

Joyk means Joy of geeK