MVTN:用于3D形状识别的多视图转换网络(ICCV2021)

source link: https://zhuanlan.zhihu.com/p/424418012

Go to the source link to view the article. You can view the picture content, updated content and better typesetting reading experience. If the link is broken, please click the button below to view the snapshot at that time.

MVTN:用于3D形状识别的多视图转换网络(ICCV2021)

论文标题:MVTN: Multi-View Transformation Network for 3D Shape Recognition

摘要:多视图投影方法在3D形状识别方面能达到先进的性能,现有的这些方法学习从多个视图聚合信息。然而,对于所有形状,这些视图的相机视点往往是启发式设置和固定的。为了避免当前固化的多视图方法,研究人员引入了多视图转换网络 (MVTN),它基于可微渲染的最新研究进展实现3D形状识别的视点回归。因此,MVTN可以与任何用于3D形状分类的多视图网络一起进行端到端的训练。研究人员将MVTN集成到可以渲染3D网格或点云的新型自适应多视图网络中。MVTN在3D形状分类和3D形状检索任务中表现出明显的性能提升,而无需额外的训练监督。在这些任务中,MVTN在ModelNet40、ShapeNet Core55和最新的ScanObjectNN数据集上实现了最先进的性能(提高了6%)。同时研究表明MVTN可以针对旋转和遮挡提高网络的鲁棒性。

作者:夏初|来源微信公众号:3D视觉工坊

3D视觉精品课程推荐:

1.面向自动驾驶领域的多传感器数据融合技术

2.面向自动驾驶领域的3D点云目标检测全栈学习路线!(单模态+多模态/数据+代码)

3.彻底搞透视觉三维重建:原理剖析、代码讲解、及优化改进

4.国内首个面向工业级实战的点云处理课程

5.激光-视觉-IMU-GPS融合SLAM算法梳理和代码讲解

6.彻底搞懂视觉-惯性SLAM:基于VINS-Fusion正式开课啦

7.彻底搞懂基于LOAM框架的3D激光SLAM: 源码剖析到算法优化

8.彻底剖析室内、室外激光SLAM关键算法原理、代码和实战(cartographer+LOAM +LIO-SAM)

9.从零搭建一套结构光3D重建系统[理论+源码+实践]

研究贡献:

1.提出了MVTN网络,利用可微分渲染器,支持3D形状识别任务的端到端训练。

2.将MVTN与多视图方法相结合,在标准基线ModelNet40、ShapeNet Core55和ScanObjectNN上的3D分类和形状检索方面取得了当前研究中的最佳结果。

3.MVTN针对多视图旋转和遮挡问题,提高网络的鲁棒性,使MVTN在3D模型未完全对齐或部分裁剪的现实场景中更加实用。

研究方法:

1.MultiView 3D 识别概述

3D多视图识别通过从相同形状S的多个视点渲染定义了M幅图像,这些视图被输入至同一个骨干网络f中,使用该网络提取每个视图的判别特征,然后将这些特征在视图中进行聚合,进而用于下游任务,例如分类或检索。

Training Multi-View Networks:

上述公式中的这些参数表示影响渲染图像的属性,包括相机视点、光线、对象颜色和背景等。其中R是渲染器,它将形状Sn和参数u0作为输入以生成每个形状的M个多视图图像Xn。

Canonical Views:

以前的多视图方法主要依赖于与整个3D数据集预定义相关的场景参数u0。特别是,固定的摄像机视点通常是运用数据集中3D模型的对齐进行选择的。最常见的视图配置是圆形和球形,圆形是在对象的一个圆上对齐视点,球形是在对象的球体上对齐等距的视点。相比于上述方法,MVTN学习回归每个形状的观点,如下图所示。

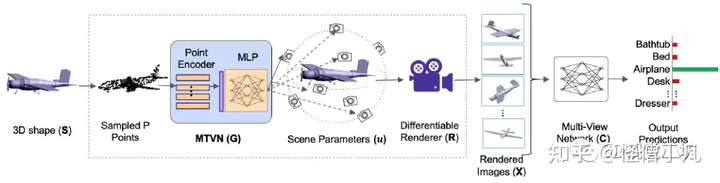

2.Multi-View Transformation Network (MVTN)

以前的多视图方法将多视图图像X作为3D形状的唯一表示,其中X使用固定的场景参数u0进行渲染。本文中考虑一般性的情况,其中u是可变的,但是其在±ubound范围内变化。该研究中,ubound是正数,它定义了场景参数的允许范围,将相对应角的ubound设置为180°和90°。

Differentiable Renderer:

View-Points Conditioned on 3D Shape.:

研究人员通过学习MVTN网络,将u设计为3D形状的函数。与依赖于恒定不变的渲染参数的上述公式不同,MVTN针对每个对象形状S自适应地预测u,并与分类器C一起进行优化。经过端到端训练,以最大限度地减少N个对象数据集上的损失:

该公式中,G通过编码一个3D形状以预测其针对特定任务的多视图网络C的最佳视点。由于G仅用于预测视点而不是对对象进行分类,因此其架构较为简单轻便。因此,研究人员使用一个简单的点编码器(例如PointNet中的共享MLP),处理来自S的P个点并产生维度 b上的粗略形状特征。然后,浅层MLP从全局形状特征中回归场景参数。为了控制预测参数u在允许的范围ubound内,研究人员使用由ubound缩放的双曲正切函数。

MVTN for 3D Shape Classification:

为了训练MVTN实现3D形状分类,研究人员定义了交叉熵损失,但也可以使用其他损失和正则化器。多视图网络(C)和MVTN(G)在相同的损失上进行联合训练。该多视图网络的一个优点是它能够无缝处理3D点云,这在以前的多视图方法中是不存在的。当S是3D点云时,简单地将R定义为可微分点云渲染器。

MVTN for 3D Shape Retrieval:

三维形状检索任务定义如下:给定一个查询形状Sq,在大小为N的集合中找到最相似的形状。对于这个任务,研究人员遵循MVCNN中的检索设置,并且考虑了C中分类器之前最后一层的深层特征表示,使用LFDA以减少将这些特征投影到更具表现力的空间中,并将减少的特征视为描述形状的特征。

实验设置与结果:

1.数据集:ModelNet40,ShapeNet Core55,ScanObjectNN

2.Baseline:Voxel Networks,Point Cloud Networks,Multi-view Networks

3.结构:研究人员选择MVCNN、RotationNet和ViewGCN作为在MVTN管道中选择的多视图网络。实验中,选择 PointNet作为3D点编码器网络G,从每个网格中采样P = 2048 个点作为点编码器的输入,并使用5层MLP进行回归网络,它将大小为b = 40的点编码器提取的点特征作为输入。所有MVTN变体和baseline多视图网络使用在ImageNet上预训练的ResNet-18作为C中的多视图主干网络,输出特征大小为d=1024。主要分类和检索采用基于 MVTN-sphereal和ViewGCN的多视图网络C。

4.实验结果:

相关实验结果如上面几个表格所示,其中表1在ModelNet40上比较了MVTN与其他方法的性能,与以前的方法相比,MVTN实现了93.8%的测试准确率。ViewGCN依靠来自更先进但不可微分的OpenGL渲染器的更高质量的图像来实现更高的分类性能。为了公平比较,研究人员使用MVTN中使用的渲染器生成的图像报告了ViewGCN的性能。使用相同的渲染过程,使用MVTN提高了基线ViewGCN在12视图和20视图的分类性能。研究人员认为可微渲染的进展将弥合渲染图像与原始高质量预渲染图像之间的差距。表2报告了12视图MVTN在实际ScanObjectNN基准测试上的分类精度。MVTN提高了数据集不同变体的性能。ScanObjectNN(PB_T50_RS)最困难的变体包括物体进行平移和旋转的挑战性场景。本研究中的MVTN在这个变体上取得了最先进的结果(+2.6%),突出了MVTN在逼真3D点云扫描方面的优点。表3报告了MVTN的检索mAP与最近在ModelNet40和ShapeNet Core55上的方法比较的结果。表4体现了对训练模型鲁棒性的检测。

总结:

当前的多视图方法依赖于与数据集对齐的固定视图。本研究中提出了MVTN,可以在完全可微中学习回归任何多视图网络的视点。MVTN利用可微渲染的最新发展,并且不需要任何额外的培训监督。上述实验结果体现了MVTN在3D分类和3D形状检索中的优势。MVTN未来的研究工作可能包括将其扩展到其他3D视觉任务,例如形状和场景分割。此外,MVTN可以包括与摄像机视点不同的更复杂的场景参数,例如光线和纹理。

本文仅做学术分享,如有侵权,请联系删文。

更多干货

欢迎加入【3D视觉工坊】交流群,方向涉及3D视觉、计算机视觉、深度学习、vSLAM、激光SLAM、立体视觉、自动驾驶、点云处理、三维重建、多视图几何、结构光、多传感器融合、VR/AR、学术交流、求职交流等。工坊致力于干货输出,为3D领域贡献自己的力量!欢迎大家一起交流成长~

添加小助手微信:CV_LAB,备注学校/公司+姓名+研究方向即可加入工坊一起学习进步。

Recommend

About Joyk

Aggregate valuable and interesting links.

Joyk means Joy of geeK