17

firefox 有个开源的本地大模型 https://future.mozilla.org/blog/introducing-llamafi...

source link: https://www.v2ex.com/t/1004272

Go to the source link to view the article. You can view the picture content, updated content and better typesetting reading experience. If the link is broken, please click the button below to view the snapshot at that time.

firefox 有个开源的本地大模型 https://future.mozilla.org/blog/introducing-llamafile/,什么样的机器能跑动

17 条回复 • 2023-12-29 16:15:24 +08:00

|

qping 8 小时 12 分钟前 没说要什么样的机器,但是说了 Supported OSes and CPUs 和 GPU support

https://github.com/Mozilla-Ocho/llamafile 要不你下了试试? |

|

godmiracle 8 小时 5 分钟前 我用 m1 就能跑起来。x86 的好像不行,没跑成功

|

|

qping 7 小时 55 分钟前 amd 7950x 可以跑,还挺顺畅的

有意思 |

|

bfdh 7 小时 15 分钟前 i7-12700 Linux 可以跑

|

|

Seanfuck 7 小时 0 分钟前 貌似是可以直接运行的文件:

AMD64 微处理器必须具有 SSSE3 。否则 llamafile 将打印一个错误并拒绝运行。这意味着,如果你有一个英特尔 CPU ,它需要是英特尔酷睿或更高版本(大约 2006 年以上),如果你有一个 AMD CPU ,那么它需要是推土机或更高版本(大约 2011 年以上)。如果你有一个较新的 AVX CPU ,或者更好的 AVX2 ,那么 llamafile 将利用你的芯片组特性去更快。目前还不支持 AVX512+运行时调度。 话说支持中文吗? |

|

weilongs 6 小时 32 分钟前 两周前看到这个跑过一下,我用的 MacBook pro 2019 款哪个 intel 的本子跑了一下,提出一个问题风扇就起飞了。体验感觉还不错,我体验了 LLaVA 1.5 和 Mistral 7b 。

|

|

jifengg 6 小时 23 分钟前 有意思,去体验一下

|

|

titan2022 6 小时 17 分钟前 4800H 也能跑,速度不算快 有中文

|

|

paopjian 4 小时 31 分钟前 用默认模型跑起来崩溃,用 Mistral 试了试,真不错啊,速度也有

|

|

zsh2517 3 小时 7 分钟前 NAS 上下完了一个模型,先试了试,可能 D1851 太老了,而且这种活可能本来也不适合 CPU 跑。速度感觉一般,而且没有 stream 模式。晚上拿台式机试试

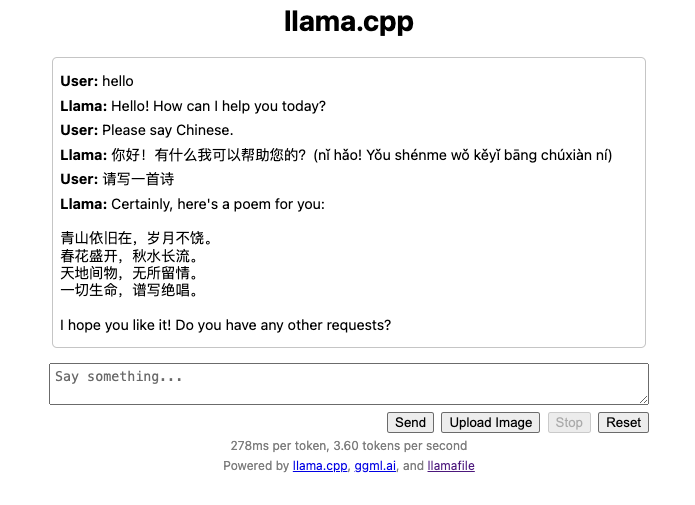

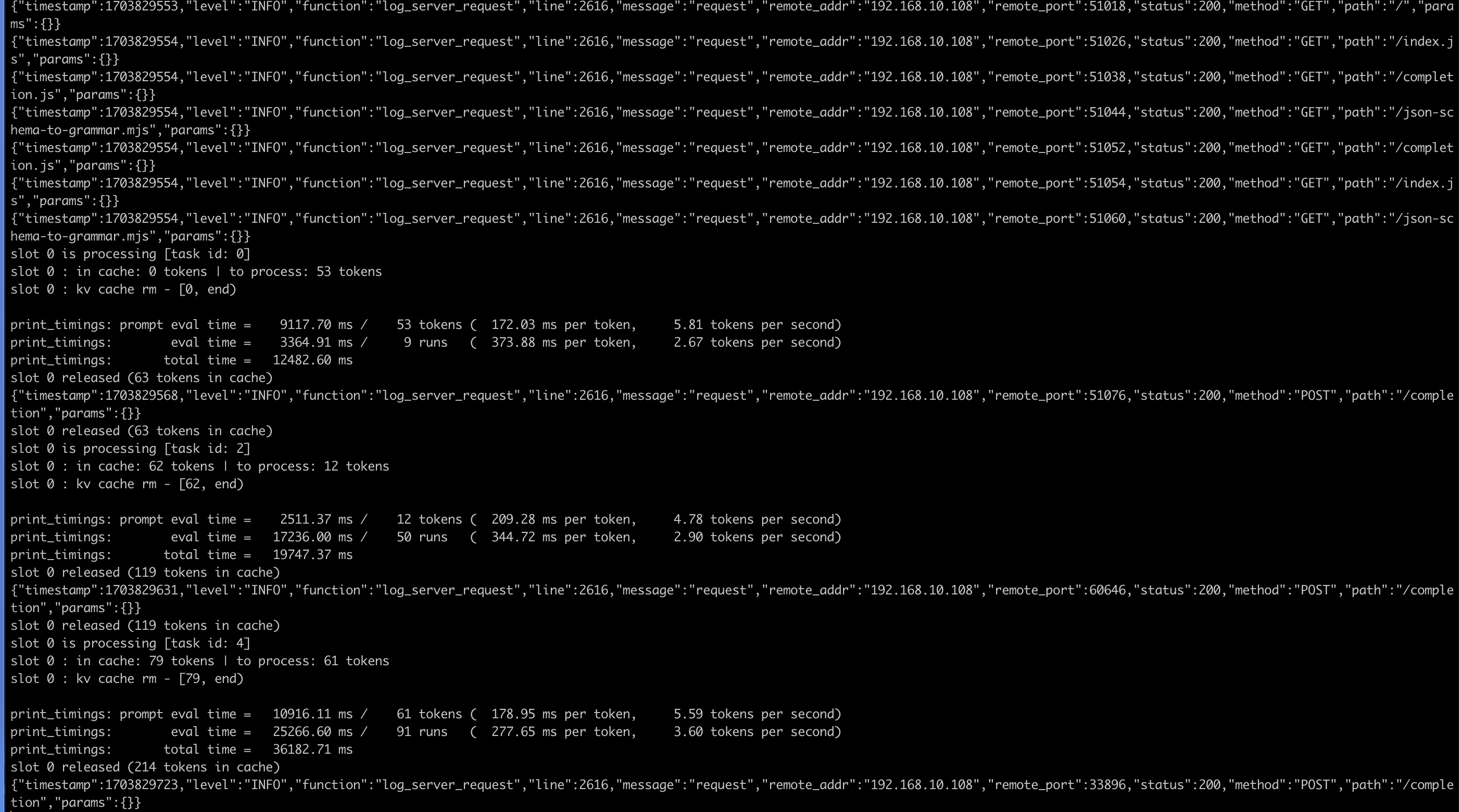

--- 对话截图 =>  控制台截图 =>  宿主环境 D-1581 32 核 64G ,pve LXC 容器 运行参数 ./llava-v1.5-7b-q4-server.llamafile --host 0.0.0.0 --port 1234 --threads 32 |

|

elonlo 2 小时 34 分钟前 我 windows 都跑起来了。i5-13500H

|

|

NoOneNoBody 2 小时 30 分钟前 |

|

Rache1 1 小时 24 分钟前 速度还行,就是不知道为啥,有时候会卡住 ?

|

|

iold 1 小时 0 分钟前 |

</body

Recommend

About Joyk

Aggregate valuable and interesting links.

Joyk means Joy of geeK