AI理解不了"他她它"咋办?动词成为新突破口,机器人听到抹黄油就知道拿刀叉...

source link: https://www.qbitai.com/2022/11/39987.html

Go to the source link to view the article. You can view the picture content, updated content and better typesetting reading experience. If the link is broken, please click the button below to view the snapshot at that time.

AI理解不了“他她它”咋办?动词成为新突破口,机器人听到抹黄油就知道拿刀叉 | 清华AIR&北大&英特尔

机器交互能力up

萧箫 发自 凹非寺

量子位 | 公众号 QbitAI

给AI下指令时,总觉得和人沟通不太一样?

没错,AI虽然能听懂一些具体的人类指令,例如:

帮忙从餐厅搬个椅子过来。

但要是换成只有代词(他/她/它/这/那/东西…)和动词的模糊指令,AI就一头雾水了:

帮忙找个能垫脚的东西。

现在,终于有研究人员想出了一种新的应对方法:让AI学会理解动词不就行了?

动词本身就和一些特定的名词绑定,例如“抹黄油”这个动作肯定离不开“刀”、“叉”这样的名词。

只需要将它们进行匹配,不需要“刀叉”这类名词指令,AI也能准确找出目标物体:

目前,这篇论文正式被NeurIPS 2022收录,相关模型也已经开源:

所以它究竟是如何训练AI理解动词的?

遮住名词让AI“看图找物”

论文提出了一种名叫TOIST的框架。

TOIST即“任务导向的实例分割Transformer”(Task Oriented Instance Segmentation Transformer),是一种基于Transformer的实例分割新方案。

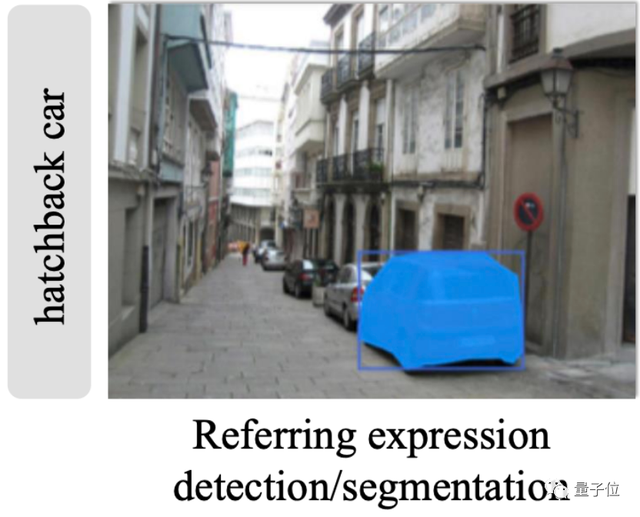

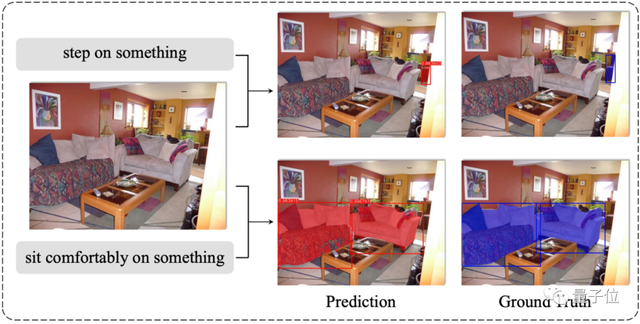

实例分割与语义分割的“全图切割”不同,它还具备目标检测的特点,例如下图凭借名词“掀背车”(hatchback car),直接找出对应物体:

此前,实例分割模型通常分为“两步走”,第一步检测可能的目标,第二步对可能的目标进行排序,预测出最有可能的结果。

但与这种方式不同,TOIST框架直接采用一整个Transformer架构,其中解码器中的自注意力机制可以建立候选目标之间的偏好关系。

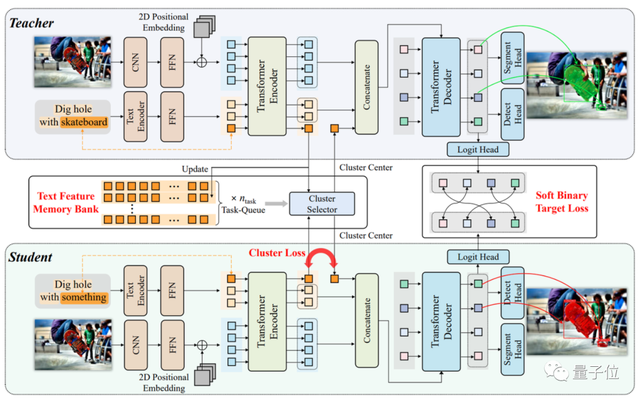

TOIST框架整体分为三个部分。

其中,多模态编码器(棕色部分)负责提取特征标记,Transformer编码器(绿色部分)负责将两种模态的特征聚合起来,并基于Transformer解码器(蓝色部分)中的注意力机制来预测最合适的目标。

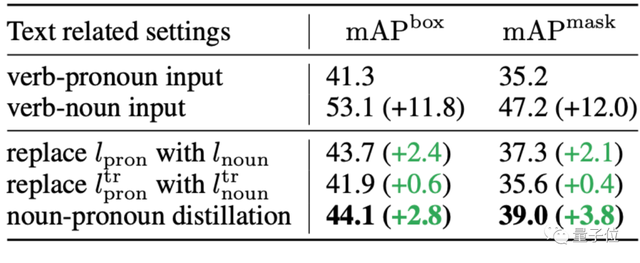

随后,论文提出了一种新的名词-代词蒸馏方法 (noun-pronoun distillation)来训练模型。

具体来说,即基于知识蒸馏(上图教师-学生模型)框架,以无监督学习的方式,训练AI凭借上下文来“猜测”名词原型。

例如原本的实例分割任务是“用滑板挖洞”,但在训练模型时,会把名词“滑板”(skateboard)用代词“某个东西”(something)替代:

这样AI在不知道名词的时候,也能凭空猜测出正确的名词,并在图中分割出正确的目标:

这样的分割效果,在实际案例中表现如何?

目标检测提升10.9%精度

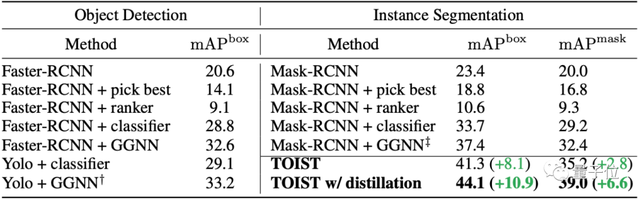

论文在大规模任务数据集COCO-Tasks上对TOIST进行了测试。

评估方法采用的是目标检测等视觉任务中常见的mAP(mean Average Precision)。

简单来说,TOIST比此前的实例分割和目标检测模型SOTA模型表现更好,而有了名词-代词蒸馏方法加成的“强化版”TOIST,表现又比TOIST更上一层楼。

其中在目标检测任务上,相比当前最好的Yolo+GGNN,“强化版”TOIST的判定框精度mAP提升了10.9%,在实例分割任务上,遮罩精度则比Mask-RCNN+GGNN高6.6%。

至于提出的名词-代词蒸馏方法,相比TOIST原版,又在实例分割任务上分别提高了2.8%和3.8%的精度。

具体到案例表现上,模型效果也与实际分割真值非常接近。

例如在图(d)中,算法甚至识别出来了能用桌子开啤酒瓶盖,可以说是理解能力满分了:

对于做这项研究的初衷,作者回应称:

我们实验室其实是负责研究机器人的,但在平时的调研中发现,用户有时候会更倾向于给机器人描述“需求”,而不是直接告诉机器人做什么。

换而言之,就是用AI算法让机器人“多想一步”,而非只是一个听从命令的助手。

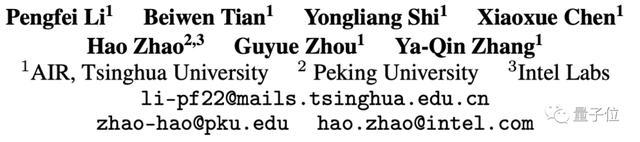

这篇论文的作者来自清华大学智能产业研究院(AIR)、北京大学和英特尔研究院,AIR院长张亚勤也是作者之一。

论文一作李鹏飞,清华大学智能产业研究院的在读博士生,本科毕业于中国科学院大学,研究方向是自动驾驶、计算机视觉等。

通讯作者赵昊,清华大学智能产业研究院助理教授(incoming Assistant Professor)、英特尔中国研究院研究科学家、北大联合博士后,本博毕业于清华大学电子工程系,研究兴趣是机器人、计算机视觉方向。

对视觉-语言大模型感兴趣的小伙伴们,可以试试这个新思路了~

论文地址:

https://arxiv.org/abs/2210.10775

项目地址:

https://github.com/AIR-DISCOVER/TOIST

Recommend

About Joyk

Aggregate valuable and interesting links.

Joyk means Joy of geeK