上线仅两天,AI大模型写论文网站光速下架:不负责任的胡编乱造

source link: https://www.51cto.com/article/740209.html

Go to the source link to view the article. You can view the picture content, updated content and better typesetting reading experience. If the link is broken, please click the button below to view the snapshot at that time.

上线仅两天,AI大模型写论文网站光速下架:不负责任的胡编乱造

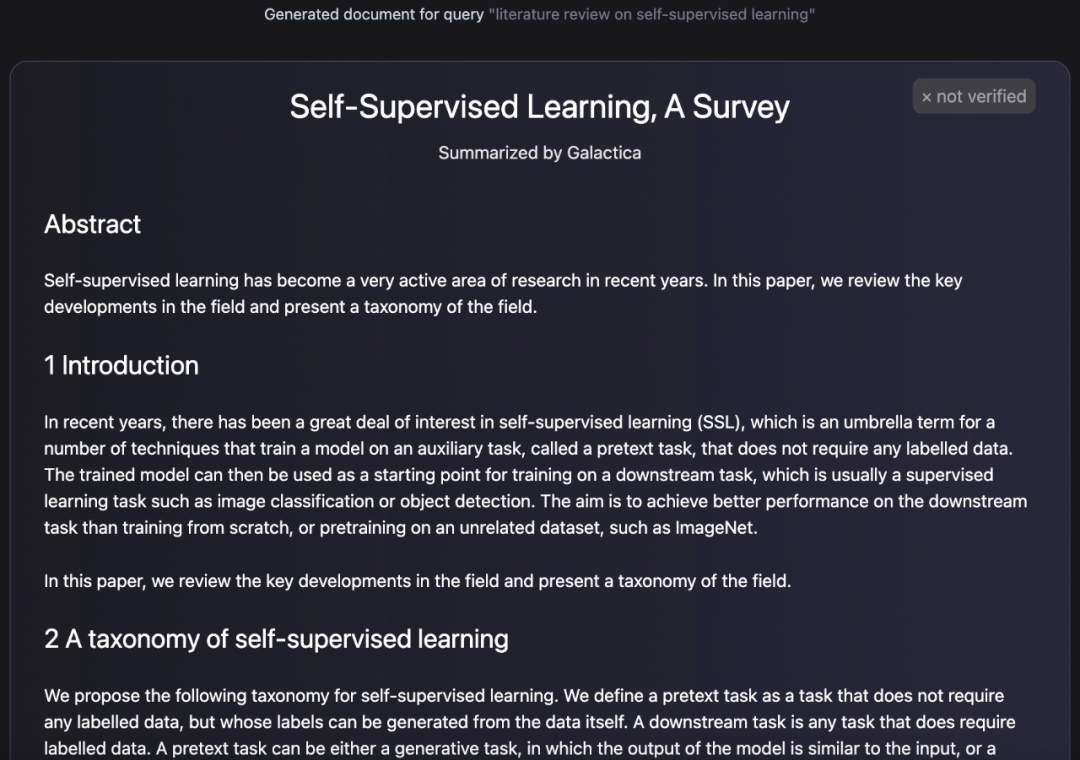

几天前,Meta AI 联合 Papers with Code 发布了大型语言模型 Galactica,该模型的一大特点就是解放你的双手,代笔帮你写论文,写的论文有多完整呢?摘要、介绍、公式、参考文献等统统都有。

就像下面这样,Galactica 生成的文本看起来就是一篇论文的配置:

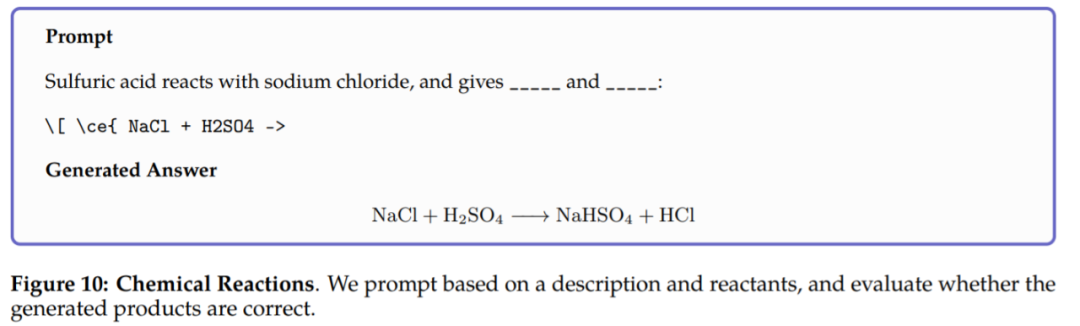

不止生成论文,Galactica 也可以生成词条的百科查询、对所提问题作出知识性的回答,除了文本生成外,Galactica 还可以执行涉及化学公式和蛋白质序列的多模态任务。例如在化学反应中,要求 Galactica 在化学方程 LaTeX 中预测反应的产物,模型仅根据反应物就能进行推理,结果如下:

为了方便用户体验这项研究,该团队还专门上线了试用版。如下图,几天前该界面还显示输入、生成等功能。

(之前版本)Galactica 试用版地址:https://galactica.org/

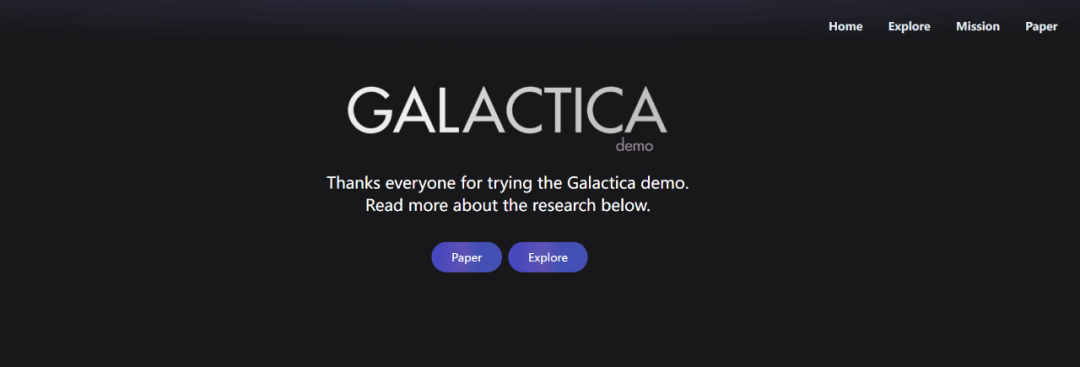

短短几天,它的界面变成这样,已经不能进行输入。

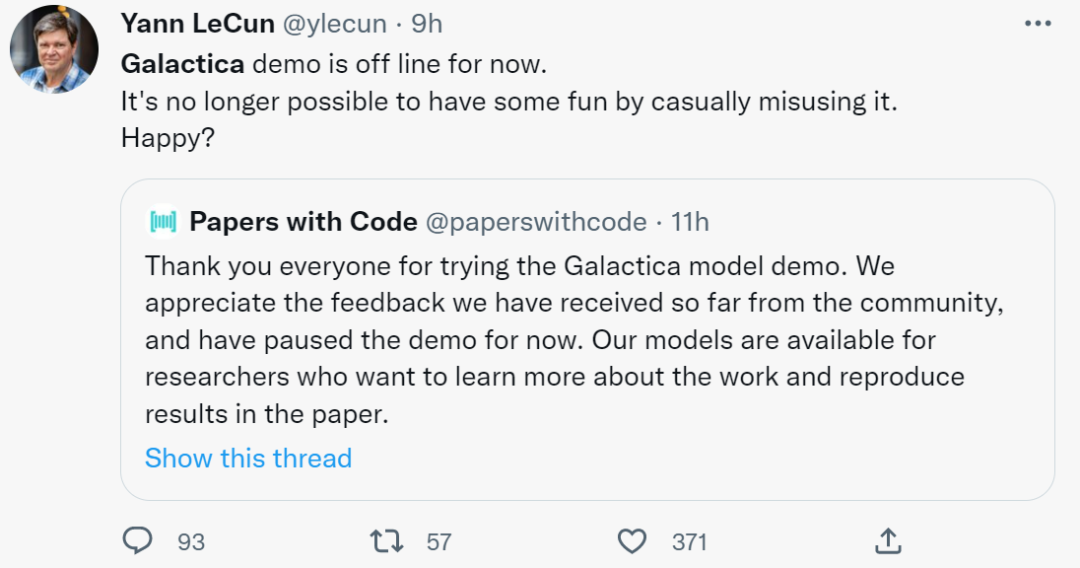

根据 Papers with Code 说法,他们从社区收到一些反馈,已经暂停 Galactica 的 Demo 演示功能。前两天还在推特发文称赞的图灵奖得主 Yann LeCun ,今天就很无奈的说了一句,再也不能从中获得快乐了,开心吗?

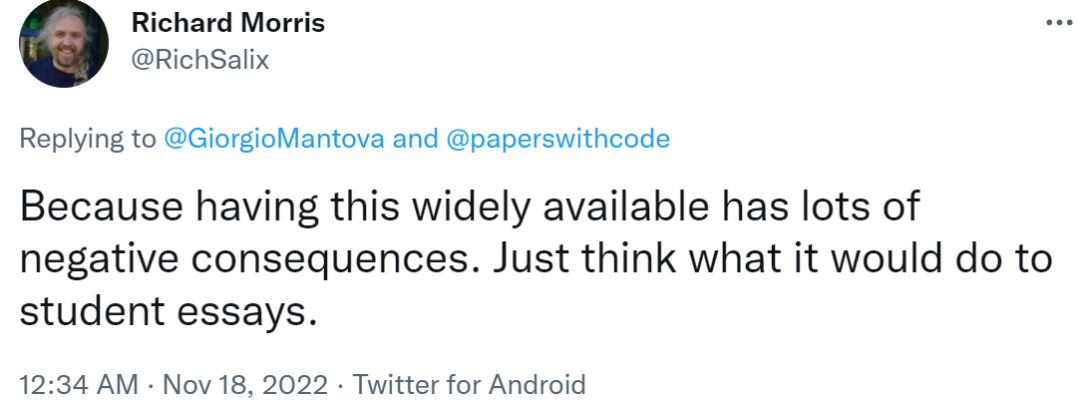

不过与极力推崇该研究的人相比,有网友提出一些反对意见,与其带来的好处相比,Galactica 会带来更多负面后果,想想这对学生写论文会有什么影响。

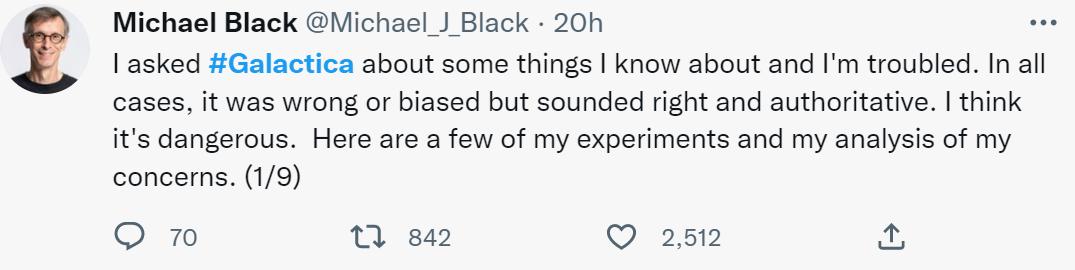

与学生用它来写论文相比,下面这位网友发现的问题就更严重了。

「我问了 Galactica 一些问题,它的回答都是错误或有偏见的,但听起来是正确和权威的。」在一系列实验后,推特用户 Michael Black 表示:「Galactica 生成的文本合乎语法,让人感觉真实。其所生成的文章会变成真正的科学论文。这篇文章可能是正确的,但也可能是错误的或有偏见的,很难被发现,从而影响人们的思维方式。」

「它提供了听起来是权威的科学,但没有科学方法的基础。Galactica 根据科学写作的统计特性产生伪科学,很难区分真假。这可能会开启一个深度科学造假的时代。这些被生成的论文将被其他人在真实的论文中引用。这将会是一团乱麻。我赞赏这个项目的初衷,但提醒大家还是要注意,这不是科学的加速器,甚至也不是科学写作的有用工具。这对科学来说是潜在的扭曲和危险。」

Michael Black 回答部分截图。链接:https://twitter.com/Michael_J_Black/status/1593133722316189696

发现 Galactica 存在不严谨、生成伪科学文章等问题的不止 Michael Black,其他网友也发现了该缺陷。下面我们来看看网友的其他评论。

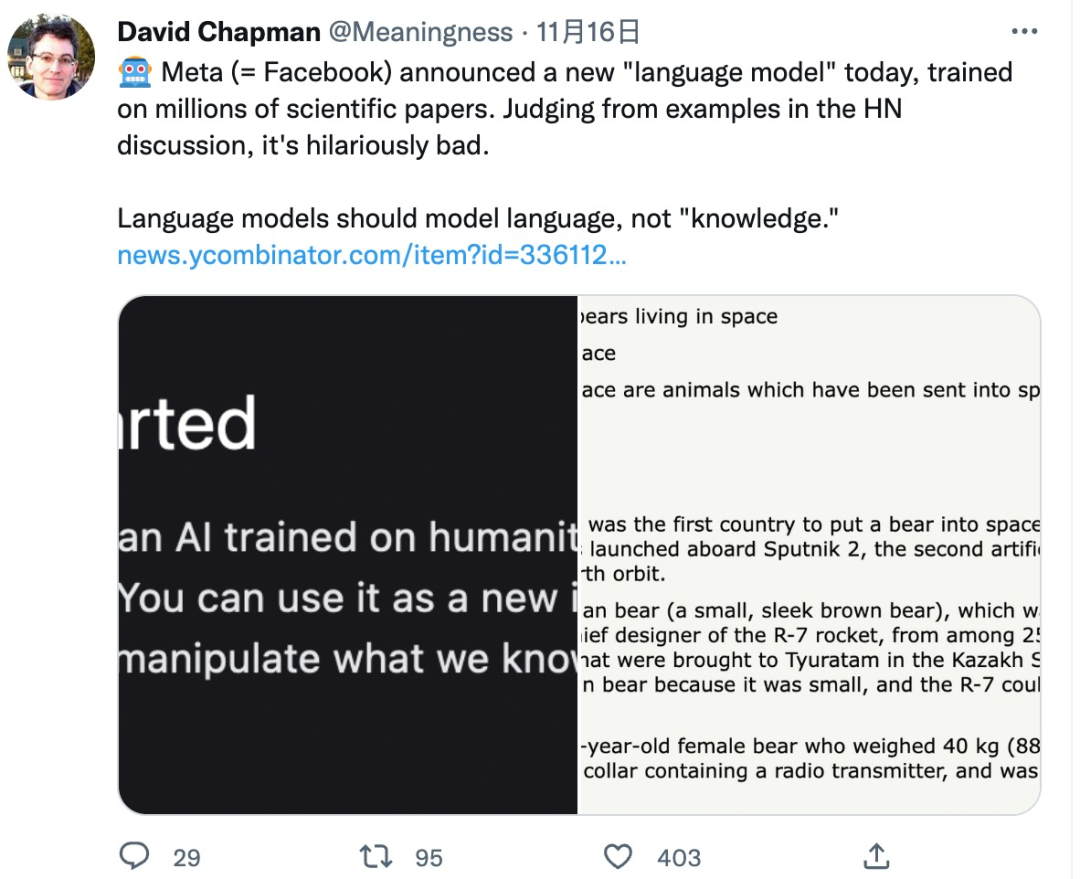

Galactica 试用版上线后,很多学者却对此提出了疑义。

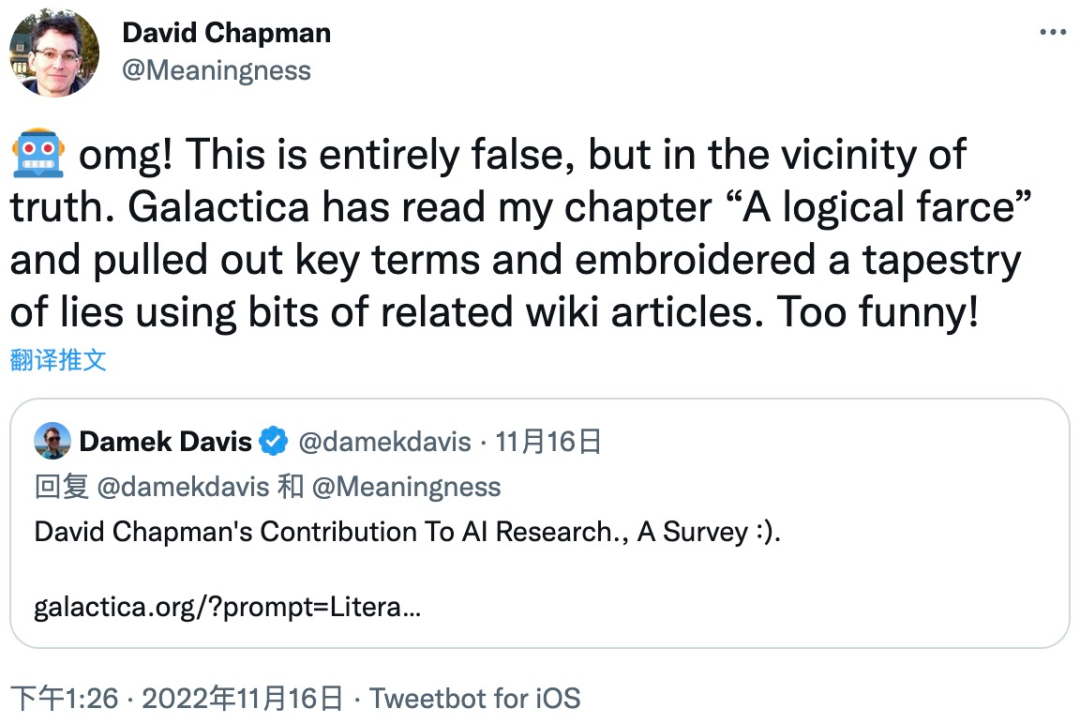

一位名叫 David Chapman 的 AI 学者指出语言模型应该是整理合成语言的,而不是生成知识:

这确实是一个非常值得思考的问题,如果 AI 模型能生成「知识」,那么如何判断这些知识的正确与否呢?它们又会如何影响甚至误导人类呢?

David Chapman 用自己的一篇论文为例说明了这个问题的严重性。Galactica 模型提取了论文中「A logical farce」部分的关键术语,然后使用一些相关的维基百科文章,最后编辑合成出一篇错漏百出的文章。

由于 Galactica 模型的试用版已下架,我们无法查看这篇文章与论文原意的差距有多大。但可以想象,初学者如果阅读了 Galactica 模型合成的这篇文章,可能会被严重误导。

知名 AI 学者、Robust.AI 创始人 Gary Marcus 也对 Galactica 模型表达了强烈的质疑:「大型语言模型(LLM)混淆数学和科学知识有点可怕。高中生可能会喜欢它,并用它来愚弄他们的老师。这应该令我们感到担忧。」

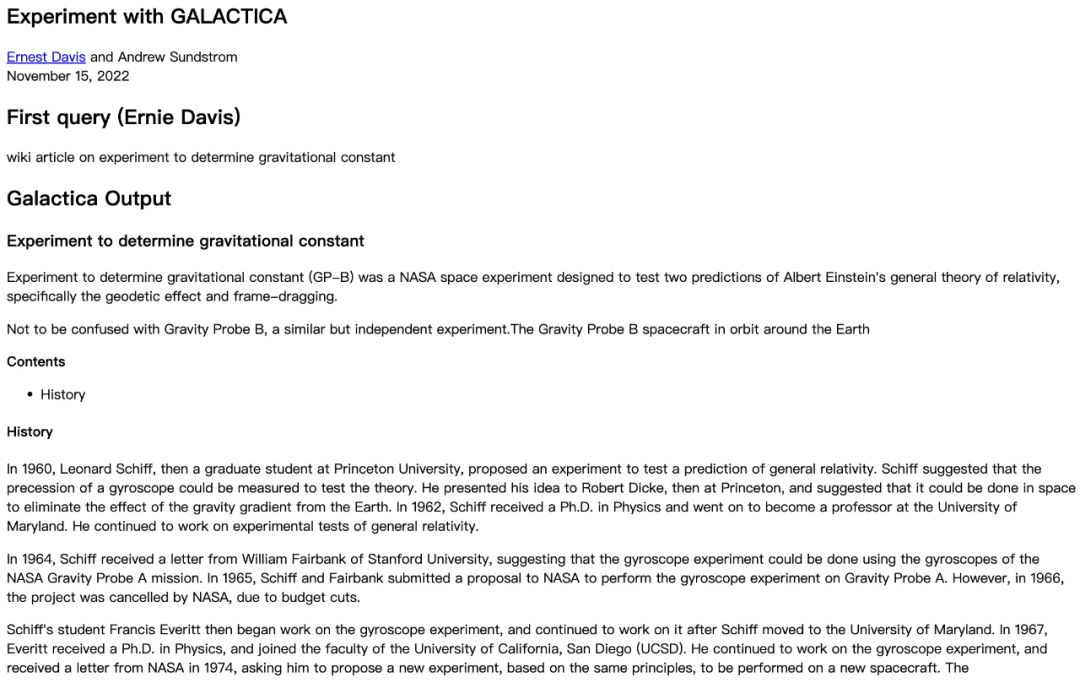

来自纽约大学计算机科学系的学者们也测试了 Galactica 模型的生成结果,发现 Galactica 答非所问:

图源:https://cs.nyu.edu/~davise/papers/ExperimentWithGalactica.html

首先,在这个实验中,Galactica 模型的回答的确包含一些正确的信息,例如:

- 引力探测器 B(GP-B)确实是 NASA 发射的科学探测,用于检验广义相对论的正确性和参考系拖拽效应。Leonard Schiff 确实是提出该实验的物理学家,Francis Everitt 是该项目的负责人(PI)。

- 引力探测器 A 确实是对爱因斯坦理论的早期检验。

然而,纽约大学学者提出的问题是:与确定引力常数的实验相关的维基百科文章,而 Galactica 模型回答的是「与检验广义相对论有关的实验的百科信息」。这从根本上就出现了错误。

不仅如此,Galactica 模型的回答中还有一些细节出现了事实性错误:

- Galactica 回答中强调不要混淆 GP-B 与引力探测器(Gravity Probe B)的实验,但实际上「GP-B」就是指「引力探测器 - B」的实验。

- 回答中提到的 Leonard Schiff 于 1937 年在麻省理工学院获得博士学位。他曾多次在宾夕法尼亚大学和斯坦福大学任教,但从未在马里兰大学任教。而 Francis Everitt 是在 1959 年于帝国理工学院获得博士学位的。

- 引力探测器 A(Gravity Probe A 在 1966 年并没有因为预算削减而被取消,也与陀螺仪(gyroscope)没有任何关系。实际上,引力探测器 A 于 1976 年发射,实验涉及微波激射器(maser)。

纽约大学的这项实验非常具体明确地说明了 Galactica 模型的生成结果存在严重的错误,并且该研究进行了多个不同问题的实验,每一次 Galactica 的回答都是错漏百出的。这说明 Galactica 生成错误信息的情况绝非偶然。

纽约大学实验报告:https://cs.nyu.edu/~davise/papers/ExperimentWithGalactica.html

面对 Galactica 的失败,有网友将其归因于深度学习的局限性:「深度学习的本质是从数据中学习,这本来就不同于人类的智能,根本无法实现通用人工智能(AGI)」。

关于深度学习未来的发展众说纷纭。但毫无疑问的是,Galactica 这种错误地生成「知识」的语言模型是不可取的。

Recommend

About Joyk

Aggregate valuable and interesting links.

Joyk means Joy of geeK