蔚小理接连撞车,真不怪他们?

source link: http://finance.sina.com.cn/tech/csj/2022-08-17/doc-imizmscv6628914.shtml

Go to the source link to view the article. You can view the picture content, updated content and better typesetting reading experience. If the link is broken, please click the button below to view the snapshot at that time.

蔚小理接连撞车,真不怪他们?

2022-08-17 20:15:12 创事记 微博 作者: 智东西 我有话说(3人参与)

欢迎关注“新浪科技”的微信订阅号:techsina

L2,难倒一众车企。

作者 | 昊晗 编辑 | Juice

来源:车东西

L2频繁出事故,问题到底在哪里?

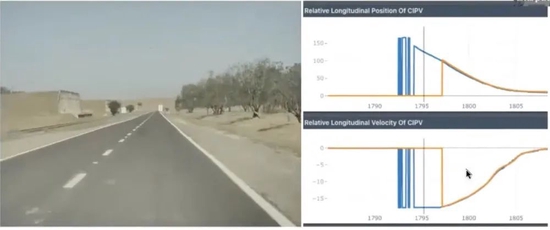

上周,在宁波市区的某高速路段上,一辆小鹏P7在开启LCC功能(单车道L2)行驶时,由于车辆系统没有识别到前方静止车辆,以80km/h的速度追尾前车,造成前车一人不幸遇难。

此前,像是蔚来、小鹏、理想、特斯拉等车企的车型也曾多次出现过类似事故。

本次事故发生后,有关自动驾驶(L2级)是否安全、事故如何归责等话题再次站上舆论的风口浪尖。

这里需要强调的是,按照自动驾驶等级划分,小鹏P7的LCC功能属于L2级自动驾驶,主要责任肯定在于驾驶员没有及时接管车辆。

除了驾驶员分神外,频发的事故或许也说明,现阶段的L2级自动驾驶系统本身也存在一定的问题。

总结近年来的L2事故来看,事故以追尾前方静止车辆、障碍物为主。也就是说,目前智能汽车上即使全身上下到处都是摄像头,各种雷达也是应有尽有,还是存在感知系统失灵的风险。

那么,为何会出现这样的问题?有没有什么办法可以弥补这一短板?车东西在深入分析事故案例并与业内人士交流后,找到了可能的答案。

01.

主责在驾驶员 但感知系统也要背锅

从事故现场的监控录像来看,这辆小鹏P7在发生碰撞前并没有明显的加减速,几乎是以一种匀速行驶的状态追尾前车。

而车辆当时开启了小鹏的LCC功能,该功能是指自适应巡航(ACC)与车道保持(LKA)同时开启,也可以理解成在一条车道内的L2级自动驾驶。

当该功能开启时,车辆会根据前车车距自动控制车速并在车道内居中行驶,而车主也可以自定义设置跟车距离的远近。

所以,车辆在发生碰撞前没有任何的减速或避让行为,也就一定程度上证明车辆大概率是没有感知到前方障碍或感知结果有误。

但这只是说明车辆感知系统存在一定的问题,而整场事故的原因还是由于驾驶员分神没有及时接管车辆导致,责任在驾驶员。

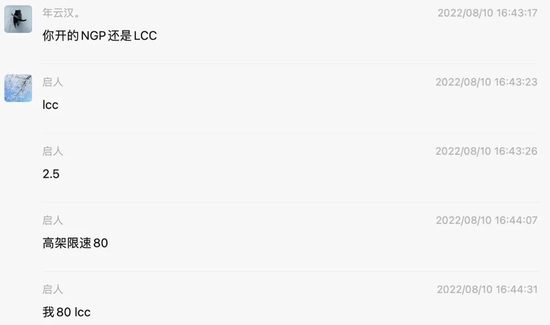

根据车主描述,他的小鹏P7搭载Xpilot 2.5硬件,感知硬件由1个单目摄像头、3个毫米波雷达、4个环视摄像头、12个超声波雷达组成,计算平台也不是高配车型上的英伟达Xavier,而是算力只有2.5TOPS的Mobileye Eye Q4芯片。

其中,单目摄像头、毫米波雷达主要为L2级自动驾驶提供感知,而4个环视、12个超声波雷达则主要为泊车提供感知。

根据资料显示,Xpilot 2.5的单目摄像头与Xpilot 3.0的中距感知摄像头基本一致,同为2M像素,横向FOV为52度,有效探测距离在30~70米之间。而毫米波雷达也采用了博世最先进的第五代毫米波雷达,探测距离也在200米左右。

从传感器配置来看,事故发生前,无论是摄像头还是毫米波雷达理应都能探测到前方障碍,车辆也就相应可以做出制动反应。但实际情况恰恰相反,车主反映系统没识别,车辆也没有刹车迹象。

这也就让人产生疑问,明明感知硬件都有,为什么识别不到呢?

02.

异形场景视觉看不清 雷达过滤静止物体

对于摄像头和毫米波雷达来说,只要正常工作的情况下,绝对是可以“看到”前方道路情况的。

但此处的“看到”仅限于看得见,问题根源是视觉识别不好异形场景,毫米波雷达会过滤静止物体,而此次事故的前车却恰好满足了“静止的异形车”两个条件。

首先,自动驾驶的视觉感知系统是需要大量的模型训练才能不断进化,什么场景训练得多,识别成功率也就相对更高,什么场景训练得少,识别成功率也就相对更低。

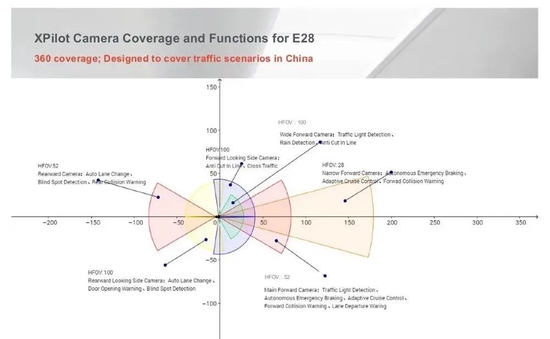

在此次小鹏L2事故中,被撞车辆是一辆老款帕萨特,其车身高度、颜色与旁边隔离带比较接近。并且,当时车辆正停在高速路的最左侧车道,一名白衣服的乘客蹲在车辆与隔离带之间,车辆的右后方有一个雪糕桶。

显然,上述场景对于视觉感知系统来说是陌生且复杂的,所以前方的“障碍”对于车来说,很难被系统识别为一台需要做出反应的车辆。

此外,在事故发生前几秒,前车车主又来到车尾调整雪糕筒位置,行走过程中挡住了车辆的车轮、尾灯等部件。

有业内人士告诉车东西,车辆的视觉识别算法会依靠车轮、尾灯等车辆特征点进行识别,当车辆跟行人重叠在一起时,将会对识别算法产生非常大的干扰。

所以,当时小鹏P7上摄像头的内心独白是:“前面是个障碍吗?我咋从来没见过?咋越来越模糊?到底有没有呀?让毫米波雷达给我确认一下”

然后,识别的压力就来到了毫米波雷达身上。

简单来说,毫米波雷达是通过向外发射电磁波产生回波进行测距、测速,其感知并不依赖大量模型训练,因此也就不会出现视觉那种“纠结”的情况,看到了就是看到了,没看到就是没看到。

但毫米波雷达也有自己的“BUG”,其主要是依靠多普勒效应来感知移动目标。而多普勒效应的特性是,动态对动态最容易感知、动态对静态较难感知、静态对静态极难感知。

所以,如果前方车辆静止,目标信息容易和地杂波等掺杂在一起,需要一定的算法才能从中分辨出目标。而如果是一辆行驶中的汽车,基于其多普勒信息,从而比较好探测到目标。

这里就跟当前毫米波雷达的技术现状有关了——一般的毫米波雷达没有高度信息,同时空间分辨率不足。

没有高度信息,意味着雷达很难区分横穿马路的路牌和桥下的车;空间分辨率不足,意味着两个距离很近的物体,其回波会被混在一起,很难知道有几个目标。

如果很难区分,再把静态目标错误识别为车辆,然后进行刹车会严重影响用户体验,甚至增加事故,所以一些雷达公司和自动驾驶公司会选择将静态物体(包括车)过滤掉,来减少误触发(幽灵刹车)的情况。

而毫米波雷达的内心独白可能也就是“前面确实有个静止物体!高速上怎么会有静止的车呢?一定是个桥或者隔离带!问题不大,告诉视觉前方一切正常。”

并且,国内目前量产的L2自动驾驶系统有不少都将视觉作为主传感器(权重高),雷达当作辅助传感器(权重低)。如果视觉发现障碍物,不管雷达有没有发现,车辆都会做出反应,但反过来就不行。

比如只有雷达看到前方有障碍物,系统会等待视觉给出结果再做反应。如果视觉始终没有给出结果,干脆就不反应——毕竟L2还有人类驾驶员兜底。

所以具体到这起事故,可能的原因正是因为视觉没看到,或者没有及时看到,毫米波雷达看到了,但被过滤掉了,才导致碰撞。

03.

激光雷达可以增强感知 前融合或为最优解

综上来看,异形+静止(低速)的车或障碍也就成为现阶段L2级自动驾驶系统的一大“BUG”。

这种场景出现的概率虽然不大,但大多发生在高速路况下,事故的伤亡率也就相对更高,所以这个“BUG”不能忽视。

对此,车企最简单粗暴的做法就是在现有摄像头和毫米波雷达基础上,再引入激光雷达,甚至是多个高线束激光雷达,大幅提升感知能力。

相较于毫米波雷达和摄像头,激光雷达的探测精度更高,点云密度更高。并且激光雷达也不像摄像头那般需要对前方物体进行分类识别,只用通过反射回来的点云信息确认前方存在一个障碍物就可以,然后系统对此做出规避,能够提升车辆在面对异型障碍物时的驾驶安全性。

但随着激光雷达的加入,多传感器融合方案又新增了一个信息来源,并不能从根本上解决上述问题,还是会存在各个感知结果之间相互“打架”的问题。

此前就有传闻称,小鹏P5的激光雷达在其感知系统中的置信度并不高,主要还是以视觉感知为主。对此,车东西也对加入激光雷达后的小鹏LCC功能进行了实际测试。

当时,车东西选择的车道前方刚好有一辆货车,随后同时打开了ACC和LCC,确保车辆是在辅助驾驶系统下前行。

出发没多久之后,小鹏P5就识别到了前方的静止车辆,车辆仪表盘上清晰地显示出前方存在一辆车。

不过此时,小鹏P5并没有明显的降速,而是在车机页面提醒驾驶员接管,同时安全带也开始收紧来提醒驾驶员。在车东西没有主动接管的情况下,车辆自动退出了LCC,但仍然保持着ACC状态。

这也就证明,至少在现阶段,激光雷达是用上了,但又没完全用好。

那么,怎么才能彻底解决各传感器之间相互“打架”的问题呢?让多传感器之间实现取长补短呢?

具体来说,现阶段大部分车辆的感知系统都是独自感知、独自处理、独自输出,当所有传感器完成感知之后,再由系统进行所有感知结果的融合。在这个过程中,各个传感器在不同场景下也就有不同的置信度。

所以,如果将各个传感器的感知在像素层面就进行对齐,然后系统使用同一种感知算法对融合后的多维数据进行感知,进而输出感知结果。这种方法也就不用考虑更相信哪个传感器的数据,不用再纠结。

这样,置信度的概念也就不复存在,各传感器之间也就能做到取长补短,融会贯通。

当然,前融合也存在像素难以对齐的难题。

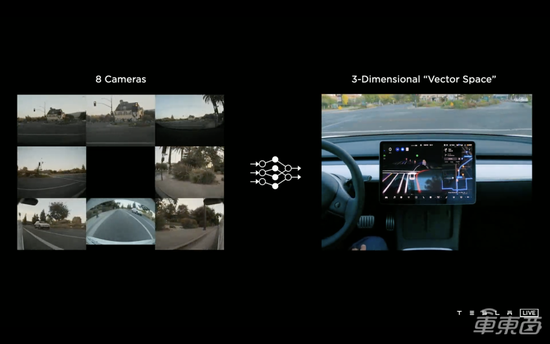

特斯拉开发了“向量空间”技术,该技术可以通过8个摄像头输入的数据为基础绘制3D鸟瞰视图(BEV),形成4D的空间和时间标签的“路网”以呈现道路等信息,帮助车辆把握驾驶环境,更精准地寻找最优驾驶路径。

而理想汽车在BEV感知融合算法当中,又融合了激光雷达和高精地图的信息,进一步提升了极限情况下的感知能力。

所以,现阶段激光雷达上车只是第一步,多传感器之间实现前融合才是最优解。

04.

结语:辅助驾驶系统不是自动驾驶

目前,有不少消费者都把辅助驾驶当成全自动驾驶来使用,开车睡觉、“主驾无人”等危险场景层出不穷。

此次事故,再一次为自动驾驶系统的使用敲响了警钟,车企不能对消费者过度宣传自动驾驶的能力,并需要强制要求使用者在开启高级辅助驾驶功能时,仍需要实时关注道路情况,应对车辆无法处理的情况。

(声明:本文仅代表作者观点,不代表新浪网立场。)

Recommend

About Joyk

Aggregate valuable and interesting links.

Joyk means Joy of geeK