人人都能用的多语种大模型来了!支持59种语言,参数1760亿,1000名科学家联合发起

source link: https://www.qbitai.com/2022/07/36222.html

Go to the source link to view the article. You can view the picture content, updated content and better typesetting reading experience. If the link is broken, please click the button below to view the snapshot at that time.

人人都能用的多语种大模型来了!支持59种语言,参数1760亿,1000名科学家联合发起

动用法国超算训练而成

丰色 发自 凹非寺

量子位 | 公众号 QbitAI

一直以来,很多大模型都由造它们出来的大型私营科技公司垄断着。

比如GPT-3等,对于普通人来说,再香也只能眼巴巴看着。

不过现在,为了给你解馋,由近1000名科学家联合发起的一个志愿项目,耗时一年多炼出了一个号称和GPT-3一样强大的语言模型。

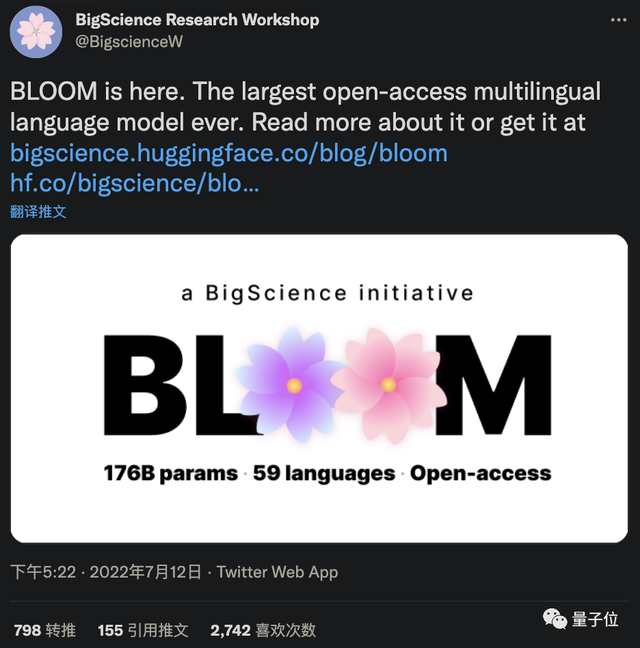

它的名字叫BLOOM,参数1760亿,不光支持英文或者中文,连西班牙语、法语等59种语言都支持,是目前最大的多语言开源语言模型。

是的,从现在起,从代码到数据集,BLOOM全部对外开放,所有人都可使用。

动用法国超算、花费384块A100

BLOOM是一个BigScience项目,去年5月启动,由Hugging Face主导,收到了700万美元的公共捐款。

共有来自全球60个国家、超过250个机构,以及超过1000名研究人员参与其中,其中包括以个人名义参加的Meta、谷歌等大厂员工。

它的训练在法国超级计算机Jean Zay上进行,共花费了384块A100 GPU,其中每块有80 GB内存,训练吞吐量约150 TFLOP(该超算由低碳的核能提供动力,释放的热量还用来给学校供暖)。

相关推特账号从3月14日起,每天记录BLOOM的进度。

随着进度条渐渐拉满,每天去点赞的人数也越来越多。

不过,到了102%它才正式停下——

7月2号,耗时117天的BLOOM宣告完成,恰好在预期计划时间内。

最终,BLOOM:

- 拥有1760亿参数,比GPT-3还多10亿

- 包含70层,每层112个注意力头

- token序列长度为2048

- 采用GeLU激活函数

- 数据集共计3416亿条token(1.5TB文本数据)

- 支持13种编程语言、46种语言

其中,对于很多语言来说,比如法语、西班牙语和阿拉伯语等,都是首次有了自己的开源模型(有网友发现日语目前还不支持)。

此外,为了让BLOOM最后的生成结果尽可能地减少偏见,参与人员还费了不少功夫抓取到的数据还进行了一遍人工过滤。

目前,BLOOM的训练对硬件也还是有一些要求:

为了保证效果,最好是准备8块80GB或者16块40GB的的A100。

这导致只有稍微大点的团队才能用。

当然也可以选择在云上训练,最高每小时40美元。

最后,BLOOM表示还会降低使用门槛,并准备开发一个分布式系统,允许实验室在其服务器之间共享模型。

它声称自己将会成为一个模型家族,不会一劳永逸。

Hugging Face地址:

https://huggingface.co/bigscience/bloom

参考链接:

[1]https://twitter.com/evanmiltenburg/status/1546792818269732864

[2]https://techcrunch.com/2022/07/12/a-year-in-the-making-bigsciences-ai-language-model-is-finally-available/

Recommend

About Joyk

Aggregate valuable and interesting links.

Joyk means Joy of geeK