京东张政:内容理解在广告场景下的实践和探索 - DataFunTalk

source link: https://www.cnblogs.com/datafuntalk/p/16386811.html

Go to the source link to view the article. You can view the picture content, updated content and better typesetting reading experience. If the link is broken, please click the button below to view the snapshot at that time.

分享嘉宾:张政 京东 算法工程师

编辑整理:AMS 周金星

出品平台:DataFunTalk

导读: 内容生态建设是近几年互联网快速发展的关键动因,也是AI化的重点方向之一。本文主要分享在京东广告业务下内容理解体系的建设情况,从标签化、内容准入、质量美学评价等多个角度探讨内容理解能力的应用;同时整体介绍智能创意助力广告内容生态建设,从内容理解到内容生成(视频、图片、文案),再到内容分发,并穿插OCR、智能抠图、多模态等相关的基础前沿算法能力。

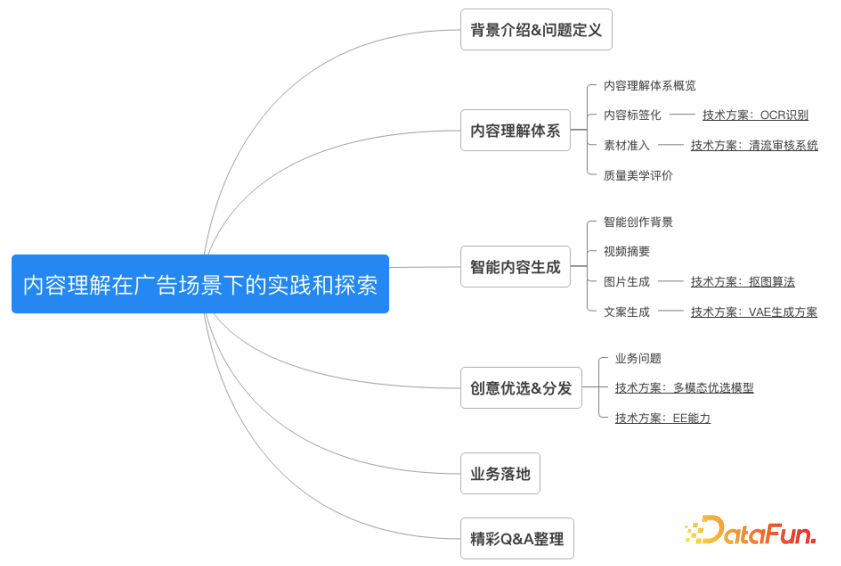

本文将围绕以下几部分进行展开:

- 内容理解体系

- 智能内容生成

- 创意优选&分发

01 背景介绍&问题定义

为什么要做智能创意?由图可见,从04年开始内容化生态逐步崛起,带动了互联网的新一波发展,特别是短视频,涌现出了如抖音、快手等一系列新媒体,目前已拥有大量受众。另外,像京东、阿里这类电商平台也在做内容化,直播、视频、互动等新玩法,加速了内容化的能力建设。因此总结两点:

- 流量的内容化成就了互联网的增量

- 内容的电商化开始引领主流趋势

针对庞杂的信息,如何更好地理解并推荐给用户,是智能创意要解决的问题。同时在内容化建设的大背景下,平台方也承担了广告内容生态建设的关键职责。

对智能创意的定义是:通过AI对商品内容进行理解,在感知学习的基础上构建规划和推理能力,基于实时的生成引擎和素材挖掘来构建视频、图片、文案的创意,并通过创意优选来实现精准的用户匹配。可以简单归纳为三个阶段:内容的理解、生成和分发。

上图呈现了智能创意的全过程,也是本次分享内容的主要框架:

1. 内容理解

最左边是商品信息,京东站内拥有数以亿计的商品,每个商品的内容信息包括了标题、主图、商品详情图、用户评论等。基于这些数据,可以做很多事情,比如借助NLP,可以通过标题压缩来生成短标题或者新标题,通过主颜色识别或者商品识别来建立图片内容的标签,从而判断图片是否足够优质,是否适合作为广告露出。

2. 创意生成

借助CV能力,可以通过布局理解或素材挖掘,对商品详情图进行结构化的分析,借助智能裁剪生成新图片来更突出商品的主体或者卖点等。借助视频分析,可以通过人的检测或行为识别,对视频里的优质片段或精彩点进行摘要,再提取更优质的内容让用户更容易get到商品卖点。在这些基础上,构建的就是内容的标签化,在内容标签化构建完成后可以借助智能搭配能力来进行创意生成。

3. 创意分发

创意内容存在多样性,如何更好地体现卖点,就要借助创意优选,创意优选是一个内容的分发阶段,分发阶段需要解决的问题是如何基于优选模型来实现生成内容和用户的个性化匹配,后文会讲到多模态算法的应用。在京东的电商体系下,内容是一个天然的多模态场景,它包含文字、视频、图像、语音等各种多模态数据,如何对这些数据进行更好地融合和表征,是做好内容分发的关键点。

02 内容理解体系

1. 内容理解体系概览

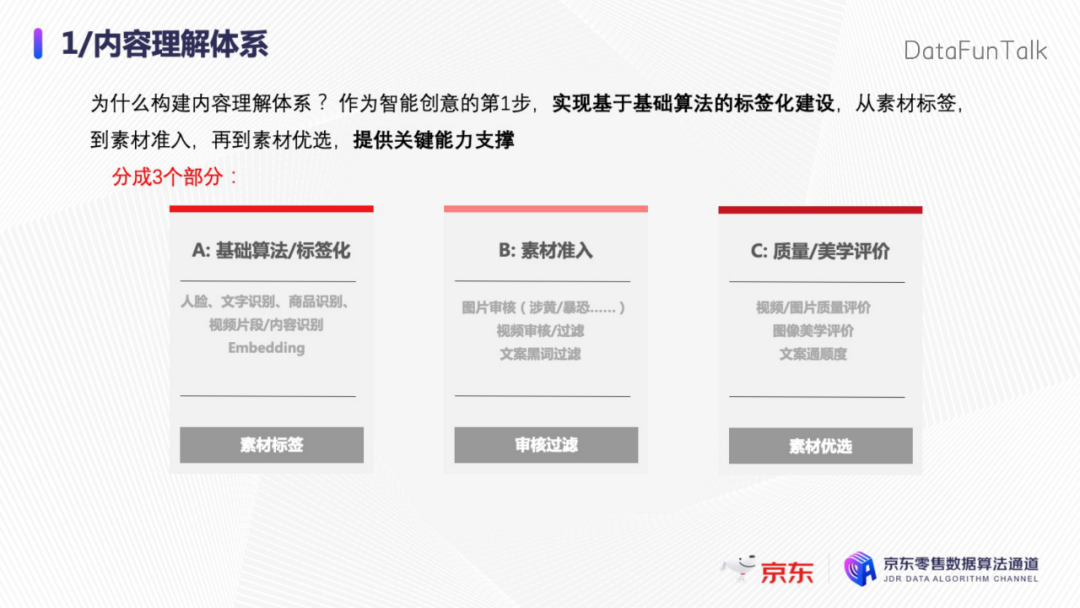

为什么要构建内容体系?作为智能创意的第一步,它用于实现基础算法的标签化,从素材标签到素材准入,再到素材优选,都可以提供关键的能力支撑。内容体系分为三个部分:

- 第一部分是基础算法以及内容标签化,底层用到了大量的基础算法;

- 第二部分是素材准入,是指通过审核解决数据筛选和过滤问题;

- 第三部分是质量和美学的评价,即如何去从众多内容中筛选优质的素材或者创意。

2. 内容标签化

如上图,先通过场景分类或者语义分割提取图片的背景,是天空还是草地。同时,借助商品检测去检测里面的人,或者他背的包,借助商品分割,可以精确地分割商品的边缘。有了边缘信息后,对商品的细节特征进行分析,比如得到商品属性:黑色的女包。商品属性可以用于后续的商品检索,通过找到类似的商品进行内容的召回和推荐。关于商品标题,可以从标题去做基础解析,比如抽取产品词、属性词、修饰词等。

对于整个图片,能通过美学的质量评价给图片打分,比如画面是否足够清晰,亮度是否正常等,以及基于logo检测,检测图片上有没有商品logo等。

算法角度,对于图片,有大量图像算法可以去做分析,但因为内容理解本身会受限于基础算法的准确度,在实际业务上可能会面临非常大的挑战。比如我们基于MS COCO的数据集,在做检测的时候AP0.5只能做到78%,同样每个底层算法都会面临准确度的问题。在电商场景下,因为商品类型更具有多样性,所以面临的挑战会更大。

庞大的商品体系会导致面临商品类别的多样、类别相似、内间样本不均衡等问题。同时和自然场景不一样,电商场景因为存在大量的handmade,比如图片上加的牛皮癣等。为了解决这些问题,我们前期进行了大量的数据集标注、数据集的仿真和增强,同时也构建了一套底层的基础算法服务,可以保障整体的服务效率,对模型进行了轻量化的TensorRT加速等等工作。最终形成了一套基础的商品结构化的素材库, cover了亿级别的SKU,通过对这些商品内容进行结构化的提取,应用于各业务线。

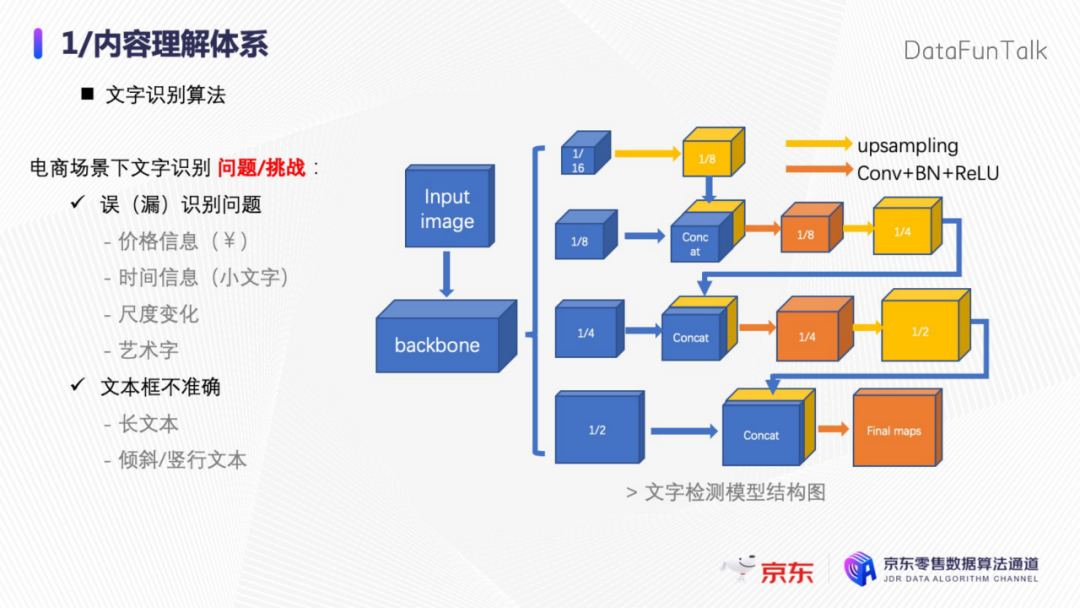

基础算法以OCR识别为例展开讲解。OCR现在的应用非常广泛,比如安防监控领域的车辆识别,金融领域的票据识别,在线教育的考题识别等。虽然文字识别算法经历了长期的发展,基于深度学习效果上也取得了非常大的进步,但目前仍存在很多挑战,比如背景的干扰、不规则的文字等,这些都成为制约算法效果的典型问题。同时针对多尺度、不同语言、密集文本行等问题,也对算法的准确性和鲁棒性提出了更高的要求和挑战。

对于电商场景同样如此,作为内容理解和生成中调用最多的算法,OCR在智能创意的体系中扮演关键的角色。我们面临的问题有误检或者漏检:内容包含价格信息、时间信息、尺度的变化、艺术字等;对文本框检测不准确:可能会遇到特别长的文本,或者是倾斜的、竖版文本等。

面对这些问题,我们从数据标注、数据仿真、模型设计以及模型加速等几个方面建立了一套专门的体系。上图右边是一个典型的检测模型结构图。

文字识别算法分为检测和识别两部分,表格模型对比展示了我们检测算法的检测效果。主流的文字检测算法分为三种:

- 第一种是Anchor-based的方法,最早的fast R-CNN就是基于Anchor-based去做的

- 第二种是基于Anchor-free的回归方法

- 第三种是基于分割的方法

Anchor-based的回归方法是从传统的目标检测算法发展而来,通过调整Anchor的宽高比来适应文字检测中宽高比过大的问题,经典的算法有Textboxes等,这类方法比较简单直接容易理解,但问题是有了Anchor以后,召回比较高,但是精度较差,而且它会受限于Anchor的配比,例如要检测宽高比为 3:1 的Anchor,对于宽高比为 10:1 的长文本检测能力就会比较差。

还有一些问题比如倾斜,对于倾斜问题也有一些新算法,比如RRCNN来通过预测一个旋转角来解决。随着网络表达能力的提升,一些Anchor-free的方法也取得了比较不错的效果,且速度上也有明显优势,其中比较有代表性的是East算法,它可以预测每个点到文本框或者文本框顶点的距离,通过这种方式来回归矩形框,该方法在工业界得到了很好的落地,我们前期也用过。

第三种方法,比如近些年大家都在研究基于弯曲的检测等方法,都是基于分割的方法,也就是通过判别图像中每个像素是否属于某个文本框,这样可以检测出任意形状的文本框,比较经典的有一些PSEnet或者DBnet等,基于分割的方法主要挑战在于如何分离不同的文本实例,上述方法都提出了自己的解决方案,尤其是DBnet,可以大大缩短后处理的时间。

对于检测模型的优化,我们在实际的商品详情页上,基于大量的商品数据统计了其中具体的文本分布,包括文字、字体、字号、颜色、方向等,并结合这个数据标注以及样本仿真来构建了一个十万量级的数据集。虽然效果上已经很不错了,但是对于一些特别小的字体,仍然有很大的提升空间。目前我们的线上OCR模型每天调用上亿次,面对如此庞大的应用,我们也通过轻量级的模型包括TensorRT加速来实现高吞吐率和TP99的性能。另外对于数据集,我们目前准备增加一些多模态的数据标注,比如商品的类目、品牌等信息,后面有合适的机会我们也会将该数据集开源。

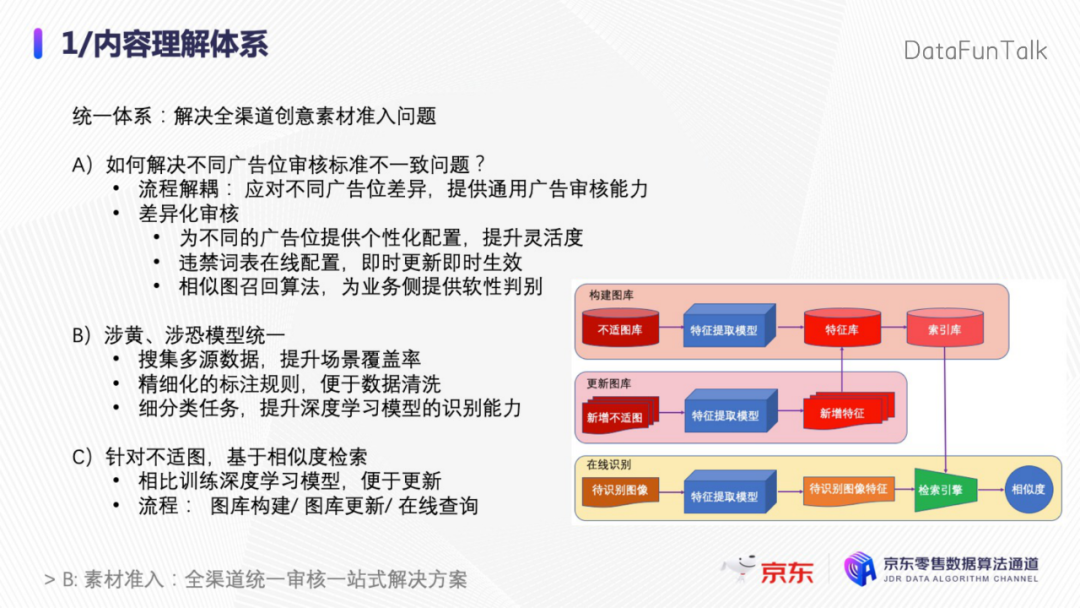

3. 素材准入

内容理解的第二部分主要解决的是素材的准入问题。为什么要解决这个问题比较好理解,比如你在逛京东的时候,不希望突然看到一个恐怖的商品图,或者一张带牛皮癣的不适图,或者是一张过于性感暴露的美女图。当然也有很多人喜欢看美女图,所以可能会面临标准界定的问题:有人觉得OK的图片在某些媒体就有投诉风险。如何去解决分级的问题?

一方面,为不同的广告位提供不同的配置,通过Score得分阈值来提供给业务方进行控制。

另一方面,针对比如涉黄涉恐不同的模型,我们是统一为一个大模型进行训练,通过这种方法来提升整体的识别能力。

对于不适图,由于其标准定义不够清晰、内容变化、差异较大等问题,是很难通过一个有效的数据进行标注的,为此我们建立了一套基于相似度检索的不适图识别算法。首先通过图片的embedding来提取特征,通过特征加入特征索引库,以相似度召回的方式来召回与特征相似的一些图片。我们认为如果相似,它是不适图的概率就会比较大。基于这种方法,可以对不适图库进行定期更新和调整,可以有效解决线上case快速响应的问题。

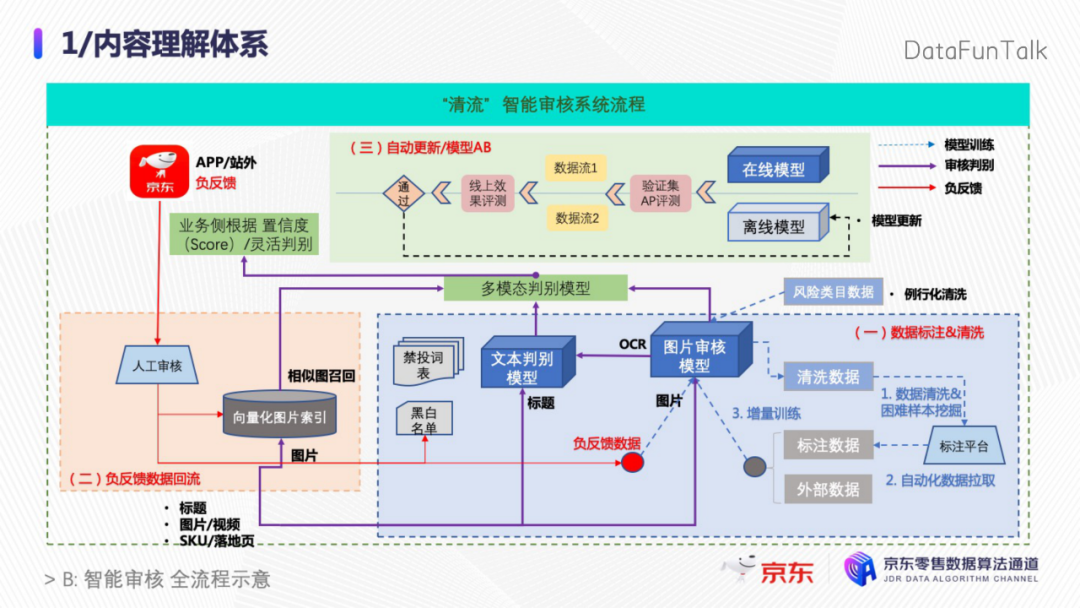

为了应对整个京东广告体系下的素材准入和审核问题,我们构建了一套清流的智能审核系统。如上流程图,整个系统分为三个部分。

第一部分是建立数据标注和清洗的规则,然后借助数据清洗和困难样本挖掘,结合自动化的数据拉取,可以为标注平台提供充足的标准数据。

第二部分是针对APP的负反馈建立了数据回流机制,通过建立向量图片库,借助人工审核的基础提供给训练模型更具有时效性的训练数据,同时结合文本分类、图片的审核模型,形成一个多模态的判别模型,可以大大提升模型的整体准确度。

第三是通过自动更新和模型的ABtest来保证线上模型在实际业务中的识别效果。目前我们审核系统已经对亿级的广告商品进行审核,可以覆盖标题、图片、视频以及落地页等,已经成为智能创意里面不可或缺的一个关键部分。

4. 质量/美学评价

接下来是内容理解体系的第三部分,美学和质量评价体系的建立。在素材准入的基础上,如何筛选出更优质的素材,产出更优质的创意,这就是评价体系要解决的问题。评价体系的建立并不像人的直观判别这么简单,首先是数据标注问题,每个人衡量美丑的标准是不一样的。其次需要有效地解决各个维度之间的对齐和配比问题,针对这个问题,我们的方案是建立一个模型化端到端的解决方案,这样做的优势有两个:

- 第一是可以让模型去学习各个维度之间的权重和耦合关系;

- 第二是可以发掘除了现有维度之外的特征,还可以结合我们的希望让模型学到一些额外特征,比如点击率的影响等。

以上就是我们内容理解体系要解决的问题。

03 智能内容生成

1. 智能创作背景

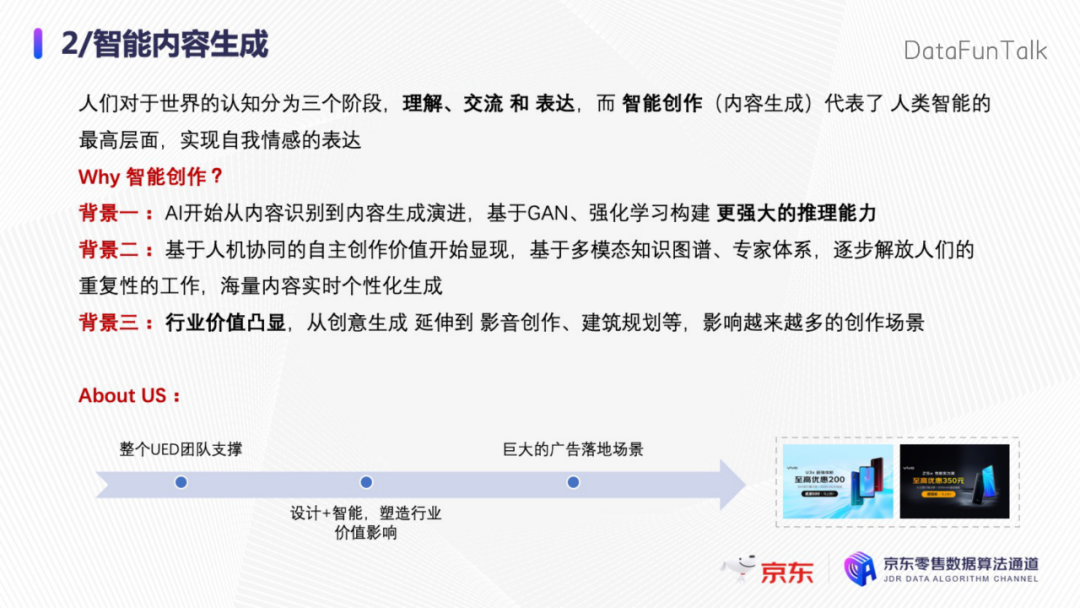

人们对于世界的认知可以分为三个阶段:对这个世界进行理解,然后在理解的基础上,可以进行交流,最后在理解和交流的能力建立以后,会通过智能创作来进行自我情感的表达。

- 第一个阶段:AI已经开始从内容识别到内容生成的演进,可以基于GAN和强化学习来构建更强大的推理能力。

- 第二个阶段:基于人机协同的自主创作价值开始显现,基于多模态的知识图谱、专家体系可以逐步解放人们的重复性工作,来实现海量内容的实时个性化生成。

- 第三个阶段:行业价值开始凸显,从创业生成衍生到影音创作、建筑规划等,会影响越来越多的创作场景。

在智能创作上,我们会有整个UED团队作为支撑,然后通过设计+智能来塑造行业的价值影响,同时基于巨大的广告落地场景,致力于AI创作的不断迭代和实践。下面我分几个具体的任务场景来简单介绍。

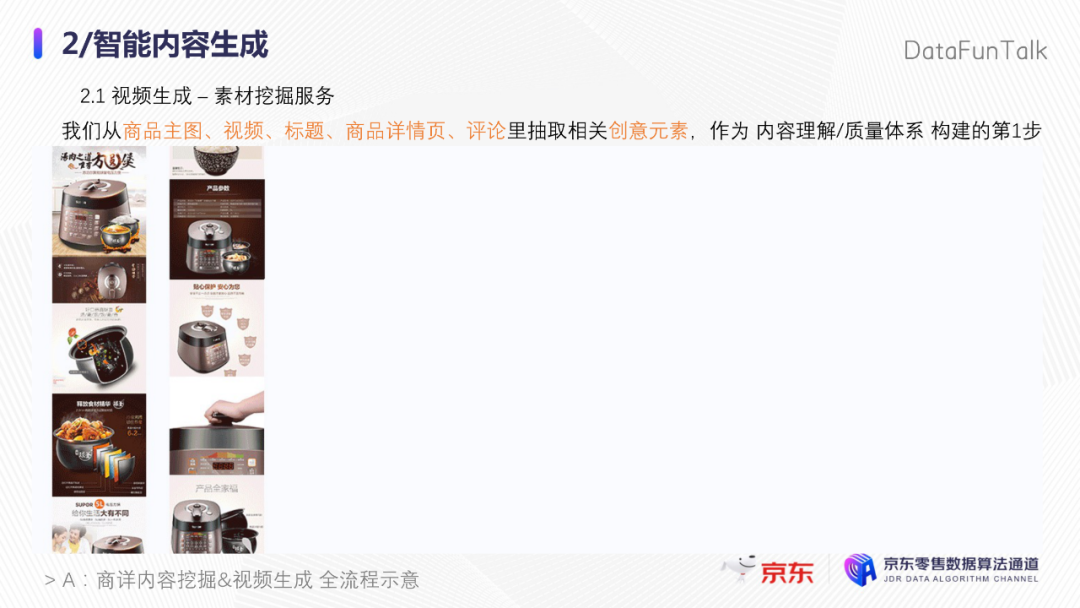

上图呈现的从商详内容挖掘到视频生成的整个过程。其中用到的算法比较多,比如文字识别、智能裁剪、显著性判断、语音等。商详页作为一个典型的场景,包含了大量有价值的商品图片,首先基于布局分析来对图片里的有效内容进行裁剪,然后在这个基础上通过商品识别来提取有价值的商品图,并通过相似度的匹配来进行图片过滤,这样可以兼顾内容的有效性和多样性,同一个商品我们不希望同样的图出现多次。然后基于文字识别和NER模型分别提取图片和商品标题里的关键卖点,同时通过TTS的算法将字幕转化成语音。最后结合背景音乐或者特效来生成最终视频,这就是从商详挖掘到视频生成的整个过程。这是我们早期的方案,现在我们更多是从视频的拍摄角度、视频摘要、视频片段之间的组合去做视频生成。

2. 视频摘要生成

第一个任务场景是视频摘要,即基于商家上传的长视频提取精彩片段,通过重新组合来形成情节更加紧凑,卖点更加突出的短视频,因为现在短视频的应用场景非常多。

如何生成视频摘要?

首先是镜头切分,对视频中每一帧的特征进行分析,提取相邻帧之间的特征相似度从而判断视频中每一个镜头的边界,基于传统的算法或深度学习的方式都可以实现。

第二部分是借助前面提到的视频标签化能力,建立商品检测、人脸、人体的检测、文字或者视频质量、动作这些标签,在此基础上建立标签化表示。

第三部分是会引入文本特征,主要包括品牌词、产品词,以及完整的标题等,可以建立文本特征的统一表示。

第四部分是在建立特征表示以后,会去计算特征间的相关性,比如根据商品主图或者文案信息的特征来得到商品特征或文本特征,可以匹配视频中与该特征相关的一些片段,同时可以考虑对视频中其他识别结果的作用,比如突出商品或突出视频的多样性,这都是不同的生成目标,我们可以在不同的目标基础上去调整不同的权重,来生成不同的短视频。

最后是目标镜头的识别,是综合视觉的相关性和文本的相关性来识别视频中的目标镜头,可以采用加权融合,也可以直接让模型按照你的配比去进行学习。

目前摘要算法已经广泛应用于站内外的各个场景,同时也为自动化的生成及其工具化提供了能力。

可以看以上两个算法实例,它们是通过摘要算法对商品的关键片段进行了抽取,对商品的关键细节特征以及图文相结合的内容进行了选取,主要是突出质感、摄像功能等一些卖点,左边是原始视频,右边是摘要生成的视频,更突出商品以及商品的图文相关性。短视频的优势是可以在最短的时间内去吸引用户关注,所以会更多地去突出一些典型的、精彩的点。以上是我们视频摘要算法的过程。

3. 图片创意生成

第二个任务场景是图片的创意生成,图片创意生成是在创意元素基础上进行智能的衍生和加工,再结合组件化、序列化或者模型化的方式来进行生成。

图片生成有四个典型的部分:原生/场景化、分层/组件化、微动效、实时的图片生成引擎。左边的图是原生场景化的生成方案,通过对商品背景进行提取,然后结合GAN进行背景生成,得到和商品背景颜色、调性一致的图片。右边的图是序列化的生成方案,是将创意拆解成背景层、装饰层、商品层、遮罩层,还有文字组件层,并通过智能搭配、智能布局来进行实时的生成。

这里要强调下我们打造的一个基于用户特征的实时优选和生成的引擎,引擎可以实现创意到用户的实时个性化的解决方案。假设每个创意包含十组文案、十个背景和十个装饰层,就可以得到1000种组合关系,实际的情况可能比这个还要多。线上目前采取的是先优选再生成的思路,通过优选模型,先选择好的创意元素,再借助实时生成引擎来进行元素的组合渲染,整个过程可以控制在20毫秒以内,该引擎已经成为我们智能图片生成的核心支撑。

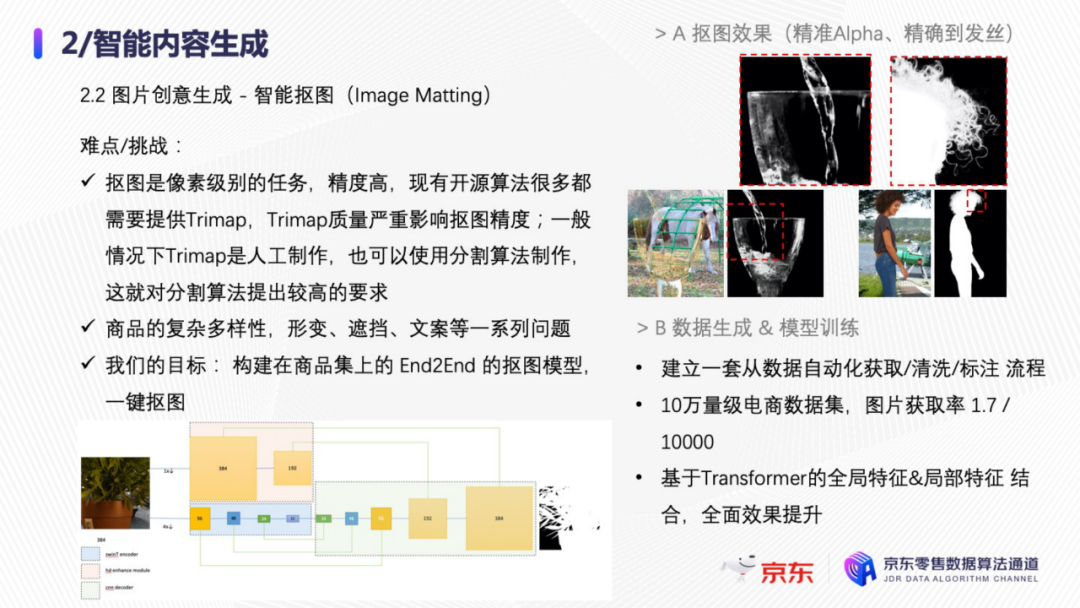

与之对应,介绍智能抠图算法,抠图在业务上已经大量使用了,为内容生成提供了大量的透底图素材,作为后续序列化生成的基础。语义分割或者实例分割算法中,物体的边缘定位或对于边缘像素的分类是一个比较难解决的问题,而抠图算法在这个基础上面临的挑战更大:

- 第一是作为像素级的任务,如何对边缘进行更好的定位,包括边缘像素的Alpha值提取,这是更难的。

- 第二是商品的多样性,京东站内的商品种类上亿,同时还会面临诸如形变、遮挡、或者图上有文字等一系列问题,都会影响识别或者抠图的效果。

针对这些挑战,我们的目标是构建一个基于商品集的端到端的抠图模型,通过这种方式实现一键抠图。右上方是我们的扣图效果,目前看还是不错的。

针对训练数据生成和模型训练,我们做了一些优化:

在数据上,建立一套从数据获取到清洗、标注、训练的自动化流程。其中用到了很多辅助算法,包括相似度识别、图像校正、质量清晰的判别过滤等。在此基础上,构建了一个十万量级的电商数据集,目前数据获取率只有1.7/10000。

在算法上,我们采用了Transformer来对商品和背景的特征进行提取。这种方法可以对全局特征和局部特征进行比较好的结合,既能保证全局语义的完整性,又保留了待抠图商品部分的边缘细节,同时加入了Attention的方式,可以对商品的边缘和背景之间的联通区域做有效的判别和分类,以此更好地区分背景,整体上我们的控制效果已经达到了业界领先的水平。技术成果正在进行论文撰写,数据集也希望后续可以开源。

4. 文案创意生成

第三个任务场景是文案生成,文案的种类有很多,比如智能标题、短文案、卖点文案、走心文案等,包括使用标题压缩进行标记生成,也包括基于主图或商详进行卖点文案的识别和挖掘后基于图文结合多模态的方式来进行生成。

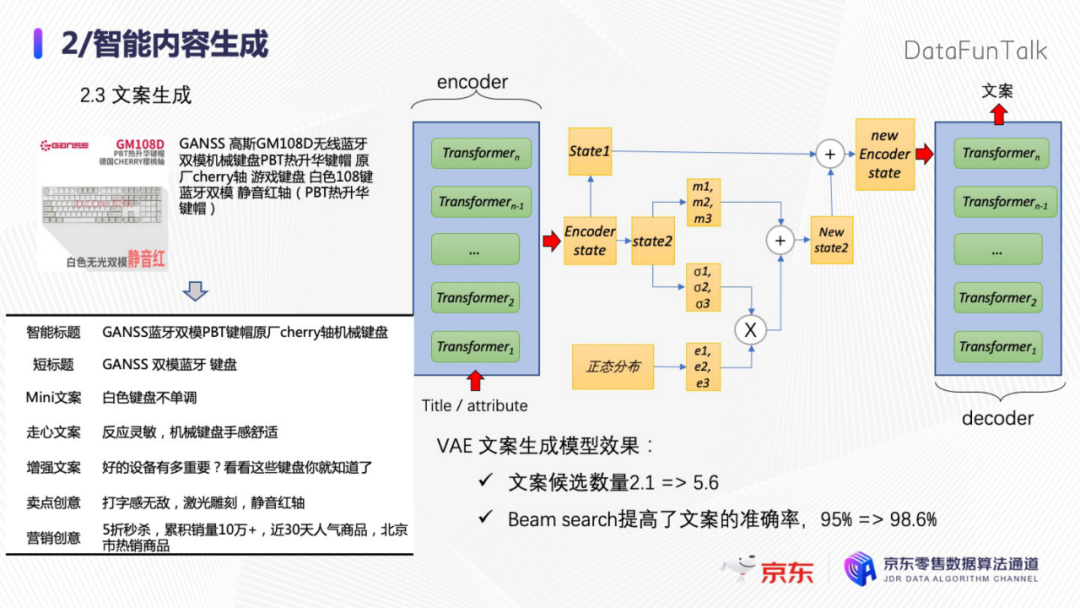

主要介绍基于VAE的生成方案,是通过学习达人撰写的优质文案来对不同的SKU生成个性化的文案信息。在传统Sequence to sequence模型的架构下,为了获取更强的特征提取能力,将编码和解码的LSTM和Attention转化为了Transformer,也借鉴了VAE的方案,在encoder上加入了VAE能力,可以增加文案的多样性。同时在decoder端,我们是由之前的核采样转化成了Beam search,在多样性上有一些提升。业务应用例如生成的Mini文案,在推荐位上也取得了显著的效果提升。

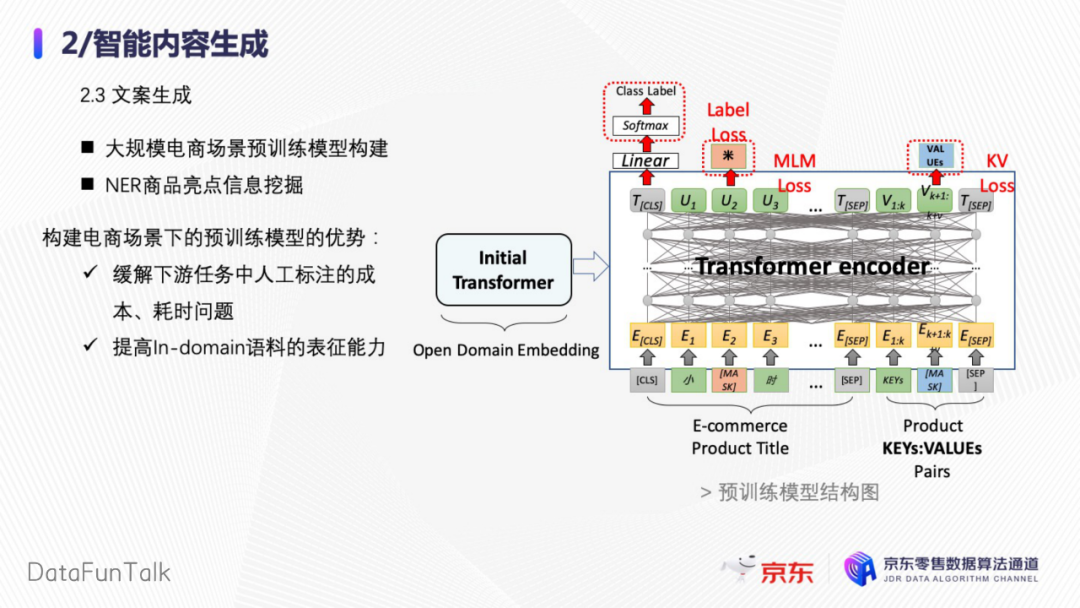

为了支持文案生成能力,我们做了大量的底层工作,包括大规模电商场景下的预训练模型构建,以及基于NER的商品亮点信息挖掘等。重点介绍预训练模型,基于两亿规模的数据进行了预训练,可以更好地对商品进行表示,用于支持模型优选和各类下游任务。其中改进点有几个:

- 第一,在Bert原本的预训练任务中去除了效果不太好的NSP的任务;

- 第二,加入了商品自带的类目信息;

- 第三,加入了一些Weak Label,就是一些结构化的信息作为loss判别。

效果是在下游的NER任务中,以原始的Bert作为baseline,准确度提高了1.5%,达到同样的一个效果每个类目需要的标注数据量也由原来的10000降低到了6000。

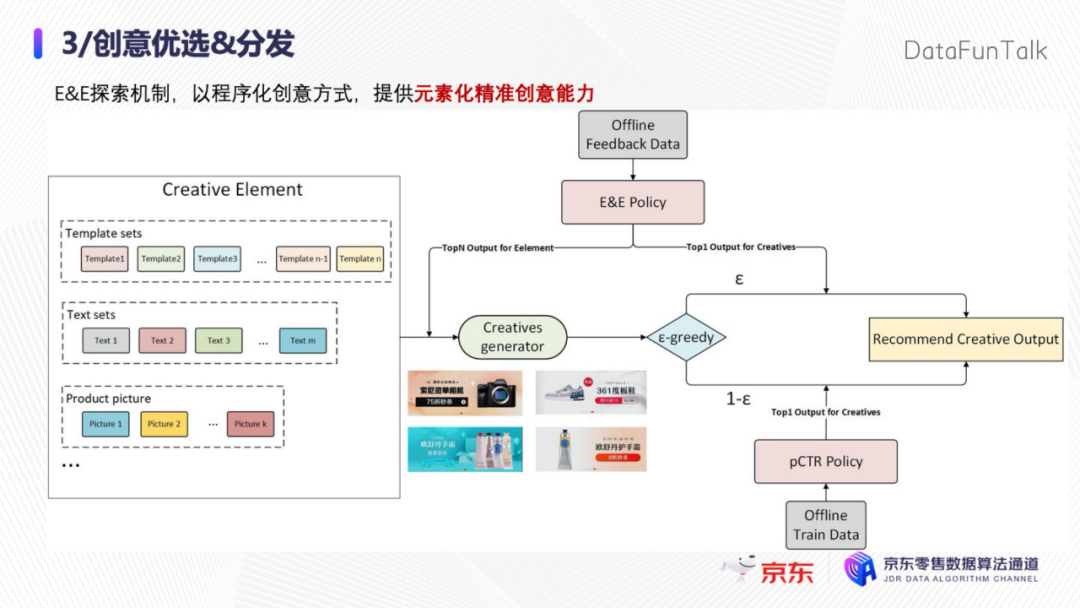

04 创意优选&分发

前面简单提到了优选模型,优选模型要解决什么问题?

- 第一是精准匹配的问题

- 第二是解决长尾和多样性

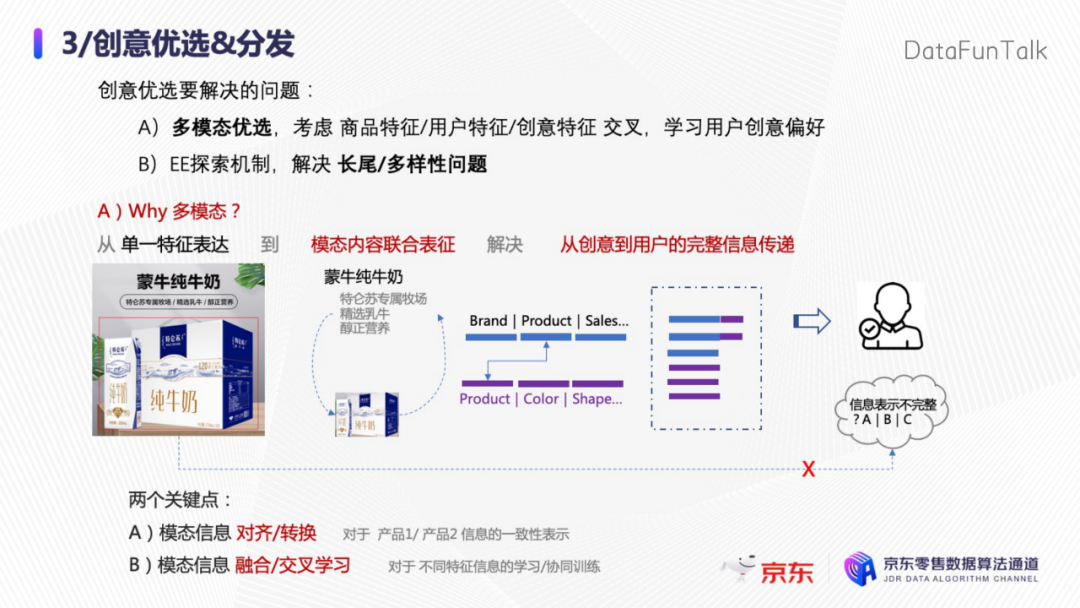

如何解决个性化匹配的问题,我们用到的是多模态的优选,因为优选模型可以充分学习商品特征、用户特征和创意特征之间的交叉,从而学习到用户对于创意的偏好,解决多样性,我们采用了一个EE的探索机制的方案。

1. 多模态优选模型

为什么要在电商场景下去做多模态?如上图,智能创意本身是一个多模态的场景,基于单一的图片表示很难对用户形成完整的信息传递,也就是说模型对于创意信息的理解是不完整的,比如只看文案,就无法get到商品的外观信息,只看图片也很难get到它的具体卖点。通过两个模态间的对齐和校准,可以形成模态内容的联合表示,可以有效实现从创意到用户完整的信息传递路径。有两个关键点:

- 第一是对于模态的对齐和转换;

- 第二是如何对模态信息进行融合和交叉学习,将不同模态的特征做交叉组合来统一,便于进行后续的训练。

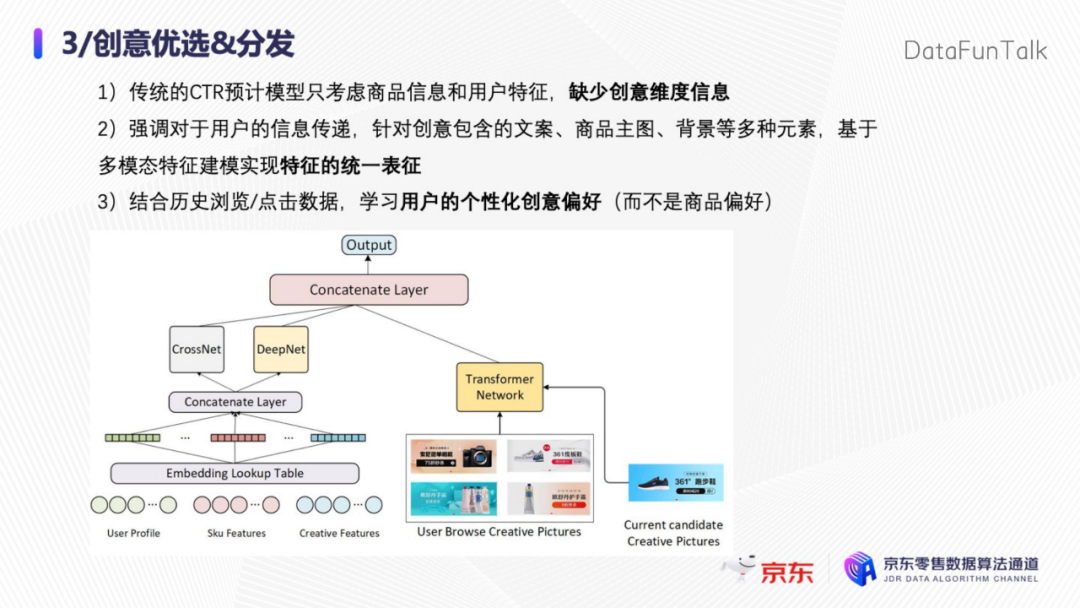

上图是我们构建的优选模型,在建模的时候,首先考虑的是如何基于用户的历史行为建立用户对于创意的偏好,体现为以下几点:

- 第一是传统的CTR预估模型,只考虑了商品和用户的特征,并没有考虑创意维度的信息;

- 第二是要强调对于用户的信息传递,针对创意包含文案、图片、背景等多种元素的情况,可以基于多模态特征建模来实现特征的统一;

- 第三是结合历史的浏览和点击数据,去学习用户个性化的创意偏好,而不是仅仅学习用户对于商品的偏好。

结构图左边是一个简单的DCN模型,是大家熟悉的Widedeep表示,右边是加入了Transformer的网络来对于创意特征进行表征,然后在此基础上和原来的信息做Content。

2. 模型的EE能力

优选模型的第二部分体现的是EE能力,EE是指探索(explore)和利用(exploit)。针对创意元素的组合EE模型分为两部分,第一部分是按照ξ做按比例的探索,被称为探索流量,探索流量保证了创意元素集的充分曝光。下面1-ξ这部分是按照pCTR预估的方式进行优选,在前面元素充分曝光的基础上,可以得到更置信的元素的CTR预估,在这个基础上可以将创意特征加入优选模型来实现模型到用户的个性化匹配能力。所以说上面主要是探索的部分,下面主要是效果呈现的部分。

05 业务落地

最后是业务落地的情况,目前创意内容生成及优选已经在线上进行了长期运行。

第一,我们现在的内容生成和分发已经全面覆盖了像首焦、搜推、站外等核心广告位,每天智能生成的视频、图片、文案创意已经超过了数亿条,可以触达千万级的用户,并且我们获得了京东技术金项奖-技术创新奖。

第二,构建了视频标签化为基础的视频广告生态,智能创意在视频上也影响了大量广告收入,包含了站内的搜索、推荐,站外的抖音、快手等,在站外也有大量的广告投放。

第三,关于效果,以站内的首焦业务为例,我们建立的创意内容和优选体系近一年点击率提升已经超过了30%。

最后是智能创意的产品化、工具化和平台化建设,已经全面融入了京东广告的生态,持续赋能电商业务。

06 精彩问答

Q:美学评估具体是怎么实现的?

A:传统意义上,大家理解图片的美丑是通过比较主观的判别去给一个label标注的。比如一张图片,A打到八分,B能打到十分,基于多人的打分归集到一块,在这个基础上通过标注数据做分布的预估来判断标注的置信度,比如80%的人都认为图片的美学在五到六分之间,这个数据其实就是我们用于后续训练的一个数据集。这是关于数据建立的过程,评价体系分为多个方面,一个是Hamony值评估颜色的和谐度,看几个颜色放在一起是不是协调,得到一个和谐分。其次是基于规则的布局合理性得分,最后有线上特征feature的加入,例如可以把CTR的数据引入进来,加入到整体的质量判别中。

Q:文案生成是直接用于投放吗?如何保证不会出现生成的文案卖点与商品不一致?

A:我们整个内容生成都是直接用于投放的。不管是文案生成或是图片、视频生成,可能都会面临你说的问题,也就是badcase,同时还有商家自己上传图片或者填文件出错的情况,所以准确率本身是很难去避免的。我们在生成文案时的准确率能达到98%甚至99%,它本身的badcase率很小;其次在这个解决方案,我们会通过线上实时反馈等方式,实现实时的禁播,把这个部分的文案卡掉。

Q:组件化的图片生成是完全靠UED提供组合规则吗?

A:组件化的方式生成,我们肯定会把UED同学给引入进来。为什么要做文字组件这个事情?一是方便我们把图片序列化分成N个部分,文字组件可以通过智能布局的调整,智能颜色搭配去适应不同的场景。但不是针对每一类创意,都需要UED同学去生成一套模板,这样效率是非常难以保证的。我们加入智能搭配,智能布局,或者智能文案形式的调整后,UED只需给到我们一个最简单的小组件,我们可以把它扩展成更多的组件,可以适应更多的文案形式,可以更多在元素之间做布局,整体上是为了提升方案的多样性。

Q:对于类似场景分类这样的应用,标签体系是业务同学直接提供的,还是由算法使用了什么方法来进行归纳总结的?如果是后者,那么如何权衡使用什么样的标签体系?

A:标签体系特别复杂,标签体系cover的角度会比较多,比如说图片里,要去判断图片的场景,比如说它是在街上还是家里。这个场景的定义是我们算法自己去定义的,因为电商场景下有大量的视频和图片,我们会在收集这些视频和图片内容后,通过标注同学去做场景的标注,然后标注的内容,我们会和相关同学做by case的前期的一些沟通来建立,所以这个过程的前期有非常庞大和繁琐的工作。

Q:可以详细介绍一下多模态在精排模型中的应用细节吗?

A:我们现在做的多模态部分主要是在优选过程中使用,现在还没有在精排模型中去做。具体原因,对于我们来讲,优选模型是对每一个商品,它会选择一个对于当前用户最好的创意或者最好的内容。精排模型,它要解决的是怎么样去选择用户最感兴趣的一个SKU,现在我们的思路是这两个过程并行,就是优选创意内容和优选商品其实是独立的。我们的实时生成、优选引擎,过程可以控制在20毫秒以内,精排模型本身对耗时的要求也比较高,比如你再增加20毫秒,这会有很大的挑战,所以这个过程我们更倾向于通过并行的方式去做。

Q:创意优选的离线评估指标是什么?

A:和精排模型的评估指标一致,我们用AUC去评估它的效果增益,比如加入创意内容的一个特征后,或者加入文案、图片的一个embedding信息后,评估AUC能得到多大的增益。然后在这个基础上,评估对生意提升超过5‰或者多少,然后我们就会放到线上去做实际的线上ABtest。

Q:请问在商户选择上是白盒还是黑盒,能否规模化使用?

A:现在做的是自动化的智能创意投放场景,对于商家来讲其实是无感知的,他们能感知到的就是效果变好了,不知道他选择了智能创意。但是后面我们会有一个产品化的思考,就是让商家去选择我们的智能创意,在选择使用后看到效果变好。目前对于大多数的商家来讲,它是无感知的,是在纯智能投放的一个场景下,自动选择商品,自动选择用户进行匹配的全智能的pipeline。但是该能力主要覆盖的是中小商家,对于头部KA商家,他们有足够的素材制作能力,所以对于他们主要使用的是其中创意分发的能力。

Q:创意优选和分发做到创意维度,这么大量的创意如何有足够的流量意义?用了EE的方法,那么ξ是如何选取的?如果意义流量足够了,是否能把ξ设置为零?

A:创意的特征和商品的特征其实有很大差异。创意特征,比如一个商品里面有特别多的卖点,它有特别多的图片,比如一个相机,它的正面或者背面,要展现的内容包含它的摄像效果、颜值等等,针对这些信息,怎么保证每一个效果的充分展现和置信度?我们要按照ξ去进行展示,但这个展示保留了比如说10%或者20%,是为了保证有效展现,但是我们即使在这个模型预估完成以后,也不会把ξ系统调整为零,因为创意优选的过程中,创意和商品的信息会变化,这是从商品层面去看,它会有更新,然后从用户层面看,其实也会有创意衰减的问题,比如每个人都有不同的喜好,而且比如我今天喜欢看绿色的创意,明天也会审美疲劳。所以探索就是要匹配用户的兴趣度变化,去不断迭代探索。所以EE探索是一个长期的过程,它是和CTR预估分支一起发生作用的。

Q:做创意优选的目的是什么,实际的线上效果如何?

A:做优选的核心目的肯定是提升创意的效果,通过和用户喜好的匹配来实现这种个性化也就是千人千面的对比映射,最终能够体现给商家看到的就是点击率,或者转化效果的提升。对于用户则是看到的他比较喜欢的创意展现,提升他对于这个平台的喜好,他觉得推给他的很好,他会在这个平台上花更多时间去看去逛,这会提升平台整体的用户活跃度,或者是用户停留时长。所以我们通过创意生态要构建这两方面的目的,一个是对于商家的,一个是对于用户的。

今天的分享就到这里,谢谢大家。

分享嘉宾:

本文首发于微信公众号“DataFunTalk”。

Recommend

About Joyk

Aggregate valuable and interesting links.

Joyk means Joy of geeK