论文解读(ARVGA)《Learning Graph Embedding with Adversarial Training Methods》...

source link: https://www.cnblogs.com/BlairGrowing/p/16348958.html

Go to the source link to view the article. You can view the picture content, updated content and better typesetting reading experience. If the link is broken, please click the button below to view the snapshot at that time.

论文标题:Learning Graph Embedding with Adversarial Training Methods

论文作者:Shirui Pan, Ruiqi Hu, Sai-fu Fung, Guodong Long, Jing Jiang, Chengqi Zhang

论文来源:2020, ICLR

论文地址:download

论文代码:download

1 Introduction

众多图嵌入方法关注于保存图结构或最小化重构损失,忽略了隐表示的嵌入分布形式,因此本文提出对抗正则化框架(adversarially regularized framework)。

2 Method

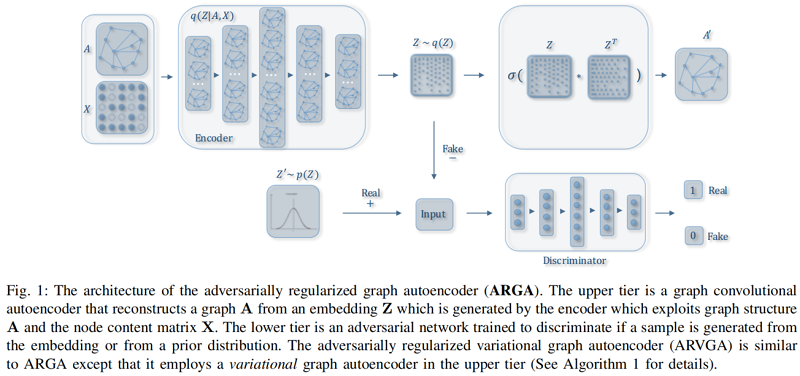

ARGA 框架如下:

组成部分:

-

- Graph convolutional autoencoder

- Adversarial regularization

2.1 Graph Convolutional Autoencoder

一个频谱卷积函数 f(Z(l),A∣W(l))f(Z(l),A∣W(l)) :

Z(l+1)=f(Z(l),A∣W(l))(1)Z(l+1)=f(Z(l),A∣W(l))(1)

采用GCN :

f(Z(l),A∣W(l))=ϕ(D˜−12A˜D˜−12Z(l)W(l))(2)f(Z(l),A∣W(l))=ϕ(D~−12A~D~−12Z(l)W(l))(2)

Z(1)=fRelu (X,A∣W(0))(3)Z(1)=fRelu (X,A∣W(0))(3)

Z(2)=flinear (Z(1),A∣W(1))(4)Z(2)=flinear (Z(1),A∣W(1))(4)

我们的图卷积编码器 G(Z,A)=q(Z∣X,A)G(Z,A)=q(Z∣X,A) 将图结构和节点内容编码为一个表示的 Z=q(Z∣X,A)=Z(2)Z=q(Z∣X,A)=Z(2)。

q(zi∣X,A)=N(zi∣μi,diag(σ2))(6)q(zi∣X,A)=N(zi∣μi,diag(σ2))(6)

这里,μ=Z(2)μ=Z(2) 是均值向量 zizi 的矩阵;同样,logσ=flinear (Z(1),A∣W′(1))logσ=flinear (Z(1),A∣W′(1)) 在 Eq.3Eq.3 的第一层与 μμ 共享权值 W(0)W(0)。

Decoder model

我们的解码器模型用于重建图形数据。我们可以重建图结构 AA,内容信息 XX,或者两者都可以重建,本文注重重建图结构 AA。

Decoder 是 p(A^∣Z)p(A^∣Z)。

我们训练了一个基于图嵌入的链接预测层:

p(A^∣Z)=∏ni=1∏nj=1p(A^ij∣zi,zj)(7)p(A^∣Z)=∏i=1n∏j=1np(A^ij∣zi,zj)(7)

p(A^ij=1∣zi,zj)=sigmoid(z⊤i,zj)(8)p(A^ij=1∣zi,zj)=sigmoid(zi⊤,zj)(8)

这里的预测 A^A^ 应该接近于地面真相 AA。

嵌入 ZZ 和重构图 A^A^ 可以表示如下:

A^=sigmoid(ZZ⊤), here Z=q(Z∣X,A)(9)A^=sigmoid(ZZ⊤), here Z=q(Z∣X,A)(9)

Optimization

对于图编码器,我们通过以下方法来最小化图数据的重构误差:

L0=Eq(Z∣(X,A))[logp(A∣Z)](10)L0=Eq(Z∣(X,A))[logp(A∣Z)](10)

对于变分图编码器,我们对变分下界进行了优化如下:

L1=Eq(Z∣(X,A))[logp(A∣Z)]−KL[q(Z∣X,A)∥p(Z)](11)L1=Eq(Z∣(X,A))[logp(A∣Z)]−KL[q(Z∣X,A)‖p(Z)](11)

其中,KL[q(∙)∥p(∙)]KL[q(∙)‖p(∙)] 是 q(∙)q(∙) 和 p(∙)p(∙) 之间的 KL 散度。p(∙)p(∙) 是一个先验分布,它在实践中可以是一个均匀分布,也可以是一个高斯分布 :p(Z)=∏ip(zi)=∏iN(zi∣0,I)p(Z)=∏ip(zi)=∏iN(zi∣0,I)。

2.2 Adversarial Model D(Z)D(Z)

我们的模型的基本思想是强制潜在表示 ZZ 来匹配一个先验分布,这是通过一个对抗性的训练模型来实现的。对抗性模型是建立在一个标准的多层感知器(MLP)上,其中输出层只有一维的 sigmoidsigmoid 函数。对抗模型作为一个鉴别器来区分潜在代码是来自先前的 pzpz(positive)还是图编码器 G(X,A)G(X,A)(negative)。通过最小化训练二值分类器的交叉熵代价,最终在训练过程中对嵌入方法进行正则化和改进。该成本的计算方法如下:

−12Ez∼pzlogD(Z)−12EXlog(1−D(G(X,A)))(12)−12Ez∼pzlogD(Z)−12EXlog(1−D(G(X,A)))(12)

在我们的论文中,我们检查了对所有模型和任务,设置 pzpz 为高斯分布和均匀分布。

Adversarial Graph Autoencoder Model

用鉴别器 D(Z)D(Z) 训练编码器模型的方程可以写如下:

min Gmax DEz∼pz[logD(Z)]+Ex∼p(x)[log(1−D(G(X,A)))](13)min Gmax DEz∼pz[logD(Z)]+Ex∼p(x)[log(1−D(G(X,A)))](13)

其中 G(X,A)G(X,A) 和 D(Z)D(Z) 表示上述说明的发生器和鉴别器。

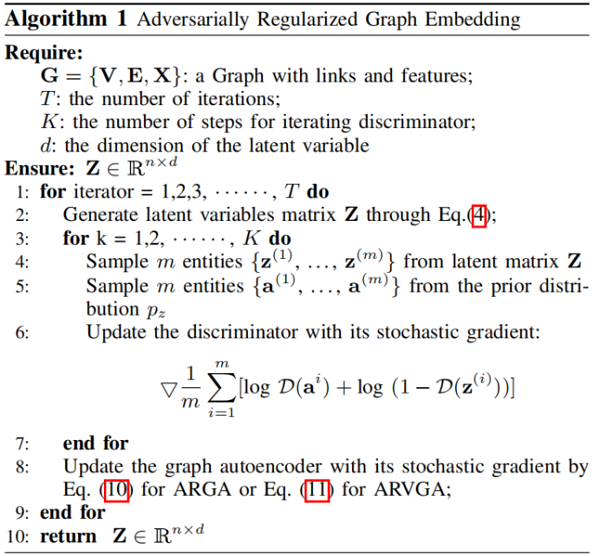

2.3 Algorithm Explanation

算法如下:

2.4 Decoder Variations

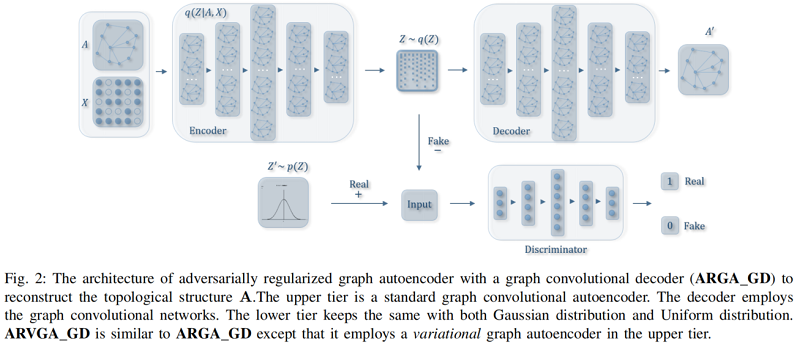

GCN Decoder for Graph Structure Reconstruction (ARGA GD)

这种方法的变体被命名为 ARGAGD。Fig 2 展示了 ARGAGD 的体系结构。

在这种方法中,解码器的输入将从编码器中嵌入,并且图卷积解码器构造如下:

ZD=flinear (Z,A∣W(1)D)(14)ZD=flinear (Z,A∣WD(1))(14)

O=flinear (ZD,A∣W(2)D)(15)O=flinear (ZD,A∣WD(2))(15)

其中,ZZ 是从图编码器学习到的嵌入,而 ZDZD 和 OO 是从图解码器的第一层和第二层的输出。OO 的水平维数等于节点数。然后,我们计算出重建误差如下:

LARGA−GD=Eq(O∣(X,A))[logp(A∣O)](16)LARGA−GD=Eq(O∣(X,A))[logp(A∣O)](16)

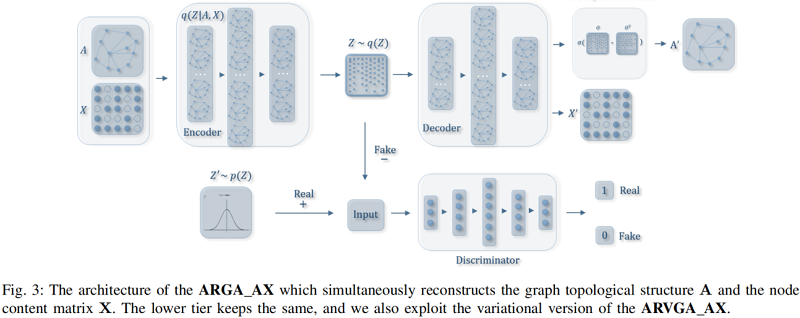

GCN Decoder for both Graph Structure and Content Information Reconstruction (ARGA AX)

我们进一步修改了我们的图的卷积解码器,以重建图的结构 AA 和内容信息 XX。该体系结构如 Fig.3 所示。

我们用与每个节点相关的特征数固定第二图卷积层的维数,因此第二层的输出 O∈Rn×f∋XO∈Rn×f∋X。在这种情况下,重构损失由两个误差组成。首先,图结构的重构误差可以最小化如下:

LA=Eq(O∣(X,A))[logp(A∣O)](17)LA=Eq(O∣(X,A))[logp(A∣O)](17)

然后用类似的公式可以最小化节点内容的重构误差:

LX=Eq(O∣(X,A))[logp(X∣O)](18)LX=Eq(O∣(X,A))[logp(X∣O)](18)

最终的重构误差是图的结构和节点内容的重构误差之和:

L0=LA+LX(19)L0=LA+LX(19)

3 Experiments

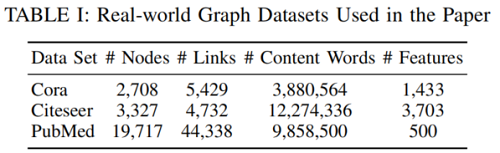

数据集

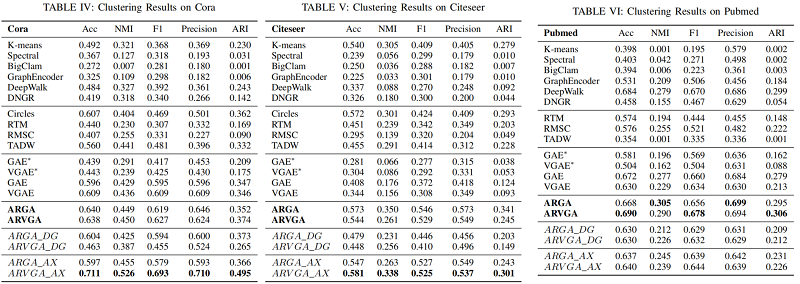

节点聚类

4 Conclusion

本文提出了一种新的对抗性图嵌入框架。我们认为现有的图嵌入算法都是非正则化方法,忽略了潜在表示的数据分布,在真实图数据中嵌入不足。我们提出了一种对抗性训练方案来正则化潜在码,并强制使潜在码匹配先验分布。对抗性模块与一个图卷积自动编码器共同学习,以产生一个鲁棒表示。我们还利用了ARGA的一些有趣的变化,如ARGADG和ARGAAX,来讨论图卷积解码器对重构图结构和节点内容的影响。实验结果表明,我们的算法ARGA和ARVGA在链路预测和节点聚类任务中优于基线算法。

反向正则化图自动编码器(ARGA)有几个方向。我们将研究如何使用ARGA模型生成一些真实的图[64],这可能有助于发现生物领域的新药。我们还将研究如何将标签信息合并到ARGA中来学习鲁棒图嵌入。

__EOF__

Recommend

About Joyk

Aggregate valuable and interesting links.

Joyk means Joy of geeK