苹果阻击儿童色情 宣布三项新技术增加相关保护功能

source link: https://finance.sina.com.cn/tech/2021-08-06/doc-ikqcfncc1218731.shtml

Go to the source link to view the article. You can view the picture content, updated content and better typesetting reading experience. If the link is broken, please click the button below to view the snapshot at that time.

苹果阻击儿童色情 宣布三项新技术增加相关保护功能

新浪数码讯 8月6日上午消息,苹果公司宣布了三项新举措,旨在通过自己技术和产品功能,提供儿童保护。包括Messages信息应用中敏感图像筛查、iCloud中儿童性虐待内容的检测,以及Siri和搜索功能的相关内容的支持。

苹果公司强调“保护儿童是一项重要责任”。考虑到这一点,苹果表示,他们将努力将此类功能不断更新。

机器筛查Messages信息

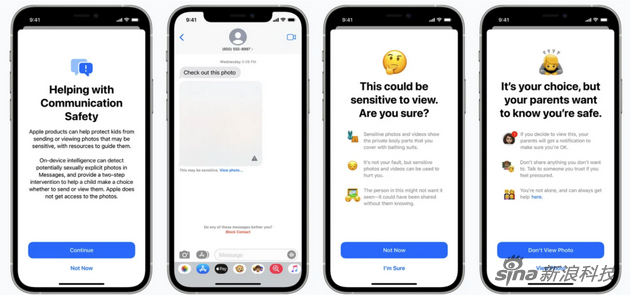

苹果公司在其Messages信息应用中更新了一项通信安全功能。 他们提到,如果组成iCloud的家庭中,孩子那边收到或尝试发送色情照片时,孩子会看到一条警告消息。

当孩子收到色情图片时,图片会变得模糊,并且Messages应用程序会显示一条警告,称该图片“可能很敏感”。如果孩子点击“查看照片”,他们会看到一条弹出消息,告知他们为什么该图像被判定是敏感的。

敏感图像将是模糊的,并且家庭组中父母的产品上会有通知

敏感图像将是模糊的,并且家庭组中父母的产品上会有通知如果孩子决定查看图像,他们设备关联的家庭中。父母那端将收到通知。弹出窗口还将包含一个含有帮助信息的链接。

此外,如果孩子试图发送色情图片,他们会看到类似的警告。苹果公司表示,在发送照片之前,孩子会收到警告,如果孩子选择发送照片,父母可以收到一条消息,此功能适用于13岁以下的孩子。

苹果公司解释说,该功能是可选的。Messages使用设备上的机器学习功能来分析图像附件,并判定照片是否具有色情内容。 同时,因为iMessage信息是端到端加密,苹果公司自己也无法看到任何消息。

此功能将首先美国推出,今年晚些时候在iCloud中为家庭帐开放,并在iOS 15、iPadOS 15和macOS Monterey的更新中推出。

儿童性虐待内容检测

苹果公司宣布采取新措施来打击儿童性虐待内容 (CSAM) 的传播,这类内容主要是指涉及儿童的色情活动的内容。

该功能将允许苹果公司检测存储在iCloud云端照片中的这类图像。然后,苹果公司可以向国家失踪和受虐儿童中心报告实例,该中心会与执法部门密切合作。

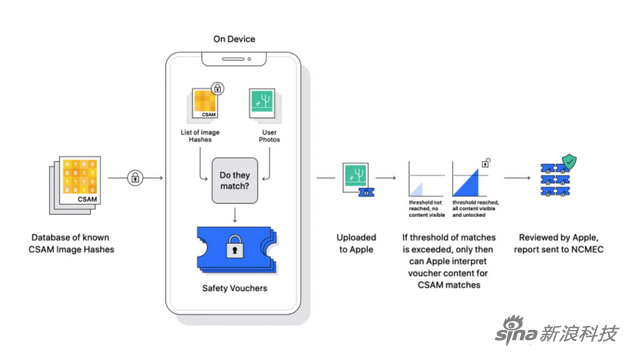

苹果分析图片的技术原理

苹果分析图片的技术原理苹果公司强调其检测儿童性虐待内容的方法在设计之初就考虑了隐私。简单来说,苹果公司是在分析图像是否与国家失踪和受虐儿童中心提供的已知CSAM图像数据库匹配。他们将国家失踪和受虐儿童中心的数据库转换为一组不可读的哈希函数(将一段较长的数据映射为较短的数据),之后进行对比。

一旦匹配程度达到某个阈值,苹果公司将手动审查确认匹配,然后禁用用户的帐户,并向国家失踪和受虐儿童中心发送报告。

阈值技术很重要,因为它意味着帐户不会被错误标记。人工审核还增加了另一个确认步骤,以防止错误,用户将能够提出上诉以恢复其帐户。

苹果说系统每年的错误率不到1万亿分之一。

苹果公司只分析存储在iCloud照片中的图片。本地存储的图像不参与此过程。苹果表示,设备上的系统更重要且更能保护隐私,因为它只报告拥有儿童性虐待内容的用户,而不是在云端不断扫描每个人的照片。

Siri和搜索功能改进

最后,苹果公司正在对Siri和搜索功能进行升级。他们说:苹果还通过提供额外资源来帮助儿童和父母保持网上安全,如果在不安全时候可通过Siri和搜索获得帮助指导。例如,询问Siri如何报告儿童性虐待内容或剥削童工,这些功能将告诉用户在哪可以汇报给有关部门。

SIri增加类似“我该怎么办”功能

SIri增加类似“我该怎么办”功能Siri和搜索功能更新也将于今年晚些时候在iOS 15、iPadOS 15、watchOS 8和macOS Monterey的更新中推出。

专注苹果新闻报道,每日推送最新苹果资讯。扫描下方二维码关注苹果汇官方微信(或微信中搜:appleinc2012)。

Recommend

About Joyk

Aggregate valuable and interesting links.

Joyk means Joy of geeK