向绿色迈进 “液冷”正成城市数据中心刚需

source link: https://tech.gmw.cn/2021-07/29/content_35037272.htm

Go to the source link to view the article. You can view the picture content, updated content and better typesetting reading experience. If the link is broken, please click the button below to view the snapshot at that time.

向绿色迈进 “液冷”正成城市数据中心刚需

光明网讯 伴随新规定出台,新能耗大户“数据中心”正迎来一场技术变革。7月27日,北京市发展和改革委员会官网发布《关于印发进一步加强数据中心项目节能审查若干规定的通知》(以下简称《通知》)。

《通知》显示,为加强北京市内数据中心项目节能审查,即日起北京市内新建、扩建数据中心若PUE(评价源效率指标,理想值为1)值超1.4,将被征收差别电价电费。

对此,行业人士表示该规定意味扩建、新建不达标数据中心,每年将付出数千万、乃至上亿元额外电费。这将促使更多大型、超大型数据中心向气候凉爽或有可再生资源的中西地区转移,而特大城市内数据中心则将采用液冷技术。

PUE超标将多缴亿元电费

根据通知,北京市将进一步加强市范围内数据中心项目的节能审查,对于PUE>1.4且<=1.8的项目(单位电耗超过限额标准一倍以内),执行的电价加价标准为每度电加价0.2元;对于PUE>1.8的项目(单位电耗超过限额标准一倍以上),每度电加价0.5元。

此外北京市内扩建数据中心,年能源消费量小于 1 万吨标准煤(1万吨标准煤约等于3000万度电)的项目 PUE 值不应高于 1.3;年能源消费量大于等于 1 万吨标准煤且小于 2 万吨标准煤的项目,PUE 值不应高于 1.25;年能源消费量大于等于 2 万吨标准煤且小于 3 万吨标准煤的项目,PUE 值不应高于 1.2;年能源消费量大于等于 3 万吨标准煤的项目,PUE 值不应高于 1.15。

对此,曙光数创副总经理姚勇表示,以新建3000个标准机柜,单机柜平均功耗为18kW的中型数据中心为例。按北京市新规,其PUE值若超过1.4小于1.8,其一年预计将支付差别电价电费9460万元,若PUE值超过1.8则预计将支付差别电价电费2.36亿元。

“对目前的数据中心运营企业和单位来说,支付这些额外费用是难以承受的。”姚勇介绍,北京、深圳的数据中心规范和标准,对全国城市具有较强的示范作用。此外PUE值要低于1.4,数据中心的传统风冷散热技术模式已难以满足。

PUE新要求,风冷遇“冷”

随着5G、云计算、大数据等新一代信息技术的发展,数据中心作为数字经济发展的重要基础设施,规模增长迅速。但数据中心也是能耗大户,大量数据吞吐和运算使得数据中心面临着前所未有的能耗和散热挑战。如何加快数据中心行业的绿色发展、降低碳排放,成为当下的一个重要课题。

统计显示,2018年全国数据中心总耗电量1500亿千瓦时,占社会总用电量的2%。预计到2025年,这一占比将增加一倍达到4.05%,高能耗的背后是PUE值的居高不下。据报道,截至2019年年底,全国超大型数据中心平均PUE为1.46,大型数据中心平均PUE为1.55。

在此背景下,北京、上海、深圳等城市对新建数据中心节能提出了PUE的硬指标;2019年2月,工信部、国家机关事务管理局、国家能源局出台《关于加强绿色数据中心建设的指导意见》,要求到2022年“数据中心平均能耗基本达到国际先进水平,新建大型、超大型数据中心的PUE达到1.4以下”。

“冷却计算设备耗能一直是导致高PUE的直接原因”,姚勇介绍,传统数据中心风冷模式,导致一半能耗用于冷却计算设备,其PUE值普遍在1.4以上。最为关键的,伴随CPU、GPU等核心计算芯片的功耗升高,风冷模式下单机柜功率密度最高只能到30kW左右。

现实的情况却是,虽然芯片工艺制程不断进步,但服务器端CPU、GPU功率已突破300W、400W大关,目前在运行数据中心不少单机柜功率早已突破30kW,传统的风冷技术亦因此可能遇“冷”。

城市数据中心进入液冷时代

与风冷技术相比,液冷技术的高效制冷效果,将更有益于服务器使用效率和稳定性提升,令数据中心在有限空间内,能够布置尽可能多的服务器,从而提升数据中心运算效率。

2019年12月,曙光将“液冷‘爆发’倒计时钟”的时针拨到11点50分,这距象征液冷在数据中心行业全面爆发的“零时”仅有10分钟。

“液冷爆发”倒计时启动现场

姚勇表示,目前对北京、上海等城市而言伴随严苛PUE值政策出台,其新建、扩建数据中心可以说已进入“液冷”时代。

“液冷技术也有很多种类,冷板液冷、浸没液冷、浸没相变液冷。从降低PUE值上来看浸没相变液冷技术效果最好。在非高密度计算等领域新建、扩建数据中心,冷板式液冷也是很好的选择。”姚勇说。

曙光率先于2015年推出国内首款标准化量产的冷板式液冷服务器,并在当年完成国内首个冷板式液冷服务器大规模应用,2017年交付了国内首套商用全浸没液冷服务器,并在2019年完成国内首个刀片浸没相变液冷服务器的大规模部署。

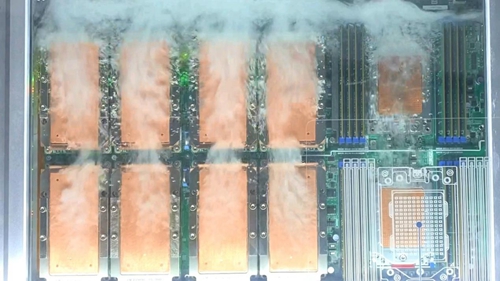

平稳运行中的“刀片式浸没相变液冷”服务器(局部)

以采用刀片式浸没相变液冷技术的曙光绿色数据中心为例,其PUE可降至1.04。相比风冷数据中心能效比提升超30%,CPU等核心芯片部件性能可提升20%,单机柜功率密度达160kW,计算设备可靠性至少提升一个数量级。(宋雅娟)

Recommend

About Joyk

Aggregate valuable and interesting links.

Joyk means Joy of geeK