李宏毅强化学习课程笔记 Sparse Reward

source link: https://xiang578.com/post/reinforce-learnning-basic-sparse-reward.html

Go to the source link to view the article. You can view the picture content, updated content and better typesetting reading experience. If the link is broken, please click the button below to view the snapshot at that time.

李宏毅强化学习课程笔记 Sparse Reward

我的笔记汇总:

Reward Shaping

如果 reward 分布非常稀疏的时候,actor 会很难学习,所以刻意设计 reward 引导模型学习。

Curiosity Intrinsic Curiosity module (ICM)

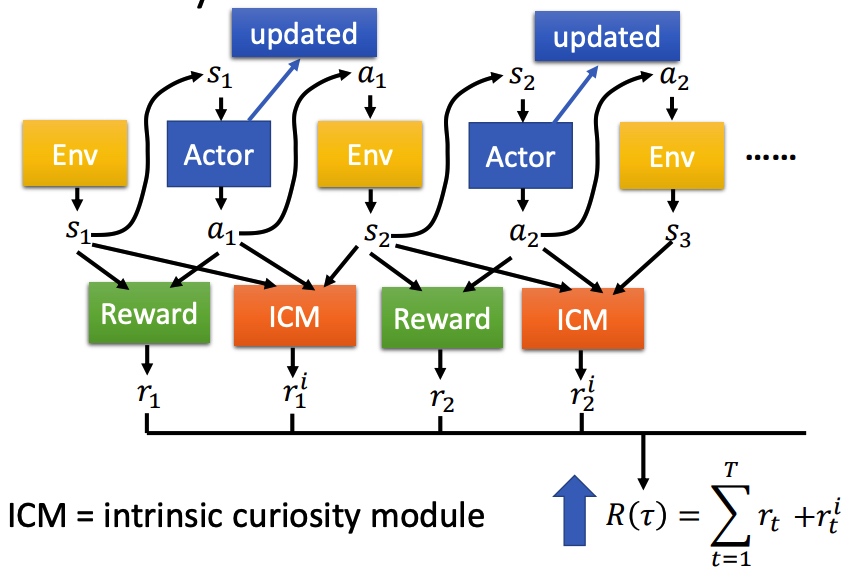

在原来 Reward 函数的基础上,引入 ICM 函数。ICM 鼓励模型去探索新的动作。最后 ICM 和 Reward 和越大越好。

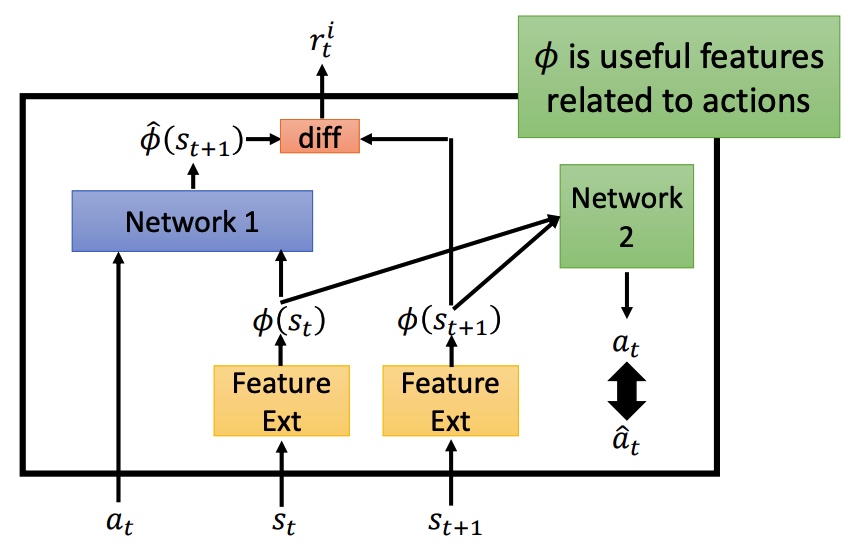

鼓励探索新动作之后,会导致系统风险变大。对比预测的下一个状态和真正的状态的差异程度进行抑制。

Feature Ext 对状态进行抽取,过滤没有意义的内容。 Network 1 预测下一个状态,然后再和真实状态计算 diff 程度。 Network 2 预测 action,和真实的 action 进行对比。如果两个 action 接近,说明 f 可以进行特征提取。重要程度计算。

Curriculum Learning

规划学习路线,从简单任务学习。

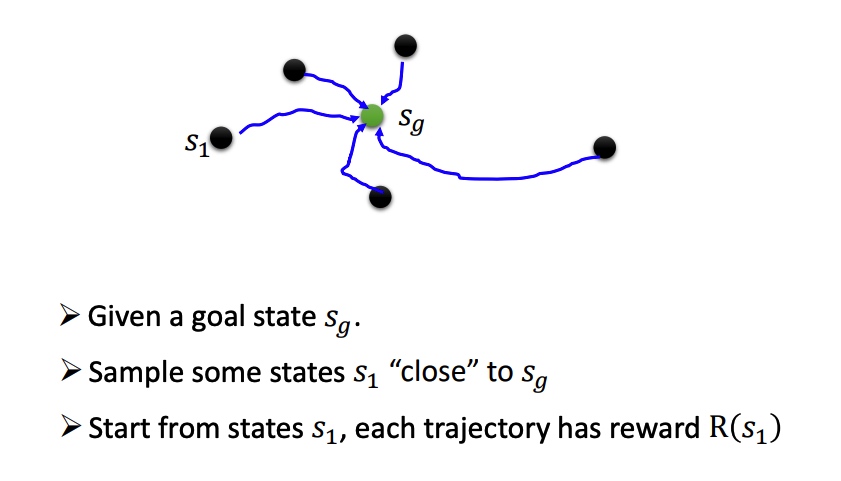

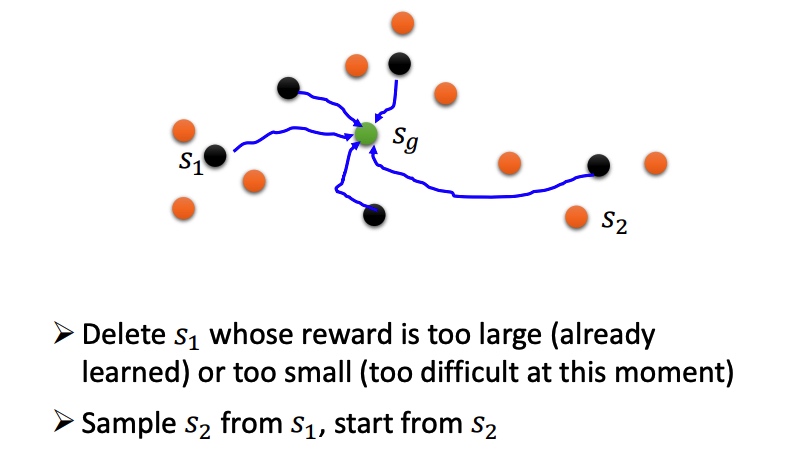

Reverse Curriculum Generation

Hierarchical Reinforcement Learning

对 agent 分层,高层负责定目标,分配给底层 agent 执行。如果低一层的agent没法达到目标,那么高一层的agent会受到惩罚(高层agent将自己的愿景传达给底层agent)。

如果一个agent到了一个错误的目标,那就假设最初的目标本来就是一个错误的目标(保证已经实现的成果不被浪费)

Recommend

-

51

51

-

8

8

李宏毅强化学习课程笔记 Actor Critic 发表于 2020-09-06...

-

8

8

我的笔记汇总: apprenticeship learning 无法从环境中获得 reward。 某些任务中很难定义 reward。 人为设计的奖励可能导致意外的行为。 学习专家的行为。 Behavior Cloning 监督学习,但...

-

8

8

李宏毅强化学习课程笔记 PG PPO Q-Learing 发表于 2019-12-26...

-

4

4

...

-

6

6

近日学习了李宏毅教授(Hung-yi Lee, NTU)的强化学习课程,从Policy Gradient,到Q-learning,再到Actor-Critic算法,感觉脉络非常清晰。总结了一点听课时记录的笔记,以供日后复习理论知识时用。 Policy GradientActor, Environment, Rewar...

-

6

6

强化学习课程系列之四:模型无关的策略估计 模型无关的策略估计(model free prediction),可以看作是求解环境知识不完整的模型在特定策略π下的每一个状态值函数,模型无关(model free),是指对于模型的环境知识知...

-

8

8

强化学习,目的就是求解MDP(马尔科负决策过程),而MDP的求解有三种情况: 动态规划求解法:求解一个已知环境完整知识的MDP。有两种方法: Model free prediction:对于一个环境知识不完整的MDP, 估计状态值函数。有两种方法:...

-

3

3

马尔科夫模型 关于马尔科夫,可以认为是一个自动机,以一定的概率P在各个状态s之间转移,马尔科夫模型由状态、转移概率矩阵{s,p}两部分组成。 关于隐马尔科夫模型(HMM),比马尔科夫多了一个观测集合 O。可以认为是一个双重随机过...

-

5

5

最近在看reinforcement learning 的视频课程,记录了一些笔记,顺便整理成博客,课程内容复杂有些难理解,博客也许会有些错误的地方,望指正谅解,大家一起学习. 机器学习分类 机器学习大概可以分为以下几个类别: ...

About Joyk

Aggregate valuable and interesting links.

Joyk means Joy of geeK