生产服务CPU飙高分析

source link: https://fantalovelife.club/2021/02/24/%E7%94%9F%E4%BA%A7%E6%9C%8D%E5%8A%A1CPU%E9%A3%99%E9%AB%98%E5%88%86%E6%9E%90/%E7%94%9F%E4%BA%A7%E6%9C%8D%E5%8A%A1CPU%E9%A3%99%E9%AB%98%E5%88%86%E6%9E%90/

Go to the source link to view the article. You can view the picture content, updated content and better typesetting reading experience. If the link is broken, please click the button below to view the snapshot at that time.

生产服务CPU飙高分析

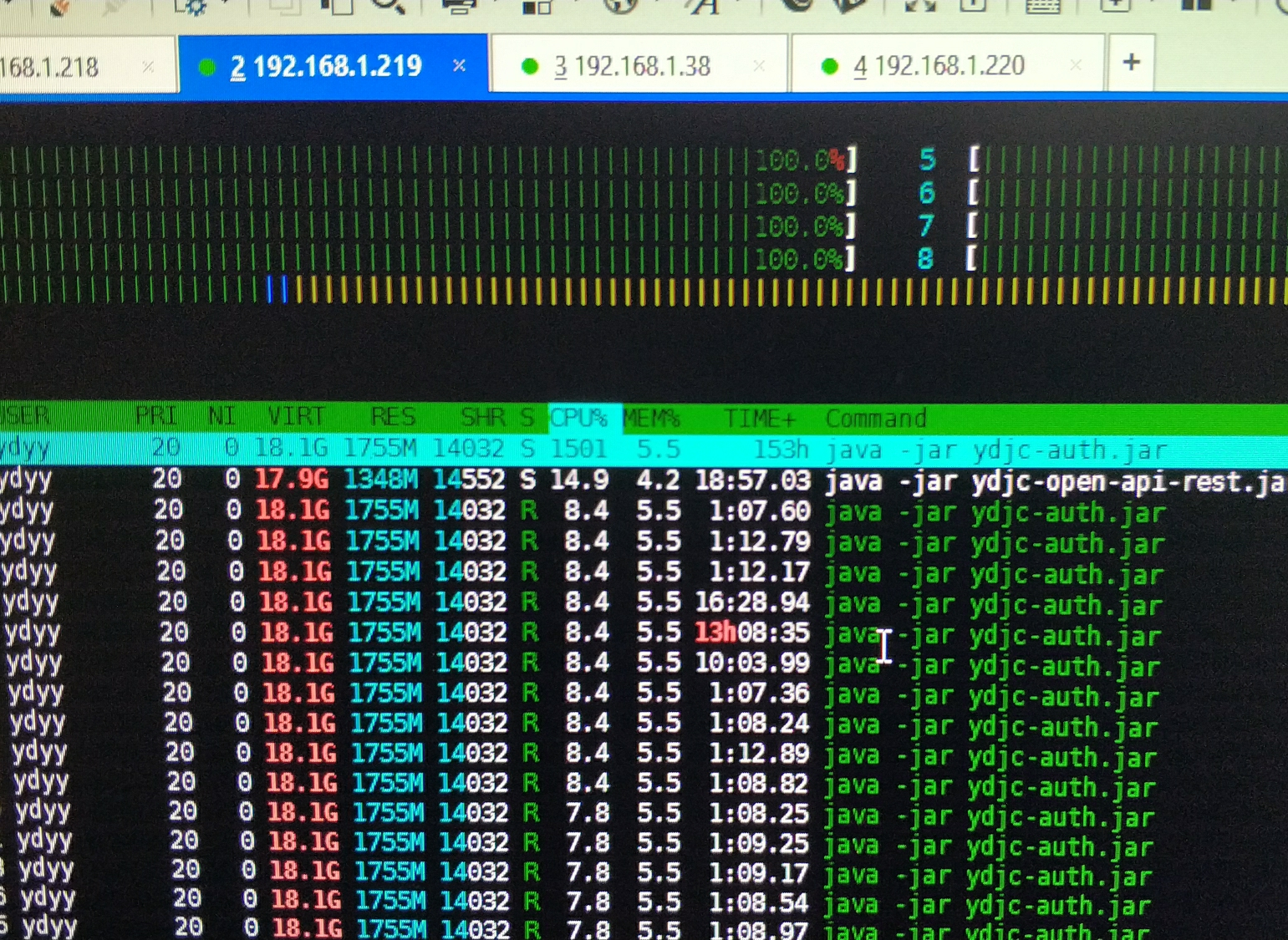

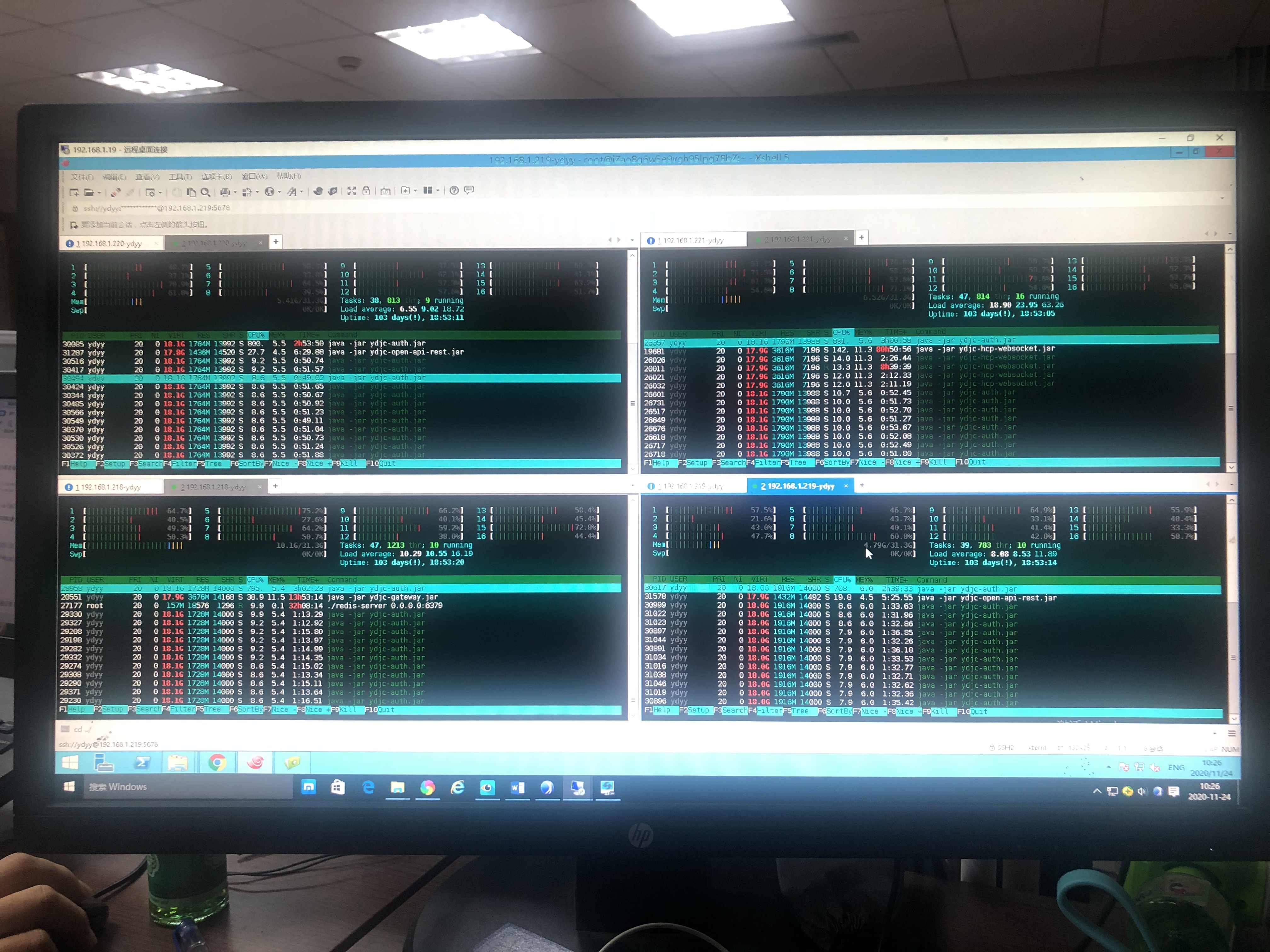

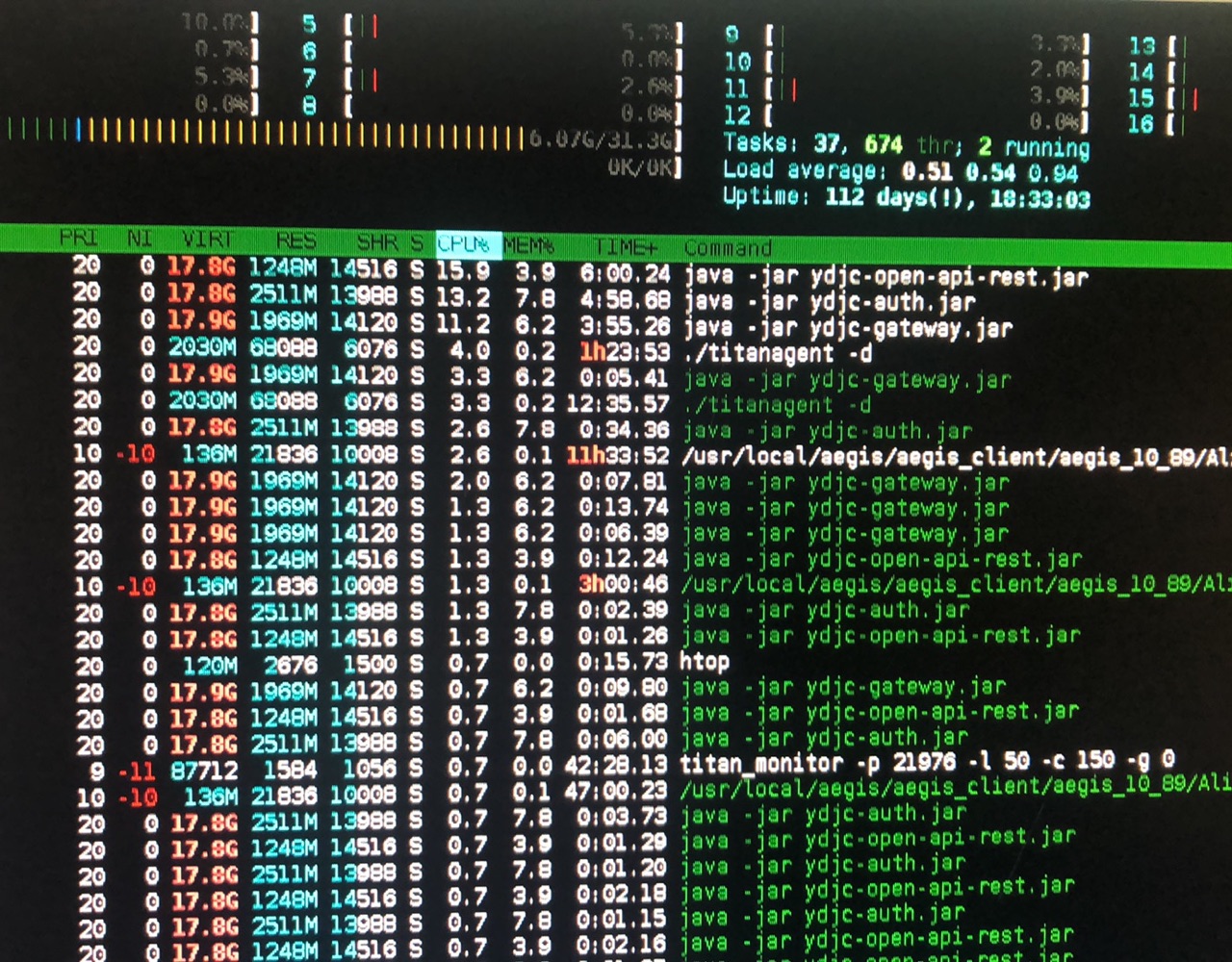

生产中,随着扫码相关提供的服务大量接入,高并发为服务带来了不稳定性,主要体现在机器状态很差 CPU经常飙高至1500%以上.

第一次优化

生产CPU飙高,我们可以猜测主要是因为俩个方向影响:

1、大量计算在消耗CPU

2、大量线程和程序上下文频繁切换导致拖累CPU

问题一开始,我是定位到了第二个点,因为我根本没考虑大量计算会消耗,这也是问题分析比较不好的习惯,以己度人。我用自己可能常见的分析去揣测,这是比较傻的行为。

对于一开始认为的第二个点,主要优化了Tomcat的一些参数,对于连接数和线程池的分析,参考了文章。【1】 然后有了如下的大致估计量和参数

# Tomcat

server:

tomcat:

uri-encoding: UTF-8

#最小线程数

min-spare-threads: 500

#最大线程数

max-threads: 800

#最大链接数

max-connections: 6500

#最大等待队列长度

accept-count: 1000

#请求头最大长度kb

max-http-header-size: 1048576

#请请求体最大长度kb

max-http-post-size: 2097152

#链接建立超时时间

connection-timeout: 12000

第一次优化后,有了如下的效果。大致下降到800%左右的。但任然是超高的负载。

其实对于后面模拟测试也可以发现,线程的数量取舍也比较重要,模拟下来大多都是block的线程而且内存cpu都呈锯齿状,可以说明资源短时间内其实是过剩的

所以第一次的数值是具有问题的,没有摸清性能拐点在哪里。

第二次优化

在苏彭的帮助下,详细了解了tomcat一些线程的参数。上面所示的参数对于单个节点来说,负载相当大

#最大链接数

max-connections: 6500

#最大等待队列长度

accept-count: 1000

尤其这俩个参数的设置,会把线程等待拉到很高的值。相对于CPU就是很高负载。

所以稍微调整一下参数,一个对于单个节点相对合理的参数(因为鉴权这个服务本身就是高并发的,所以最小线程我们也调整的很高,对于慢热的那种系统,建议此数值适量调低)

# Tomcat

server:

tomcat:

uri-encoding: UTF-8

#最小线程数

min-spare-threads: 400

#最大线程数

max-threads: 500

#最大链接数

max-connections: 4500

#链接建立超时时间

connection-timeout: 12000

服务代码中也优化了一处,有个作为常量的HashMap,也修改为了ConcurrentHashMap

对于HashMap在高并发在发生死循环CPU飙高,可以查看详细介绍【1】

至此,每个节点忙时峰值CPU大概下降到300%

如果线程频繁切换和可能出现的死锁问题都解决了,CPU仍然稍高,可能就是真的存在密集计算的问题了,所以有了第三次优化的过程。

第三次优化

第三次优化才是真正解决问题的时候,虽然已经勉强满足了正常忙时机器状态。

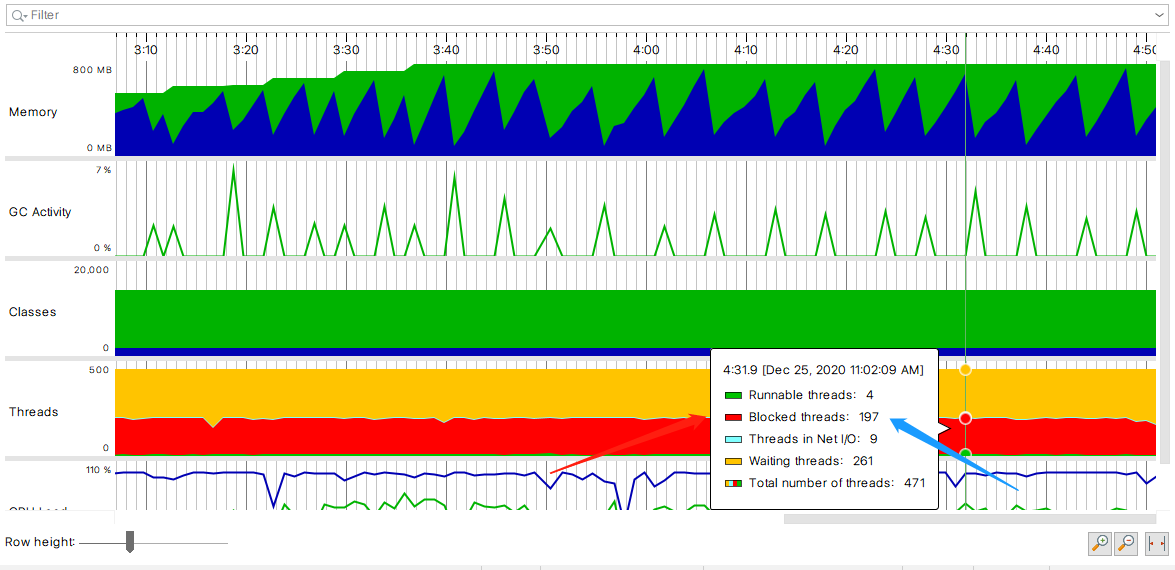

然后拜托运维拿到了鉴权服务忙时的jstack和jconsole一些基本数据

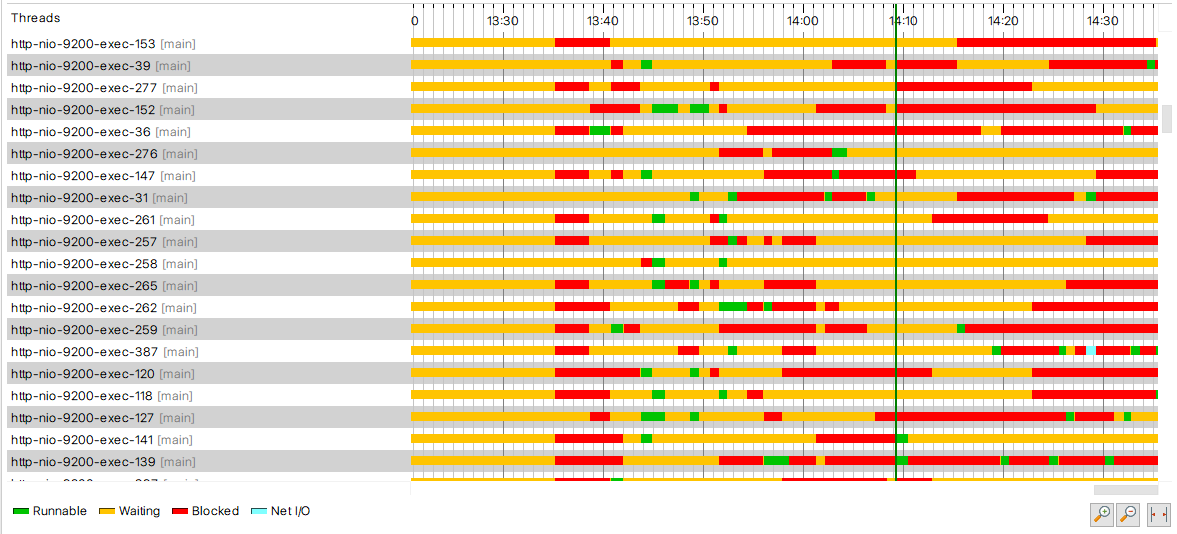

分析后发现,内存稳定,新老代也稳定,基本上确定是大量计算而不存在线程切换和死锁问题了

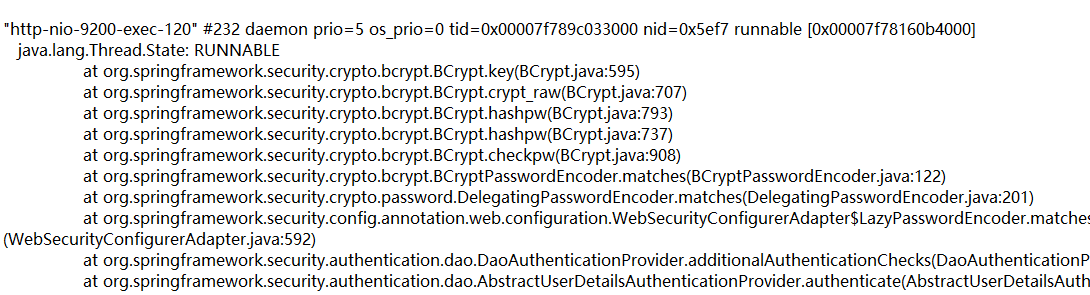

随后定位到如下RUNNABLE的一个线程。显示BCrypt算法一直在拖累系统。

随后看了一下block的线程

再从calltree中查询一下

可以看到确实存在密集计算的影子

查了一下资料【2】发现Bcrypt算法还真的是x86 cpu还有arm cpu的密集运算

算法保证了很高的安全性,是非常强的Hash算法,为了高安全刻意设计的如此消耗cpu的一个强散列算法。。。所以用这种算法保证鉴权的一些服务肯定是需要考量一下安全和性能的平衡。

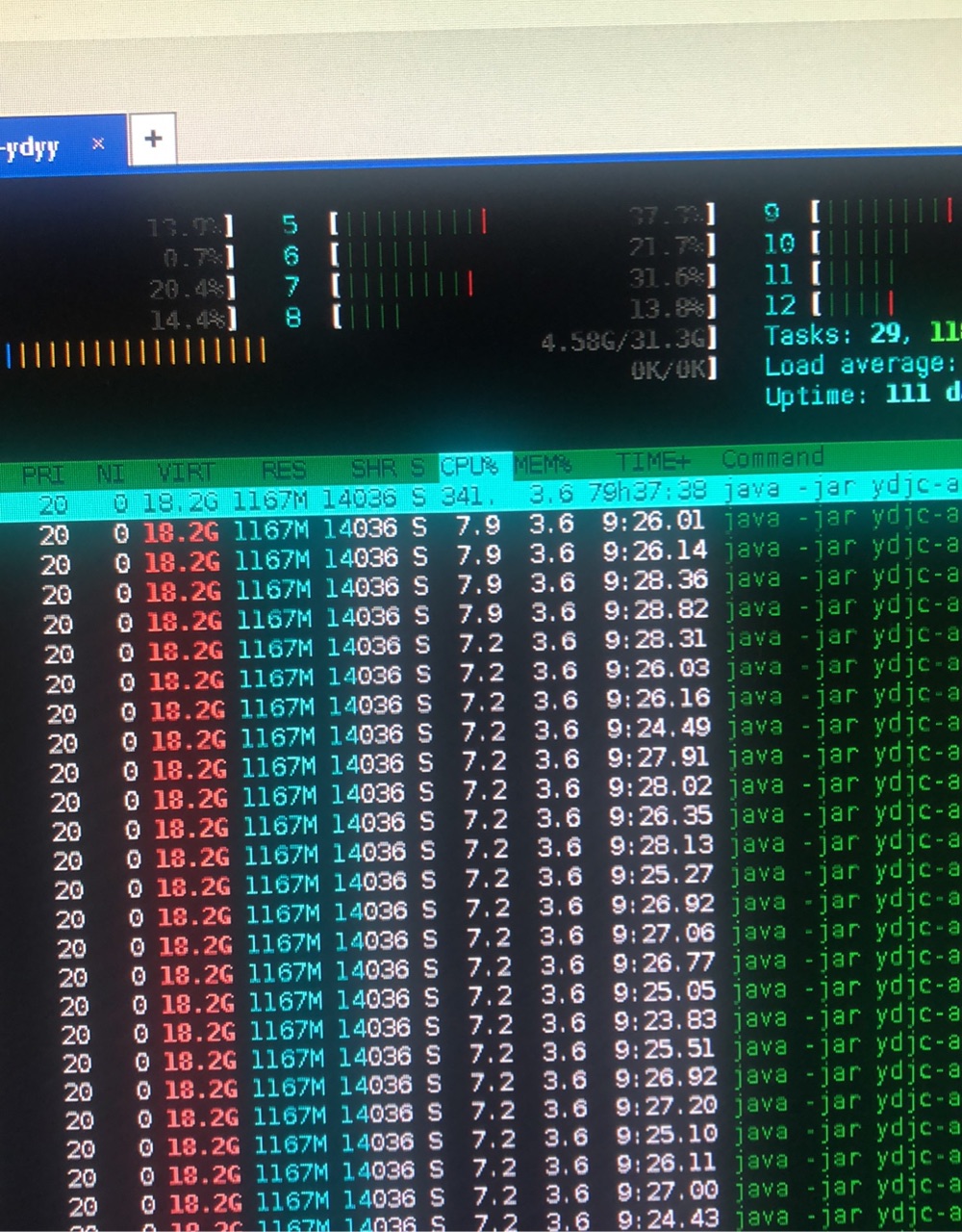

在做过一系列压测和调研后,设计将一些内部的服务间访问,还有局域网内系统间访问的都修改为MD4这种弱Hash,对于暴露外部系统的继续使用Bcrypt强Hash。

具体的切换过程,可以参考shardingsphere脱敏的流程。

还有一个技巧是可以通过nacos权重来测试一下生产改变后的负载状态是否满足需要

调整后,每个节点CPU均已正常。

对于生产故障的思考

- 首先从发生到完全解决 我用了三天,对于生产个人认为最快的响应才是最重要的。解决问题可能根据个人能力有快有慢,这个时候最快的响应比如说“增加节点” 相信可能是最好的方式。

- 对于故障问题,切记不能以己度人。多分析,多思考。

- 对于降级服务,可以通过Mock对象方式来补偿。

- 感谢帮助过的人:

相关的文章

Recommend

-

45

45

处理过线上问题的同学基本上都会遇到系统突然运行缓慢,CPU 100%,以及Full GC次数过多的问题。当然,这些问题的最终导致的直观现象就是系统运行缓慢,并且有大量的报警。本文主要针对系统运行缓慢这一问题,提供该问题的排查思路,从而定位出问题的代码点,进而...

-

14

14

作者:爱宝贝、 https://my.oschina.net/zhangxufeng/blog/3017521 处理过线上问题的同学基本上都会遇到系统突然运行缓慢,C...

-

29

29

压测时或多或少都收到过CPU或者Loa...

-

9

9

记一次CPU与内存飙高的线上事故 ...

-

12

12

GitHub 20k Star 的Java工程师成神之路,不来了解一下吗! GitHub 20k Star 的Java工程师成神之路,真的不来了解一下吗!...

-

11

11

服务接口http请求瞬时并发高 cpu飙高如何解决? ...

-

10

10

历史笔记总结,温故而知新。 一、背景概述 Java开发中,有时候我们会碰到下面这些问题:OutOfMemoryError,内存不足和泄露问题:彻底深入理解和分析Java...

-

5

5

前段总结 彻底深入理解和分析Java中内存溢出OutOfMemoryError 和此文是姐妹篇。前面总结的是内存问题,本文总结的是cpu问题。 以前也经常遇到java进程cpu飙高的问题,但是解决这...

-

4

4

情人节临近,玫瑰价格飙高,郁金香、小苍兰等小众花受捧 专栏号作者 财经故事会 / 砍柴网 / 2022-02-11 21:21 来源 / 财经故事会 随着情人节临近,鲜花...

-

3

3

生产系统CPU飙高问题排查 生产系统CPU占用过高,并且...

About Joyk

Aggregate valuable and interesting links.

Joyk means Joy of geeK