MetaHuman+iPhone,宝藏开发者把数字人软件玩出新花样

source link: https://www.vrtuoluo.cn/523672.html

Go to the source link to view the article. You can view the picture content, updated content and better typesetting reading experience. If the link is broken, please click the button below to view the snapshot at that time.

文/VR陀螺 豌豆

得益于虚拟现实技术以及人工智能和深度学习技术的快速发展,数字人在新闻传媒、影视娱乐等领域快速普及。近期,虚幻引擎开发商Epic Games推出的工具MetaHuman Creator备受关注。

MetaHuman Creator与现阶段市面上常见的“捏脸”应用不同,用户可以基于近乎傻瓜式的交互方法,以极大自由度轻松快捷的创建独一无二的高保真数字人类,即MetaHuman。用户可以直接修改数字人的面部特征、调整肤色,甚至是编辑牙齿和瞳孔颜色这种细枝末节的部分。应用支持导入第三方软件(比如3D MAX、MAYA等)的模型文件,也可以直接选择其内部预设的体型、发型、服装等。在完成快速角色设定后,可以将其导出并下载到虚幻引擎中制作动画。

该工具可以在不牺牲质量的情况下,将制作3D虚拟角色模型的时间由数周或数月大幅缩短至一小时内,而且视觉上的渲染效果很逼真,细节动作也十分流畅。

图源:Epic Games

MetaHuman Creator正式推出后,不少蠢蠢欲动的开发者们开始尝试用这款软件做一些有趣的事情。其中最为活跃的,要数Twitter上一个名为Matt Workman的开发者。

MetaHuman Creator+动作追踪,数字人被玩出新花样

Matt Workman时常在Twitter和YouTube分享一些关于数字人的实时demo演示。

在一段视频中,Matt Workman展示了通过VIVE Tracker搭配Index的指虎手柄实现的实时数字人录制效果。他更愿意将其数字人的VR远程控制称为“Real Time Smart Puppet System”( “实时智能人偶系统” ),而不是“Motion Capture System”(“运动捕捉系统”),数字人在VR中能立即与数字环境进行交互,这与运动捕捉不大一样。

实时智能人偶系统(图源:Youtube)

通常,传统的企业级动作捕捉系统,无法让被捕捉者看到反馈效果,他们只能在一个区域里做动作,然后由另外一处的计算机显示出监看画面。这需要至少两人协作完成,以及至少两台以上的计算机实现显示和捕捉计算。

MetaHuman Creator为虚拟社交建立了范例,即玩家/开发者能够基于现有的捕捉设备和一台计算机,完成执行和实时监控数字人的全部工作。他们可以基于虚幻引擎的智能系统实时看到反馈效果,这对于虚拟直播、虚拟演唱会等使用场景来说非常实用且成本低廉。

最主要的是,即使你只是站在原地做动作,虚幻引擎导入的MetaHuman Creator模型骨架也可以实现模拟行走、跑跳之类的动作。这种感觉就像是在家里玩一款VR跑酷游戏,数字人的上半身是真实的动捕反馈,而下半身的走动则可以通过AI实时生成。

动作捕捉(图源:网络)

正如上述,尽管企业级动作捕捉系统早已不是新鲜事,但这一领域尚未出现过MetaHuman Creator这类以如此简洁的应用实现高精度数字人动捕的案例,而之前的一些类似‘捏脸’软件,与传统的动作捕捉(影视、游戏级别)效果无法比拟,MetaHuman Creator的问世令二者之间的差距开始缩小。

对于像Matt Workman这样善于运用新科技工作的开发者而言,MetaHuman Creator就像是一把打开潘多拉宝盒的钥匙。

图源:Twitter

除了上述装备,Matt Workman还曾展示过使用其他VR硬件——HTC的VIVE Pro-Eye头戴设备并附带唇部追踪器VIVE Facial Tracker,这为他提供了在佩戴VR头显时将眼睛和嘴唇动作真实映射到数字人身上的硬件基础。

演示视频里,Matt Workman并没有选择对腿部和复杂的跑步动画进行追踪——他更想在坐着或站着时使用数字人,并希望通过软件计算来整合全身的基本运动。他在另一个视频中分享了一个新的实时追踪demo:在没有使用VR头显跟踪的情况下,他的面部表情通过iPhone拍摄并实时呈现在数字人上。

State of the MetaHuman

视频中他将胸部追踪器转移到背部上,把手肘上的追踪器调整到手臂下方,这样手臂就有了更多的移动空间。他还为Index Controllers添加了“移动”("locomotion")控制,这样就可以轻松地在数字场景中重新定位数字人的位置。与此同时,他也使用了虚幻引擎的自带插件ControlRig,让数字人的动作更流畅。

据Matt Workman所说,以每秒60帧的更新速率来看,VR唇部追踪器“在大多数情况下”可以更精确地运行。如果选择使用VR头显,还可以看到数字人直接位于其中的数字环境,提供了更真实的整体印象。

图源:Unreal Engine

用手机实现数字人的动捕控制,这一出奇想法令Matt Workman的demo视频迅速在各大论坛走红。因为几乎从来没有人能通过一台iPhone完成如此高精度的面部表情还原。

他是如何做到使用iPhone将自己的面部表情捕捉到数字人身上?我们需要先介绍一下由Epic Games推出的iOS应用《Live Link Face》。

11步用iPhone实现人脸动作捕捉

Epic Games的虚拟视频制片项目经理Ryan Mayeda在视频中介绍《Live Link Face》的追踪功能是利用了苹果的ARKit和iPhone的TrueDepth前置摄像头,可以对用户的面部进行交互式追踪,并通过Live Link直接将该数据从网络发送到虚幻引擎中。

图源:YouTube Unreal Engine

虚幻引擎要利用iPhone中的免费应用《Live Link Face》做到实时人脸捕捉,下载好应用程序后,这里还需要激活主要的几个插件:

Live Link:人脸捕捉数据是通过使用Live Link协议传送的。

Apple ARKit、ARKit Face Support:能进行人脸追踪的功能。

Time Date Monitor:能可视化从苹果手机传入虚幻引擎的时间码。

接下来就可以开始准备录制视频了:

1.你需要准备一个已经绑定好一组面部骨架的角色,且这组骨架变形逻辑需要与ARKit面部识别生成的面部骨架变形逻辑相吻合。通常你需要在第三方绑定,以及在动画工具(例如Autodesk Maya)中执行此操作,然后将角色导入虚幻引擎。

2.在虚幻引擎中使用一个包含 Live Link姿势(Live Link Pose) 节点的动画蓝图来设置角色。在收到手机发送的动画数据后,你将通过此节点将数据应用到角色上。

3.获取计算机的IP地址连接《Live Link Face》应用程序。你通常可以在电脑的控制面板或设置中找到IP地址。

4.将手机和计算机连接到同一无线网络;或使用以太网网线,通过Lightning以太网适配器将手机直接连接到计算机。

5.在iPhone上运行《Live Link Face》应用程序。在LiveLink设置页面中点击 添加目标(Add Target),然后输入计算机的IP地址。

图源:Unreal Engine

6.在虚幻编辑器中,在主菜单中选择 窗口(Window) > Live Link,打开 Live Link 面板。此时iPhone被列为主题;在角色的动画图表中找到 Live Link Pose 节点,将其主题设置为代表iPhone的主题。

7.在角色的动画图表中找到 Live Link Pose 节点,将其主题设置为代表iPhone的主题。

8.编译(Compile) 并保存(Save) 动画蓝图。

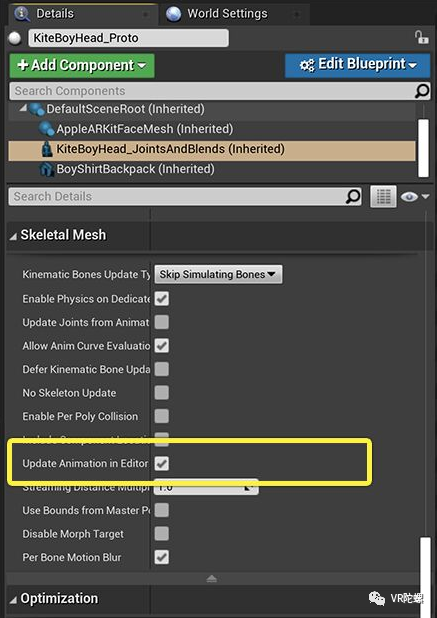

9.选择角色。在“细节”(Details) 面板中,须启用“骨架网格体”(Skeletal Mesh) 类别中的“在编辑器中更新动画”(Update Animation in Editor)设置。

图源:Unreal Engine

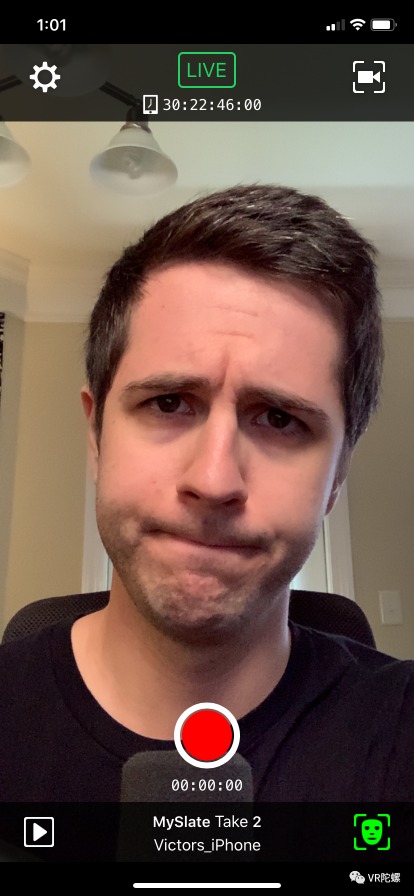

10. 返回《Live Link Face》,将手机摄像头对准你的脸部,直到应用程序识别出人脸并开始追踪你的脸部动作。

11. 当你准备要录制表演时,请点击《Live Link Face》应用程序中的红色录制(Record)按钮。这将开始在iPhone上录制表演,并在虚幻编辑器中启动镜头试拍录制器,开始在引擎中的角色上记录动画数据。再次点击录制(Record) 按钮停止录制。

录制好的视频可以点击《Live Link Face》左下角进行预览和分享。

《Live Link Face》还支持OSC(开源控制)协议,复杂的制片流程可以利用这一点,让外部应用来远程控制Live Link Face,实现诸如通过一次点击或触摸就让多台iPhone同时开始录制的功能。

MetaHuman,未来已来

虚幻引擎向我们展示了不少优质的数字人案例,动作类游戏《地狱之刃》角色塞娜(Senua)、根据国内演员姜冰洁的相貌制作的高保真数字人Siren,以及Andy Serkis和Mike Seymour等等。

这也说明数字人未来将有可能被更广泛地运用到游戏、影视、传媒等领域。

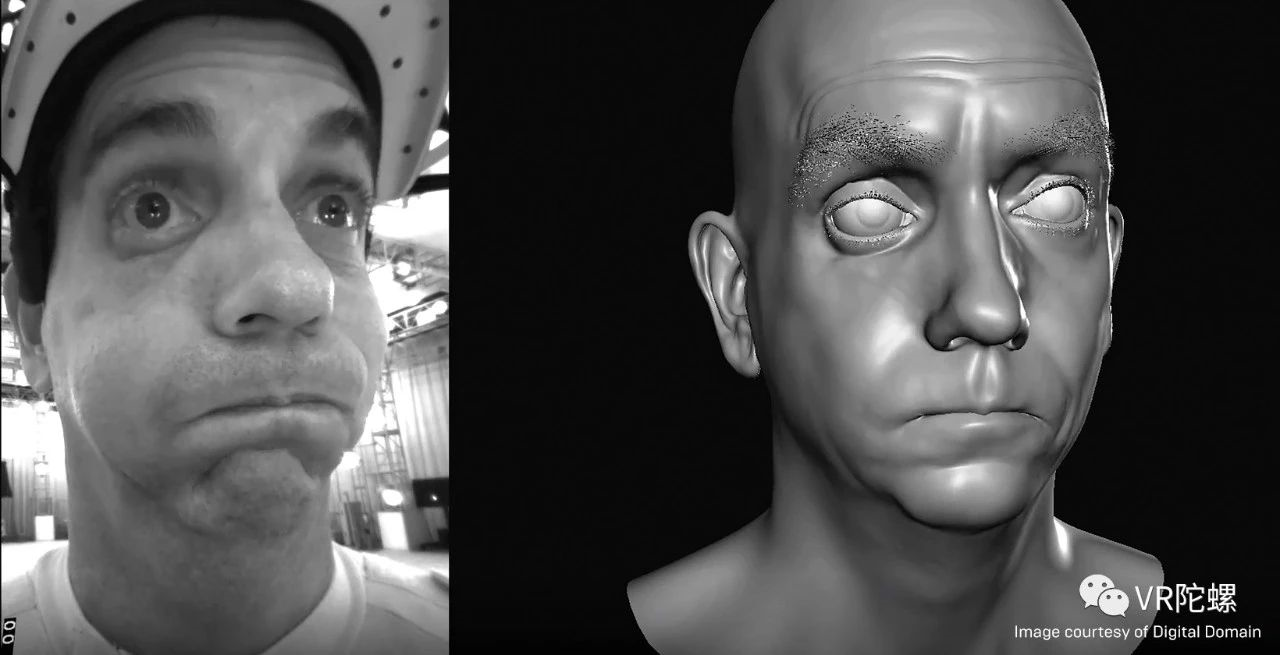

图源:Digital Domain

新世代的游戏角色和影视角色将会令用户刮目相看,我们会发现越来越多的影视作品开始注重高仿真角色的塑造。影视角色的背后是利用了实时“动捕”技术的真人动作替身演员,而虚拟场景中的高保真数字人正将演员的全部表情和动作都还原出来,这样的技术可能会对未来影视行业带来巨大变革。

时间是影响到团队制片的重要因素,短时间内实时制作高度逼真的角色面部表演将大幅提高制作效率。Digital Human Group发现,使用摄像机以非常高的分辨率捕捉面部动作不仅能返回更好的表演效果,还让它们有机会运用人工智能和深度学习使这一过程得到前所未有的改进。

图源:忍者理论

玩家也在追求游戏世界的高开放度和高保真度,近年来的3A游戏更是不断追求接近真实的物理渲染和精细的全局光照。而对沉浸式VR游戏中的玩家来说这不仅是全新的体验,也会成为他们未来选择游戏的一个关键点。

在未来游戏开发中,我们可能会看到在技术不断进步的情况下,硬件和软件两方面互相结合,相互进步,不断推动游戏产业发展。游戏的NPC或许会更加智能,表情和动作将更有真实感。

数字人脸非常容易产生所谓的“恐怖谷”效应,只要他们的外观稍有偏差,他们的面孔就会变得非常怪异僵硬。要制作以假乱真的数字人,面部捕捉技术方面的进步就成为了关键。观众能够本能地知道真人的面部肌肉、皮肤和眼睛动起来是什么样的,这就使制作数字人面部动画的过程显得特别有挑战性。

图源:央视网

2021年两会,在央视网特别策划“两会C+真探”系列直播节目中,虚拟小编小C“上岗”当天就成功与全国人大代表梁倩娟进行了线上直播对话,小C与梁倩娟代表的采访全程自然,互动流畅,极大提升了连线采访的趣味性。

高品质的实时渲染结合人工智能驱动技术,改变了年轻受众对传统媒体的固有印象,也大大提升了两会报道的科技感,数字人再度“破圈”。为新闻传媒直播提供了全新的报道模式。

我们期待数字人技术能更加成熟,未来会陆续出现在更多领域。

参考来源:

https://www.unrealengine.com/zh-CN/spotlights/digital-domain-s-quest-to-craft-the-ultimate-digital-human

https://mixed.de/vr-metahuman-dieser-entwickler-digitalisiert-sich-selbst/

投稿/爆料:[email protected]

稿件/商务合作: 西瓜(微信 18659030320) 尤加(微信 13129537525) 六六(微信 13138755620)

加入行业交流群:尤加(微信 13129537525)

版权申明:本文为VR陀螺原创,任何第三方未经授权不得转载。如需转载请联系微信:vrtuoluo233 申请授权,并在转载时保留转载来源、作者以及原文链接信息,不得擅自更改内容,违规转载法律必究。文中有图片、视频素材来自互联网或无法核实出处,如涉及版权问题,请联系本网站协商处理。

扫描二维码关注VR陀螺微信公众号

查看更多精选内容

Recommend

About Joyk

Aggregate valuable and interesting links.

Joyk means Joy of geeK