端侧 AI 新篇章!商汤科技发布「速度最快」的端侧模型

source link: https://www.geekpark.net/news/334277

Go to the source link to view the article. You can view the picture content, updated content and better typesetting reading experience. If the link is broken, please click the button below to view the snapshot at that time.

端侧 AI 新篇章!商汤科技发布「速度最快」的端侧模型

0.4 秒响应、格斗游戏暴打 GPT-4……商汤发布新一代端侧模型。

作者 | Li Yuan

编辑 | 郑玄

设计行程、生成文案、做总结、智能扩图,端侧模型竟然能做到这些了?而且这么快?

4 月 23 日,商汤发布了日日新 5.0 大模型体系,其中,商量端侧模型 SenseChat-Lite 成为了此次发布的亮点,不但全面领先所有开源 2B 的同级别模型,并在测评上部分超越 Llama-2 7B 模型的效果。

自去年以来,端侧大模型一直是消费电子行业和人工智能行业共同关注的热点。

端侧大模型,是运行在设备端的大模型,通常比我们熟悉的 GPT 等大模型参数量更小,因此可以使用端侧算力直接运行。端侧 AI 有着在任何网络条件下都可以生成回答、隐私不必离开设备、且无需云端算力因此成本更低等种种优势。

更强的端侧 AI 能力,意味着原本做不到的用户场景将被进一步打开:工作文件也可以直接用手机大模型进行处理,无需担心机密外泄;没有网的飞机上也可以和外国人流畅聊天;不想给孩子的手机联网,但也可以让孩子能够在不联网的情况下学习知识,听故事。

因为成本更低,对消费电子产业本身也将产生影响,端侧模型将使包括汽车、XR 在内的种种终端设备,尤其是平价的电子设备如智能音箱等,能够有机会接入智能体验,而无需过多考虑算力成本。低延时,也将使得 AI Pin 这样的未来设备的场景打开,获得可用的体验。

此次极客公园见到的端侧模型能力的最新展示,让我们感受到端侧 AI 的进展飞速。未来端侧 AI,市场必将十分广阔。

最快端侧大模型

让我们最惊讶的,首先是端侧大模型的响应速度。

虽然测试前,我们已经了解到此次商汤的大模型,响应速度极快,但是测试效果还是让人感到惊艳。

对于人眼来说,每秒看 20 个文字已经是人眼的极限了。

而此次,商汤的模型在中端平台上可以做到 18.3 字每秒,旗舰平台上能达到 78.3 字每秒!测试中,生成速度果然很快,确实给人一种人眼快要跟不上了的感觉。

除了生成速度,响应速度也比我们熟悉的云端 AI 要更快。

小米小爱团队的负责人王刚曾表示,在做小米小爱的产品时,为了让用户体验更好,团队原本希望能找到响应时间低于 1.4 秒的云端模型接入,但发现 1.4 秒对于云端大模型而言都太苛刻了,实际上接入的云端模型,响应时间在 2 秒左右。

而此次,商汤的端侧模型,首次加载时间低于 0.4 秒,远远低于即使是较为先进的云端模型的响应速度。响应速度和生成速度加在一起,共同构成了端侧模型给我们的第一感受,就是快——不愧是目前业内最快的端侧模型。

除了响应速度,我们还测试了模型的基础能力。

我们先看一下模型的生成能力。

给的提示词为:帮我写一篇红楼梦的读书笔记。

可以看到,虽然在提示词中我们并没有进行字数要求,SenseChat-Lite 可一点没有偷懒,直接生成了一篇字数相当长的读书笔记。

并且很明显,模型本身对红楼梦的故事的走向、意义,人物的解读都比较到位。

害怕小朋友拿起联网的手机就玩个没完吗?以后说不定,就可以直接给小朋友一个断网的手机,让大模型辅导小朋友了。

我们接着做了一条微博文案的生成。

令我们惊喜的是,在这个场景下,我们也没有对字数进行限制,但模型就自主地生成了一条较短的文案,来匹配微博的字数限制。甚至还懂得加上 # 毕业祝福 # 的标签。

很明显,模型使用了中文的语料进行训练还是有用的。模型对于各个场景下需要怎样的文案长度,文案风格,都非常了解,直接就能模仿生成。

完全可以想象,基于同样的模型能力,你也可以直接使用端侧模型,生成淘宝评论,生成朋友圈文案,生成活动宣传。

商汤表示,在训练过程中,大量地学习了用户在手机场景下喜欢问的问题,专门对应做了训练,看起来确实效果不错。最后,我们测试了文档总结的功能。

端侧模型很快地将一个七段的复杂文本,归纳为了两段的文案。

你收藏了多少太长不看的文章?

这也很正常,手机看长文,确实就很反人性。

端侧 AI 来了之后,无论是飞机上,还是火车上,看不进去长文时,懒得看工作文件又不得不处理时,端侧模型都可以迅速地帮你归纳要点。

除了端侧的商量模型,商汤此次还展示了端侧的多模态扩散模型的能力。

多模态模型,在手机上,主要用来进行照片处理,可以用在包括相册管理、图片生成等多个场景中。

此次,我们看到的是商汤的 AI 扩图模型演示。用手机拍照时,有时候我们因为角度,或者为了避开游人而剪裁画面。AI 扩图则可以在这种情况下,用 AI 计算出图片的边界,生成无遮挡的图片,重新调整图片比例,生成更好看,更适合分享的图片。

演示视频,是商汤的自由扩图功能。实际上,商汤的 AI 扩图,有多种方式可选。既可以正常地等比扩图,照片拍歪了,也可以直接调整回正,让 AI 来操心剩下的事。

和 SenseChat-Lite 一样,此次的扩图,让我们最惊艳的点,仍然是其速度。

据悉,此次的扩散模型,也已经实现业内最快的端侧推理速度,在高通旗舰平台上能够做到小于 1.5 秒。在发布会现场,商汤也演示了和其他友商类似功能的速度比较,区别显著。友商的一个扩图加载完成之后,商汤的端侧模型已经扩展完成九张图了。

端侧 AI 也可以很智能

对于端侧 AI,一个跨越不过去的问题是,端侧 AI 够智能吗?

带着这样的疑问,我们观察了一下端侧 AI 的生成能力。

以文章开头的行程安排为例。行程安排,不但需要知识能力——对开罗有所了解,也需要一定的推理能力,才能设计出不错的行程。这点如果模型不够智能的话,很容易出现「听君一席话,胜似一席话」的局面,或者只生成简单的一两段回答。而此次,端侧模型生成的很不错。

商汤科技介绍,端侧模型之所以能够做到如此智能,是因为承载了商汤最新的数据清洗技术和优质数据。根据尺度定律 scaling law,使用优质的数据对模型进行训练,小尺寸模型的能力,也能超过比它更大一个尺寸的模型的智能能力。

同时在未来端侧模型真正落到用户的使用中时,商汤提出的解决方案是端云结合。

商汤表示,在知识类、考试类、问答类场景上,可以达到端侧处理占比超过 70%。在其他场景下,比例可能略有不同。不过根据对用户真正的使用场景分析,商汤认为,实际上,大部分时候,用户提的问题,都是知识类、问答类问题,端侧模型可以解决相当大的比例。

为什么需要端侧模型?

云端模型已经做的很好了,参数量大,能力又很强,为什么我们还需要端侧的模型?

对于普通用户而言,最明显的感知,可能还是在于生成速度快,这也是此次商汤发布的模型的优势。

商汤做了一个很有趣的小游戏,让 GPT-4 和商汤的端侧模型分别接管格斗游戏的玩家,来体现速度的意义。在游戏中,GPT-4 能够更好地分析怎么出拳闪躲,但端侧模型的响应速度极快,GPT-4 根本来不及分析如何闪躲,就被击中,最后的结果变成端侧模型乱拳打死老师傅。

在用户的使用中,响应速度快,能够不断降低用户使用 AI 模型的心理成本()。扩一张图用一秒还是五秒,可能会完全影响这个功能的使用体验。

除此之外,端侧模型,通过断网条件下的生成能力和对于隐私的更强保护,会扩展出新的 AI 使用场景。

无论是在飞机上办公,旅游到无人区查找救生攻略,网络条件不好的时候进行翻译,还是给孩子一个断网设备学习,把机密工作文件丢给大模型处理,让 AI 接触更多的个人数据等等,都是端侧模型未来能够提供的实用性的场景拓展。

而对于行业,影响或许更大。

目前,作为用户,我们接触到的云端模型,通常是免费的。但免费不代表没有成本,这样的成本通常由其他方为用户承受了。

比如小米曾经提到,接入大模型后,小米小爱的活跃用户次日留存增加 10%。

事实上,互联网产品通常需要做到翻天覆地的变化才能提升百分之五的次日留存。次日留存的增加会带来用户活跃度的增加,同时带来更多分发机会、更强的商业化能力。这对于小米公司,是非常有价值的商业机会。作为拥有多种手机、车、音箱等多种智能硬件的公司,小米公司自然希望将模型能够接入更多设备中,但这就涉及到云端模型的成本问题。

小米公司提到,中高端的手机和车目前对大模型成本不敏感,但类似音箱这样的设备,硬件公司很难承担用户在一个生命周期内使用大模型的成本。且随着大模型的能力提升,用户可能会越来越多地使用大模型,那么成本将成为更大的问题。

而端侧模型,使用的算力和电力是设备本身提供的,用户不需要额外付费,就能得到体验提升,但是厂家却能够省下云端的成本,是双赢的局面。端侧模型通往 AI 普惠的重要路径。

除此之外,端侧模型的数据的传输和延迟,对于智能硬件使用大模型的体验也非常重要。

之前备受瞩目的 AI Pin,拥有非常未来的概念——随时随地使用大模型助力生活,但是国外的测评中普遍表示体验翻车。主要的原因之一,就是 AI Pin 全部使用云端模型,当设备进入室内、停车场等不同位置,响应速度过慢,会严重影响产品的体验。而使用端侧模型,就可以避免这样的问题。

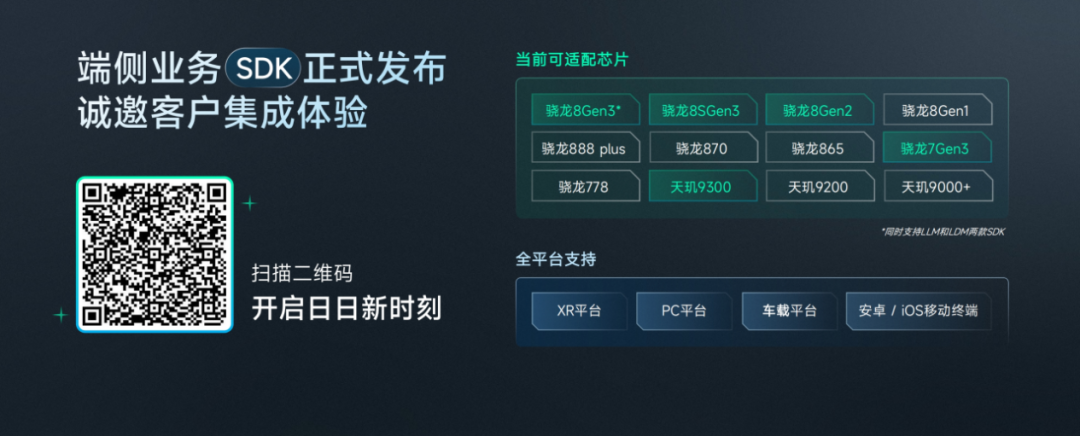

商汤的端侧模型,目前用户还无法直接在手机上体验到,需要智能硬件的厂商与商汤合作,共同部署。不过,商汤表示已经与包括小米小爱在内的多家头部厂商进行合作,相信很快,用户们在终端上体验到的智慧场景中,将有一大部分由终端 AI 承载。

除了能够适配多种芯片的手机外,商汤目前发布的端侧模型,也可以在 XR、车载等平台上使用,将能够实现这些设备的从无到有的智能体验。未来,还将开启端侧智能体的能力,进一步赋能智能设备。

商汤最新的端侧模型,让我们看到了端侧模型的底层模型能力,正在加速变强,端侧未来,也必将拥有广大市场。

商汤在从上一个 AI 时代就为手机提供底层能力。在大模型时代,再次抓住了相关的机遇,不但推出能力媲美 GPT-4 的云端大模型,此次又推出了速度最快的端侧模型。

手握智能设备市场在过往的良好合作经验,在端侧未来的广大市场,商汤大有可为。

*头图来源:视觉中国本文为极客公园原创文章,转载请联系极客君微信 geekparkGO

Recommend

About Joyk

Aggregate valuable and interesting links.

Joyk means Joy of geeK