英伟达发布史上最大的GPU芯片!盘点GTC2024上的重磅硬件产品

source link: https://server.51cto.com/article/784936.html

Go to the source link to view the article. You can view the picture content, updated content and better typesetting reading experience. If the link is broken, please click the button below to view the snapshot at that time.

英伟达发布史上最大的GPU芯片!盘点GTC2024上的重磅硬件产品

原创人工智能进入生成式AI阶段,大模型在给企业带来更高工作效率的同时,也对算力提出了更高的要求。为了解决算力带来的挑战,在今年的GTC2024上,英伟达重磅发布了全新的 Blackwell计算平台。此平台包含了NVIDIA GB200 Grace Blackwell超级芯片,以及第二代 Transformer引擎、第五代NVLink、RAS引擎等创新技术,还提供了全新的NVIDIA NIM软件包。

与此同时,基于NVIDIA GB200 Grace Blackwell 超级芯片和诸多创新技术与产品,NVIDIA还发布了更强大的新一代AI超级计算机——NVIDIA DGX SuperPOD,能够用于处理万亿参数模型,并具有持续的正常运行时间,以实现超大规模生成式AI训练和推理工作负载。

那么,被英伟达黄仁勋称之为更大GPU的NVIDIA GB200 Grace Blackwell 超级芯片,以及基于此打造的超级计算机,都有哪些亮眼的技术?让我们一起来看一下。

史上最大的GPU芯片

众所周知,大模型之所以“大”,是因为它有着巨大的参数。以谷歌LaMDA模型为例,其参数高达1370亿。另外,GPT-3模型参数高达1750亿,GPT-4更是被曝包含了1.8万亿参数,而规模越大,对算力的需求便越多,如训练GPT3.5需要用到约3万颗英伟达A100芯片。

GTC 2024上,黄仁勋以OpenAI最先进的1.8万亿参数大模型为例,介绍了其需要的算力情况。据介绍,该模型需要几万亿的Token进行训练,万亿参数与数万亿的Token相乘,就是训练OpenAI最先进大模型所需的计算规模。黄仁勋现场估算其计算规模为3×1025,如果利用一颗petaflop(每秒钟进行1000万亿次运算)量级的GPU进行运算,需要1000年的时间才能完成。

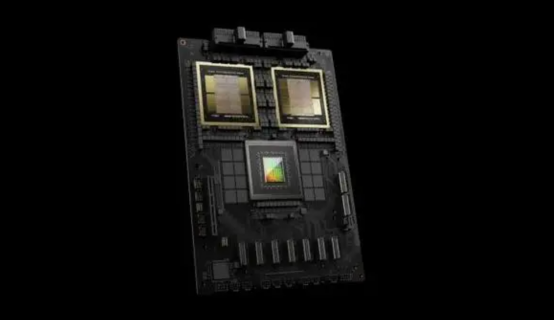

为了解决算力问题,NVIDIA正式推出了GB200 Grace Blackwell大芯片。之所以称之为“大”,不仅表现在其拥有当前GPU中最大的晶体管数量,提供了目前最高的计算性能,而且其拥有目前最大的GPU物理面积。

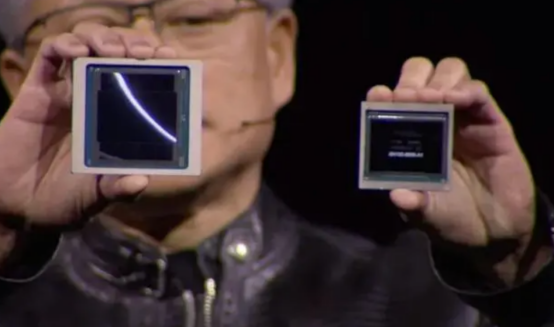

跟往年一样,在GTC2024上黄仁勋同样对GB200 Grace Blackwell芯片进行了展示。他从口袋里掏出一块Blackwell芯片,将它与Hopper芯片并排举起。可以看到,后者明显要小一些。黄仁勋表示,我们需要更大的GPU,Blackwell平台就是为了应对这一挑战而构建的。

作为当前面积最大的GPU,GB200 Grace Blackwell芯片通过900GB/s超低功耗的片间互联,将两个NVIDIA B200 Tensor Core GPU与NVIDIA Grace CPU相连。它采用台积电4nm工艺,拥有2080亿晶体管, AI性能达到20 petaflops。相比英伟达Hopper,Blackwell GPU的AI性能提升5倍,片上存储提升4倍。

除了拥有强大的计算性能之外,NVIDIA GB200 Grace Blackwell超级芯片还采用了以下五大核心技术:

1)第二代Transformer引擎:得益于全新微张量缩放支持,以及集成于NVIDIA TensorRT™-LLM和NeMo Megatron框架中的NVIDIA先进动态范围管理算法,Blackwell将在新型4位浮点AI推理能力下实现算力和模型大小翻倍。

2)第五代NVLink:为了提升万亿级参数模型和混合专家AI模型的性能,最新一代NVIDIA NVLink®为每块GPU提供突破性的1.8TB/s双向吞吐量,确保多达576块GPU之间的无缝高速通信,满足了当今最复杂LLM的需求。

3)RAS引擎:采用Blackwell架构的GPU包含一个用于保障可靠性、可用性和可维护性的专用引擎。此外,Blackwell架构还增加了多项芯片级功能,能够利用AI预防性维护来运行诊断并预测可靠性相关的问题。这将最大程度地延长系统正常运行时间,提高大规模AI部署的弹性,使其能够连续不间断运行数周乃至数月,同时降低运营成本。

4)安全AI:先进的机密计算功能可以在不影响性能的情况下保护AI模型和客户数据,并且支持全新本地接口加密协议,这对于医疗、金融服务等高度重视隐私问题的行业至关重要。

5)解压缩引擎:专用的解压缩引擎支持最新格式,通过加速数据库查询提供极其强大的数据分析和数据科学性能。

数据显示,Blackwell能够在拥有高达10万亿参数的模型上实现AI训练和实时LLM推理。

高达800Gb/s吞吐量的网络平台

除了高性能的计算芯片之外,随着数据量的爆炸式增长,网络连接在生成式AI时代也变得至关重要。

在GTC 2024上,NVIDIA发布了Quantum-X800 InfiniBand网络和NVIDIA Spectrum™-X800 以太网络,以及配套的开发软件。据了解,这是全球首批高达 800Gb/s 端到端吞吐量的网络平台,进一步加速了各种数据中心中的AI、云、数据处理和高性能计算(HPC)应用。

Quantum-X800平台包含NVIDIA Quantum Q3400交换机和NVIDIA ConnectX-8 SuperNIC,二者互连达到了业界领先的端到端800Gb/s吞吐量,交换带宽容量较上一代产品提高了5倍,网络计算能力更是凭借NVIDIA的SHARP™技术(SHARPv4)提高了9倍,达到了 14.4Tflops。

Spectrum-X800平台包含Spectrum SN5600交换机和NVIDIA BlueField-3 SuperNIC,专为多租户环境打造,能够为多租户生成式AI云和大型企业级用户提供各种至关重要的先进功能,进而缩短AI解决方案的开发、部署和上市时间。

在软件方面,NVIDIA提供面向万亿参数级AI模型性能优化的网络加速通信库、软件开发套件和管理软件等全套软件方案。其中的NVIDIA集合通信库(NCCL)可将GPU的并行计算任务扩展到Quantum-X800网络,利用其基于SHARPv4的强大网络计算能力和对FP8的支持,为大模型训练和生成式AI提供超强的性能。

处理万亿参数模型NVIDIA DGX SuperPOD AI超级计算机

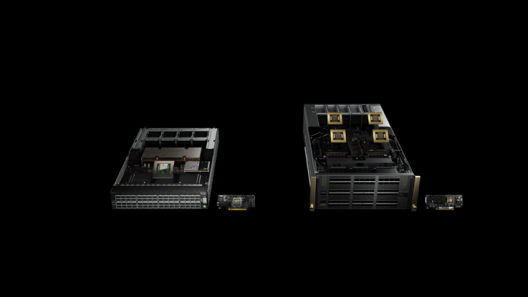

基于GB200 Grace Blackwell超级芯片和最新的网络产品,NVIDIA在GTC 2024上还宣布推出了一台专门用于AI的超级计算机:NVIDIA DGX SuperPOD。

这台NVIDIA DGX SuperPOD计算机基于DGX GB200系统打造而成,每个DGX GB200系统搭载36个NVIDIA GB200超级芯片,共包含36个NVIDIA Grace CPU和72个NVIDIA Blackwell GPU。并且,这些超级芯片通过第五代NVIDIA NVLink连接成一台超级计算机。

除第五代 NVIDIA NVLink网络外,DGX SuperPOD计算机还包括 NVIDIA BlueField-3 DPU,并将支持最新发布的 NVIDIA Quantum-X800 InfiniBand 网络。这个架构可为计算平台中的每块GPU提供高达每秒1800 GB的带宽。

数据显示,在FP4精度下可提供11.5 exaflops的AI超级计算性能和240 TB的快速显存,且可通过增加机架来扩展性能。与NVIDIA H100 Tensor Core GPU相比,GB200超级芯片在大语言模型推理工作负载方面的性能提升了高达30倍。

考虑到功耗和散热问题,全新的DGX SuperPOD采用新型高效液冷机架级扩展架构,能够更好地提高散热效率,确保运行稳定性的同时,降低整体拥有成本。

谈到超级计算机,黄仁勋表示,NVIDIA DGX AI超级计算机是推进AI产业变革的工厂。新一 DGX SuperPOD集NVIDIA加速计算、网络和软件方面的最新进展于一体,能够帮助不同的行业和企业完善并生成自己的AI。

写在最后:无论是史上最大的GPU芯片,还是能够处理万亿参数的最强计算机,以及拥有800Gb/s端到端吞吐量的网络平台,每一款产品都有着非常亮眼的参数。可以说,本届GTC上发布的每一款硬件产品,都吸引了大众的眼球。当然,这些产品在生成式AI应用场景下的表现如何,让我们拭目以待吧!

Recommend

About Joyk

Aggregate valuable and interesting links.

Joyk means Joy of geeK