通用图大模型HiGPT:一己之力建模任何图结构关系!来自港大数据智能实验室&百度

source link: https://www.qbitai.com/2024/03/130016.html

Go to the source link to view the article. You can view the picture content, updated content and better typesetting reading experience. If the link is broken, please click the button below to view the snapshot at that time.

通用图大模型HiGPT:一己之力建模任何图结构关系!来自港大数据智能实验室&百度

GraphGPT原班人马出品

汤嘉斌 投稿

量子位 | 公众号 QbitAI

一个模型建模所有图结构关系——

香港大学数据智能实验室最新图结构大模型来了。

它叫HiGPT,由GraphGPT原班人马打造。

后者是将图数据与大模型结合的代表方法之一:

通过用图指令微调将图数据与大模型对齐,在下游任务上一度彰显了惊人的泛化性(Zero-Shot)。

不过,GraphGPT仅针对同质图进行了验证,对于生活中更常出现的异质图 “无能为力”。

简而言之,也就是只擅长简单的任务,复杂的还不行。

(异质图:即结点和边的类型更多样。例如社交网络中用户、帖子和评论之间的关系)

基于此,HiGPT诞生,专攻复杂的异质图学习任务,并真正做到了“一个模型,建模任意关系类型”。

由此,一个通用图大模型就诞生了。

以后我们无论是用大模型做社交网络分析、生物信息还是城市计算这些常见图任务,都能hold更多有难度的case了。

Hi,异质图GPT

想要一个模型实现所有异质结构关系的泛化,面临的挑战有三:

C1. 关系类型异质性偏移:

当前几乎所有的异质图神经网络在建模异质关系是常常会为单个异质图的每个节点和关系类型定制参数,这使得当不同异质图之间结点和关系类型发生改变时,即关系类型异质性偏移,zero-shot的泛化将非常困难。

C2. 复杂异质图结构:

由于异质图存在多种多样的异质结点和关系类型,如何让大语言模型具有分辨不同异质类型的能力,从而提取有用的异质结构信息,进一步完成各种下游任务的泛化也是需要考虑的问题。

C3. 模型微调的数据稀缺:

在图学习研究社区,数据不足或者数据确实问题是公认的挑战。如何在有限的监督信号下学习得到更强泛化的模型也是不可避免的问题。

那么,具体来看看,HiGPT是如何实现的。

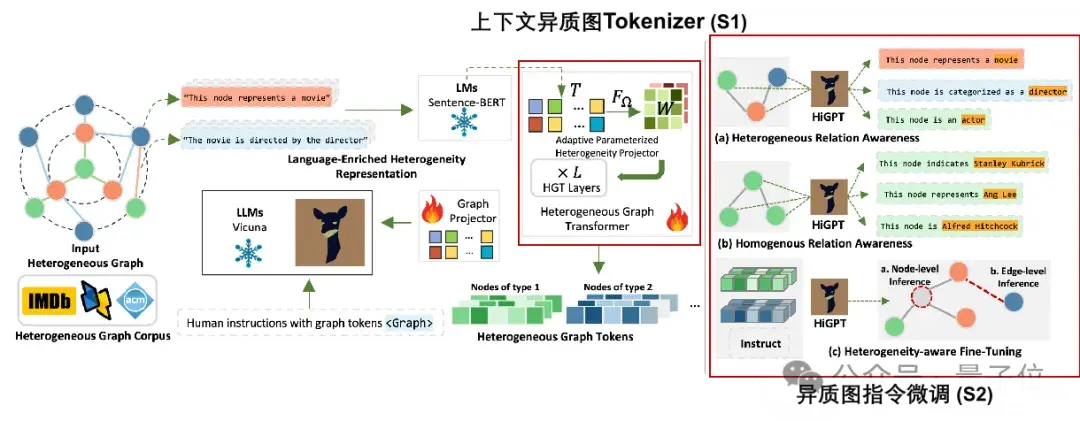

该方法的框架图如下所示:

针对C1,C2,C3,作者分别提出S1,S2,S3对应解决:

S1. 上下文异质图Tokenizer。

为了在具有不同节点和边类型的各种异质图场景中实现泛化性,我们引入了上下文异质图Tokenizer。

这个Tokenizer捕捉到了不同异质图中存在的各种语义关系,提供了一个统一的建模方法。

它包括两个重要组件:1)上下文参数化异质性投影器:利用自然语言对不同的节点和边类型进行编码;2)参数分配器:动态地为Tokenizer分配定制的参数。

为了优化性能并将Tokenizer无缝集成到HiGPT框架中,作者采用了轻量级的文本-图对比对齐范式来预训练Tokenizer。

预训练之后,直接将Tokenizer集成到HiGPT中,经过预训练的Tokenizer提高了其语义建模能力,并确保了其在整个模型架构中运行平稳。

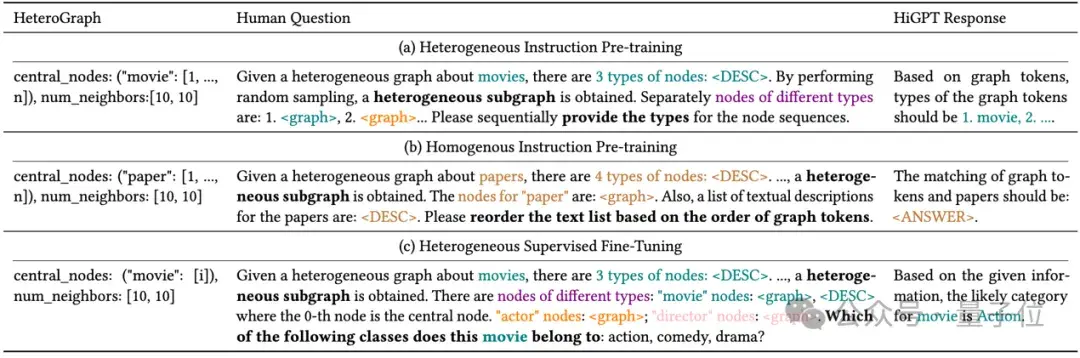

S2. 异质图指令微调。 作者引入了一种新颖的异质图指令微调框架,该框架引入了跨类型和同类型token匹配任务来微调大语言模型。

框架专门针对提高大语言模型对异质关系感知和同质关系感知的理解。通过这些任务,作者的目标是增强大语言模型在以下方面的能力:

(i)区分不同类型的图tokens(异质关系感知),(ii)区分相同类型的图tokens直接的对应关系(同质关系感知),以及(iii)在下游任务中有效利用异质关系感知和同质关系感知能力。

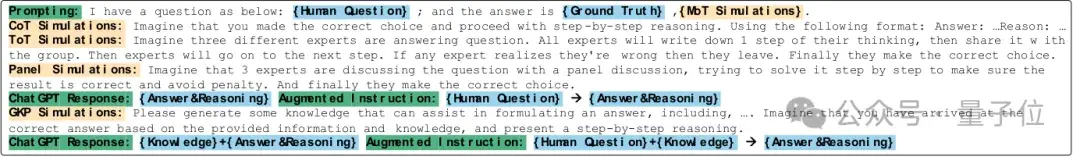

设计的指令微调任务的指令模版如下表所示:

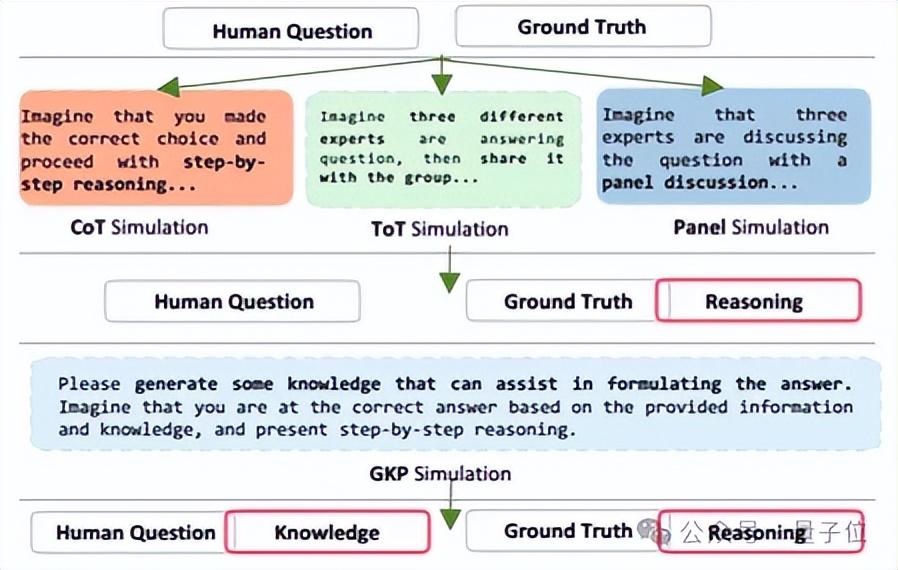

S3. Mixture-of-Thought指令增强。 为了解决异质图学习下游任务监督信号不足的问题,作者引入了一种用于增强图指令的新机制Mixture-of-Thought(MoT),即混合各种提示技术结合使用。

这种集成使我们能够生成一组多样化和全面的信息丰富的下游任务指令。

通过无缝地将这些增强的图指令集成到框架中,将有效地解决数据稀疏性的挑战。

具体地,作者结合了四种常见的提示技术,即Chain-of-Thought,Tree-of-Thought,PanelGPT和Generated Knowledge Prompting,通过ChatGPT模拟正确的推理结果,最后将多样的推理结果作为下游任务指令微调的训练数据,做到不增加监督信号的情况下增加(增强)了训练数据规模。

工作流程如下图所示:

具体提示与增强指令模版如下图所示:

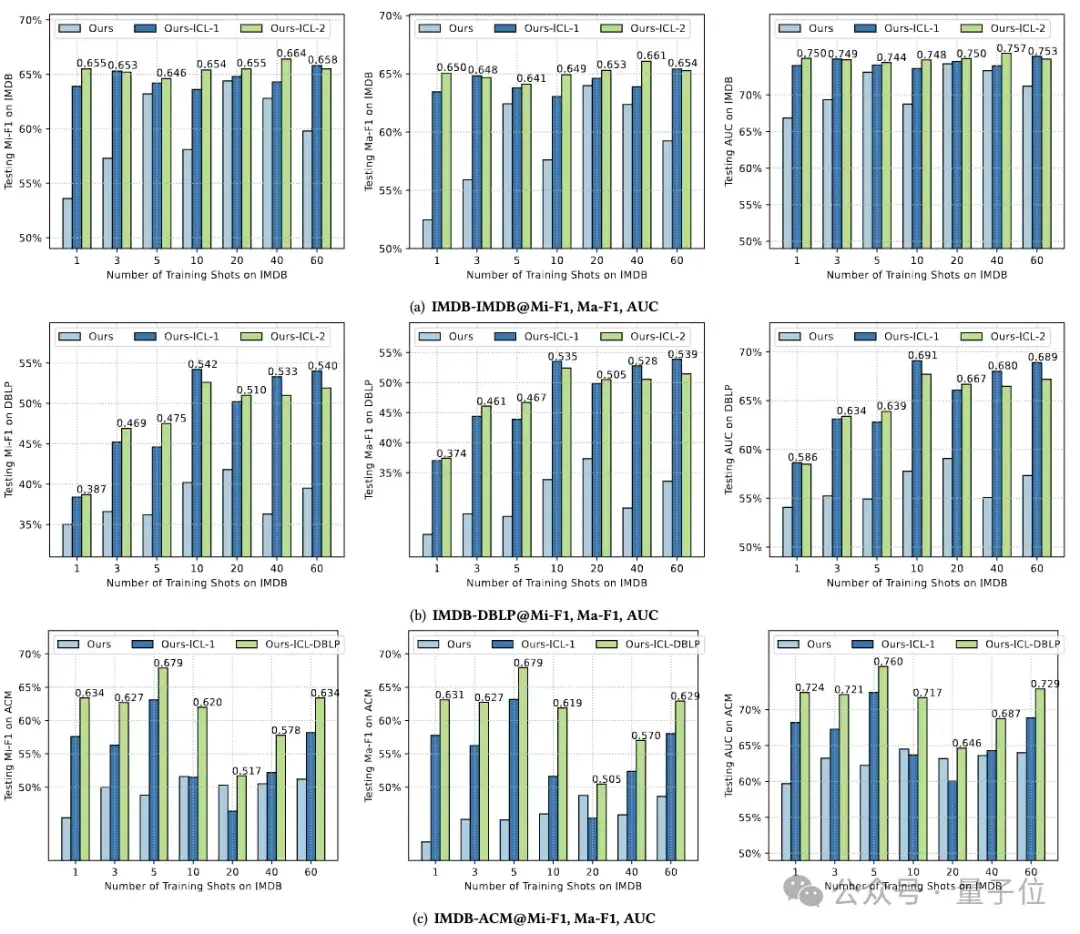

HiGPT不仅在监督学习(Supervised)和零样本(Zero-shot)学习中超越了一众主流模型:

同时,作者探索了用训练得到的HiGPT进行图上下文学习(Graph In-Context Learning),然后惊奇地发现,在不优化模型参数,仅仅添加图问答示例就可以使得在1 shot训练的模型打败60 shot模型。

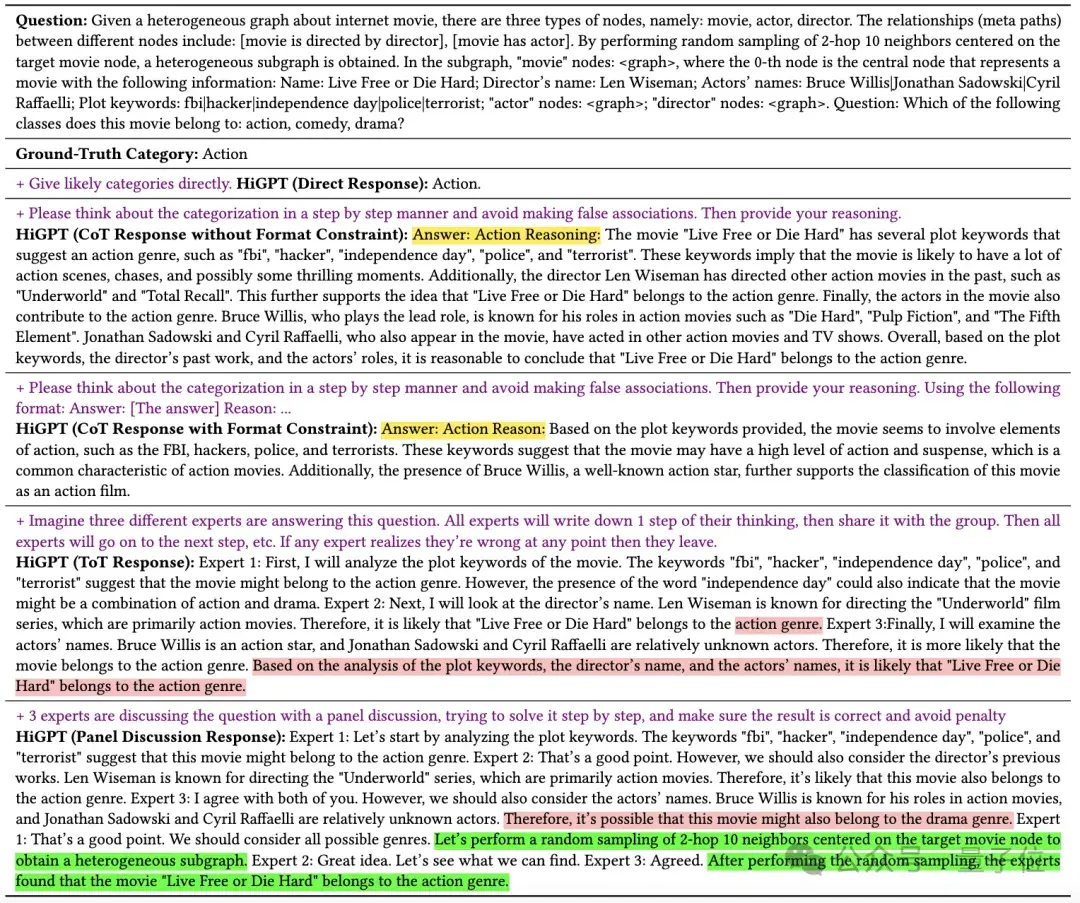

进一步的案例分析作者发现HiGPT不仅可以根据问题灵活调整回答推理模式,甚至会从主动从图数据角度分析问题,有了一定的图-意识(Graph-Awareness)。

本项研究由港大数据智能实验室的GraphGPT原班人马以及百度等机构的研究人员完成。

港大数据智能实验室由黄超老师带领,在图学习,推荐系统,城市计算等诸多数据挖掘领域都有持续的探索,尤其是近期与大语言模型的诸多开源工作:GraphGPT,HiGPT,LLMRec,RLMRec,UrbanGPT,GraphEdit等。

欢迎大家来Github进一步探索!

传送门:

论文:https://arxiv.org/abs/2402.16024

代码:https://github.com/HKUDS/HiGPT

项目网站:https://higpt-hku.github.io/

https://sites.google.com/view/chaoh/group-join-us

https://github.com/HKUDS

Recommend

About Joyk

Aggregate valuable and interesting links.

Joyk means Joy of geeK